随着人工智能技术的不断发展,视觉与文本数据的融合成为了一项复杂的挑战。传统的模型往往难以准确解析表格、图表、信息图和图示等结构化视觉文档,这一限制影响了自动内容提取和理解能力,进而影响了数据分析、信息检索和决策等应用。面对这一需求,IBM 近期发布了 Granite-Vision-3.1-2B,一款专为文档理解设计的小型视觉语言模型。

Granite-Vision-3.1-2B 能够从各种视觉格式中提取内容,包括表格、图表和图示。该模型基于精心挑选的数据集进行训练,数据来源包括公共和合成源,能够处理多种文档相关的任务。作为 Granite 大型语言模型的改进版,它将图像和文本两种模态进行了整合,从而提升了模型的解读能力,适用于多种实际应用场景。

该模型由三个关键组件组成:首先是视觉编码器,它使用 SigLIP 高效处理和编码视觉数据;其次是视觉语言连接器,这是一个带有 GELU 激活函数的双层多层感知器(MLP),旨在连接视觉信息与文本信息;最后是大型语言模型,基于 Granite-3.1-2B-Instruct,具备128k 的上下文长度,可以处理复杂和庞大的输入。

在训练过程中,Granite-Vision-3.1-2B 借鉴了 LlaVA,并结合了多层编码器的特性,以及在 AnyRes 中更密集的网格分辨率。这些改进增强了模型理解详细视觉内容的能力,使其能够更准确地执行视觉文档任务,例如分析表格和图表、进行光学字符识别(OCR)以及回答基于文档的查询。

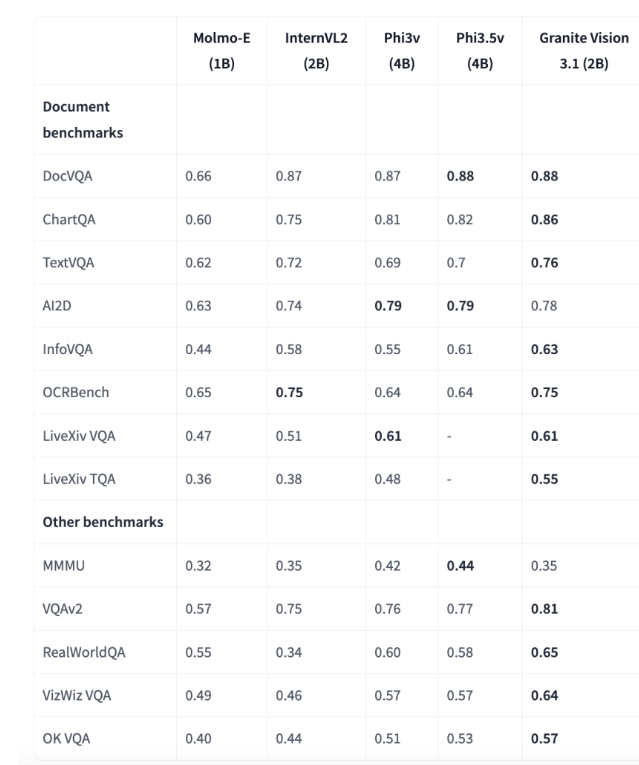

评估结果显示,Granite-Vision-3.1-2B 在多个基准测试中表现优秀,尤其在文档理解方面。在 ChartQA 基准测试中,该模型的得分达到0.86,超越了其他参数在1B-4B 范围内的模型。在 TextVQA 基准测试中,得分为0.76,展现出在解析和回答图像中嵌入的文本信息方面的强大能力。这些成果凸显了该模型在企业应用中对精确视觉和文本数据处理的潜力。

IBM 的 Granite-Vision-3.1-2B 代表了视觉语言模型的一次重要进步,提供了一个均衡的视觉文档理解方案。其架构和训练方法使其能够高效地解析和分析复杂的视觉和文本数据。由于其对变换器和 vLLM 的原生支持,该模型可以适应多种用例,并能在诸如 Colab T4等云环境中部署,为研究人员和专业人士提供了一种增强 AI 驱动文档处理能力的实用工具。

模型:https://huggingface.co/ibm-granite/granite-vision-3.1-2b-preview

划重点:

🌟 Granite-Vision-3.1-2B 是 IBM 推出的专为文档理解设计的小型视觉语言模型,能够处理多种视觉格式的内容提取。

📊 模型由视觉编码器、视觉语言连接器和大型语言模型三部分组成,提升了对复杂输入的理解能力。

🏆 在多个基准测试中表现优异,特别是在文档理解领域,展现出强大的企业应用潜力。