BitNet 是微软推出的一个高效的大语言模型(LLM)推理框架,专为“超低比特模型”设计,目标是在普通 CPU 上也能运行数十亿乃至百亿参数的大模型**,而无需依赖 GPU 或高性能服务器。

它的核心技术是用 “1.58-bit 的权重表示方式” 来压缩模型参数,大幅减少模型体积、运算成本和功耗。

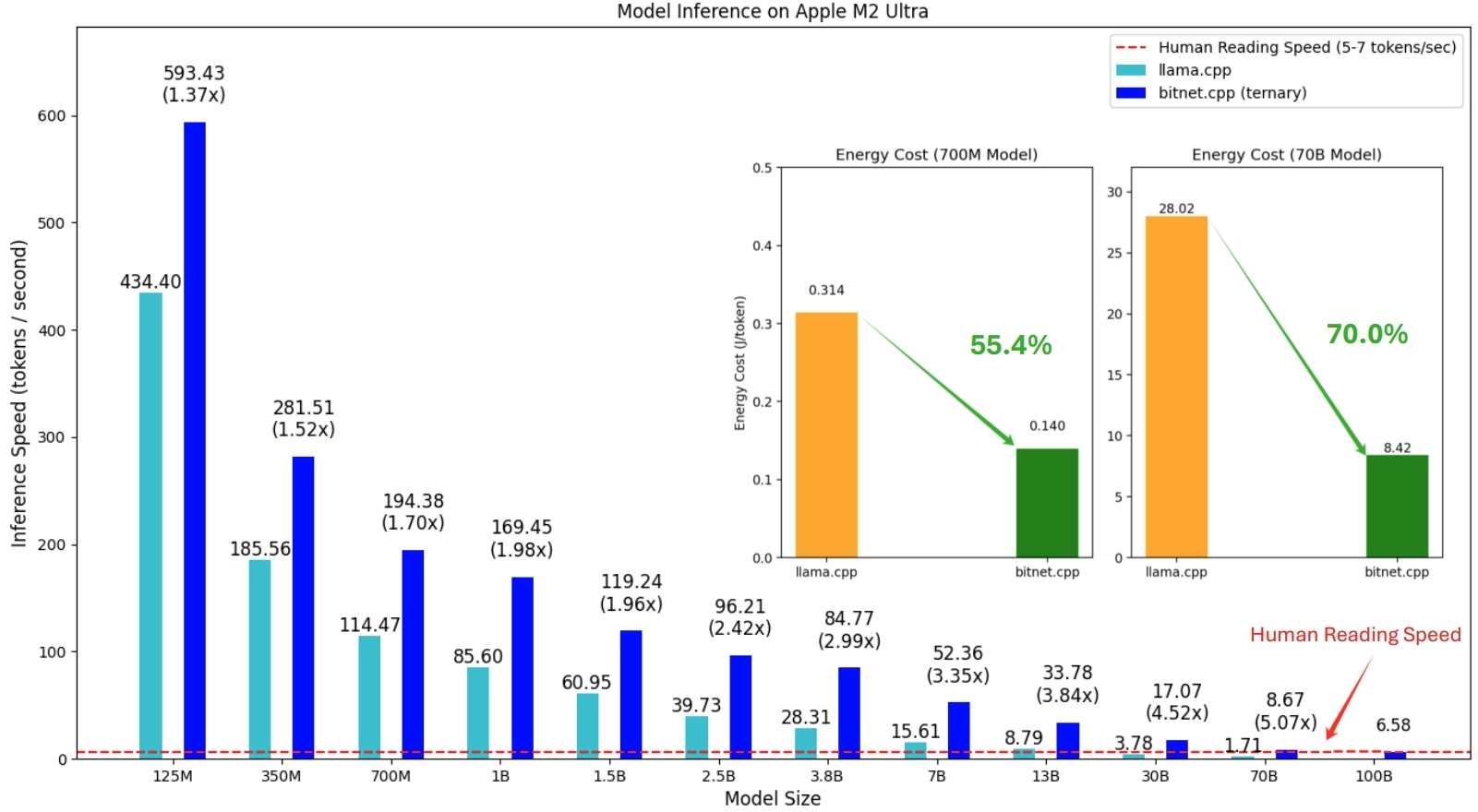

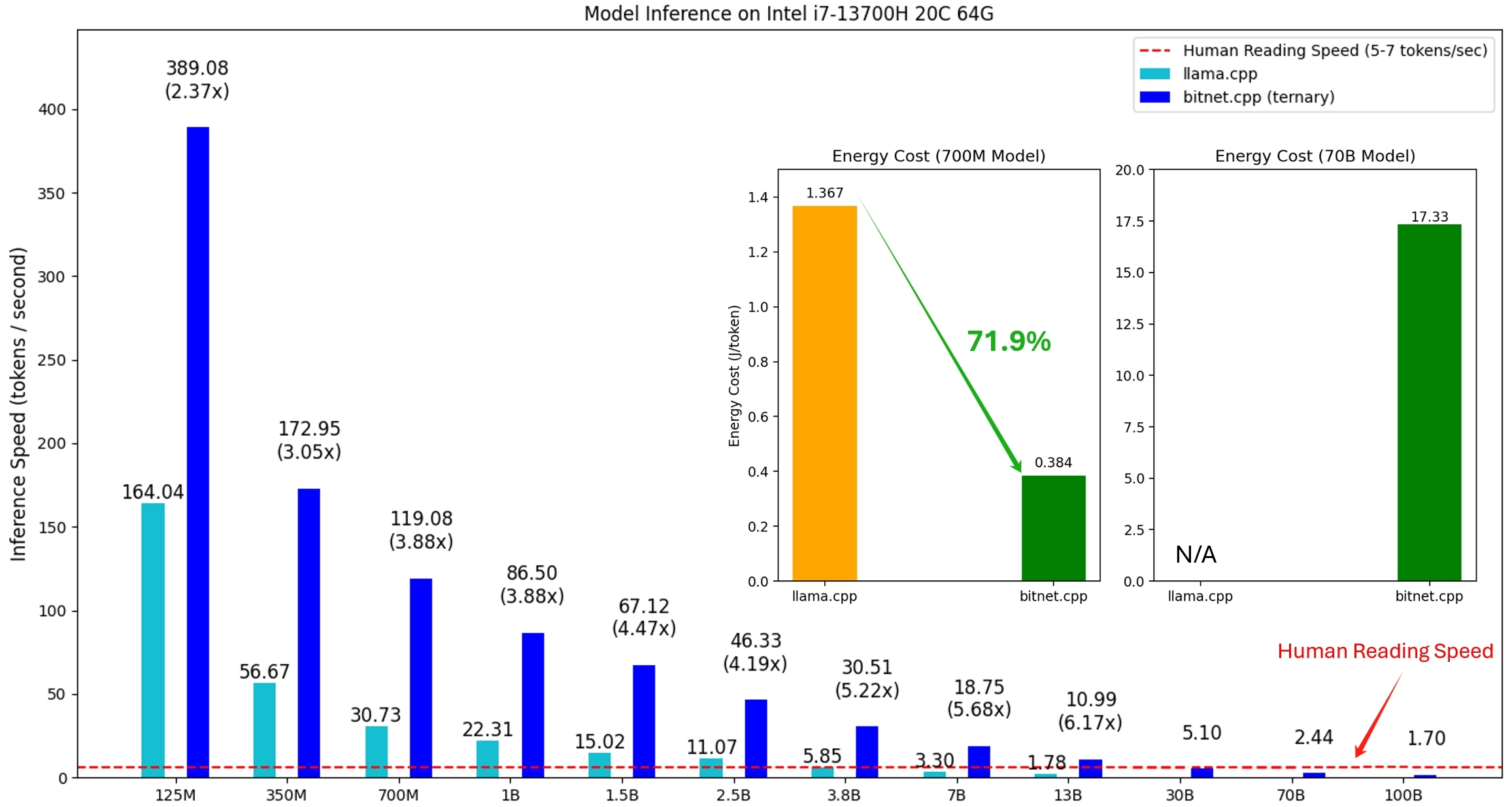

- 支持在 ARM 和 x86 CPU 上运行 1 位 LLMs 模型,实现 1.37 倍到 6.17 倍的加速,并大幅降低能耗

- 可在单个 CPU 上运行 100B 的 BitNet b1.58 模型,达到与人类阅读速度相当的速度

- 提供了丰富的 API 和工具,方便开发者集成和使用

📌 一句话总结:BitNet 是一个能让大模型“轻量运行”的工具,主打“极致压缩 + 高效推理”。

什么是 “1.58-bit LLM”?

💡 通俗解释:

传统 LLM(像 GPT-3)每个模型参数是用 32 位浮点数(FP32)表示,占空间很大。

后来的压缩方案尝试把每个参数改成 8-bit、4-bit 甚至 2-bit。但 BitNet 更进一步:

✅ 把每个参数“量化”为 1.58 bit 的三值(Ternary)表示,也就是每个参数的值只有三个可能:正的、负的、或零。

这样压缩效果惊人,但仍能保留相当一部分模型原有的表达能力。

BitNet 的核心能力有哪些?

1. 支持大模型低比特推理

- 最大支持 100B 参数级别模型(如 BitNet-100B)

推理速度接近人类阅读速度(5~7 tokens/sec)

👉 在 CPU 上,这个性能已经非常可用了!

2. 高效 CPU 推理优化

- 专门为 x86 和 ARM CPU 设计了高性能内核(Kernels)

速度提升:

- ARM CPU:最高快 5 倍

- x86 CPU:最高快 6 倍

能耗降低:

- 最低减少 55%

- 最高可达 82%

3. 多平台适配(未来支持 GPU/NPU)

目前支持:

- x86 架构 CPU(如 Intel/AMD 台式机)

- ARM 架构 CPU(如苹果 M 系列、树莓派)

未来计划支持:

- GPU(如 NVIDIA)

- NPU(如华为昇腾、EdgeTPU)

4.继承 llama.cpp 框架,兼容性强

- BitNet 基于 llama.cpp 设计,便于迁移与扩展。

- 支持多种量化格式:i2_s、tl1、tl2

核心推理代码在 bitnet.cpp,以 C++ 编写,稳定、跨平台,依赖简单。

官方提供的支持模型

BitNet 不光是一个框架,它还提供了多个量化后可直接使用的模型,包括:

✅ 技术上的意义:

BitNet 推动了“大模型轻量化”的极限边界。

传统大模型(GPT-3、LLaMA)虽然功能强大,但有几个致命问题:

- 模型太大,动辄几十GB

- 运行要靠昂贵的 GPU

- 普通用户根本用不起

而 BitNet 用创新的 1.58-bit 表示方式,把模型压缩到原来的 1/10~1/20 大小,还能保持不错的性能,让模型:

- 可以在 CPU 上跑

- 不需要高端硬件

- 速度也不慢(5~7 tokens/秒)

这就像:过去只能在超级计算机上运行的 GPT,现在普通电脑也能用,这是大语言模型民主化的重要一步。

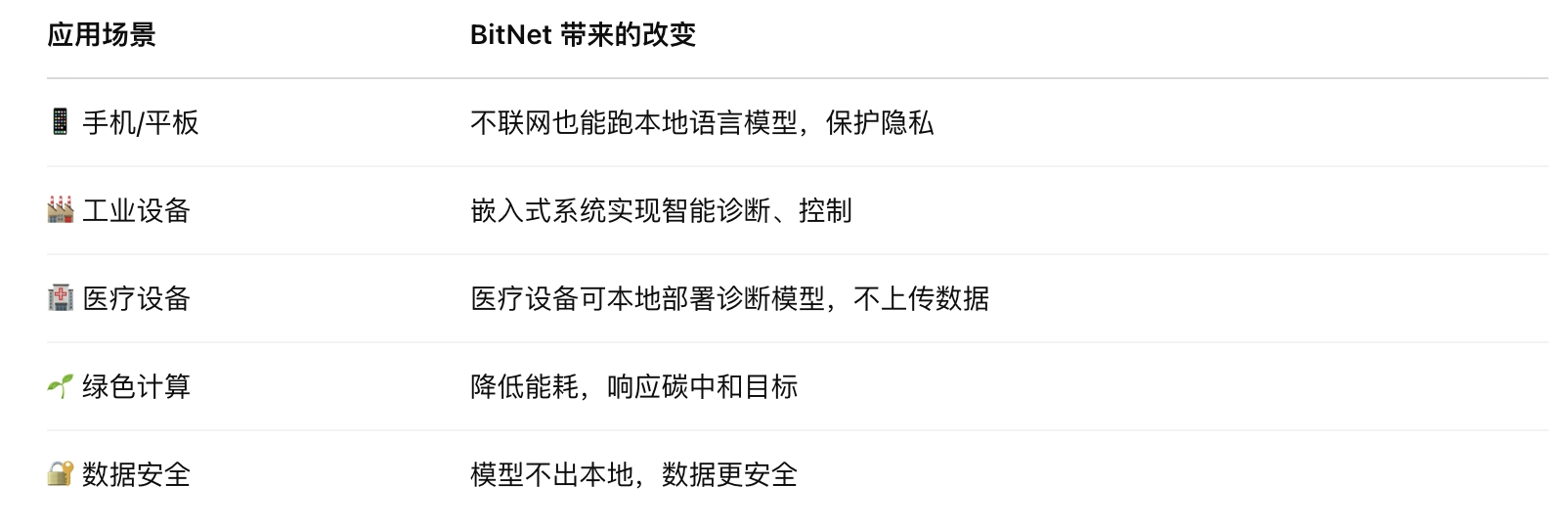

✅ 应用上的意义:

BitNet 让大模型真正走向边缘设备与本地部署,打开了很多新场景:

✅ 趋势上的意义:

BitNet 是 低比特大模型推理(1-bit / 2-bit / 4-bit)趋势的重要代表,代表未来大模型的几个方向:

- 大而轻:模型参数多,但运行轻快

- AI下沉:模型不再只能云端,进入本地设备

- 绿色AI:高效能低功耗,推动“可持续AI”

- 边缘智能:模型部署在设备侧,实时、离线运行

🧭 所以,BitNet 是推动 AI 从“中心化云计算”向“去中心化设备端智能”演进的重要技术。

如何使用 BitNet?(简要操作流程)

官方文档非常详细,下面是大致步骤:

① 安装环境

``` conda create -n bitnet-cpp python=3.9 conda activate bitnet-cpp pip install -r requirements.txt

```

② 下载模型

``` huggingface-cli download microsoft/BitNet-b1.58-2B-4T-gguf --local-dir models/BitNet-b1.58-2B-4T

```

③ 初始化运行环境

``` python setupenv.py -md models/BitNet-b1.58-2B-4T -q i2s

```

④ 执行推理(生成文本)

``` python run_inference.py -m models/...gguf -p "你是谁?" -cnv

```

七、BitNet 的潜在应用场景

🎯 本地部署大模型

- 在不联网环境下运行 LLM,比如在医院、工业现场、科研车间

🎯 嵌入式设备

- 树莓派、移动终端、智能家电都能运行轻量 LLM

🎯 节能绿色 AI

- 大幅减少 LLM 的运行功耗,符合碳中和、可持续计算趋势

🧠 总结一句话

BitNet 让大语言模型变小、变快、变绿色,同时保持强大的语言理解与生成能力。

它开启了一个新的可能:让几年前只能在超级计算机运行的模型,在你电脑上也能顺畅运行。

GitHub:https://github.com/microsoft/BitNet

更多详情,请参阅技术报告