AI 作为引擎,人类作为方向盘

特别感谢 Devansh Mehta、Davide Crapis 和 Julian Zawistowski 对本文的反馈与审阅,也感谢 Tina Zhen、Shaw Walters 及其他人的讨论。

如果你问人们,为什么喜欢民主结构(无论是政府、职场还是基于区块链的 DAO),你往往会听到类似的理由:它们避免了权力过度集中;它们给用户提供了强有力的保证,因为不会有某个单一人物可随心所欲地完全改变系统的方向;它们通过汇集众多人的视角和智慧,往往能够做出更高质量的决策。

如果你再问人们,为什不喜欢民主结构,他们也常常会给出一系列相似的抱怨:普通选民通常缺乏足够的专业水平,因为单个选民对结果的影响有限,因此投入大量时间深思熟虑并不划算;投票参与度通常很低(使系统容易被攻击),或者事实上的中心化问题依然存在,因为绝大多数人都只会盲从并复制某位网红或关键意见领袖的观点。

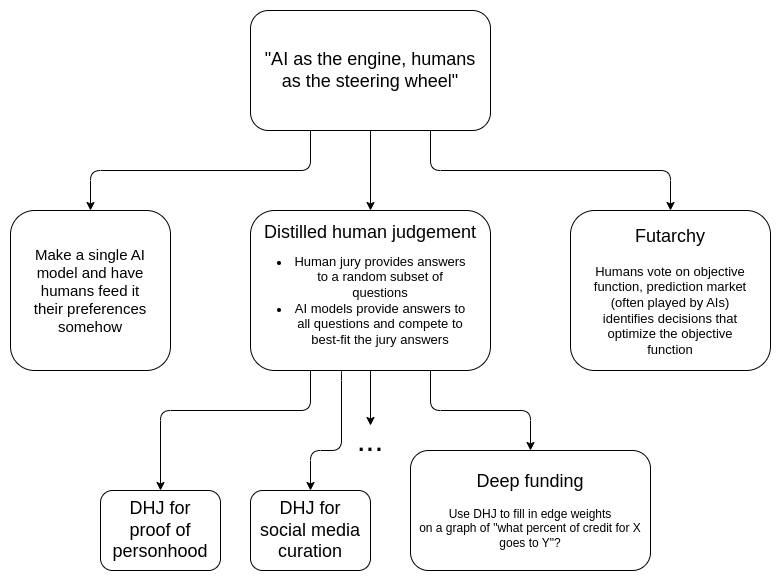

本文的目标是探讨一种新的范式:或许可以利用 AI 来保留民主结构的好处,同时避免它的弊端。即“AI 作为引擎,人类作为方向盘”。在人类这边,只需向系统提供少量但高质量的信息,也许只需几百比特;而由 AI 将这些数据视为“目标函数”,通过大规模决策来尽最大努力满足这些目标。尤其值得探讨的是:能否在不将某单一AI 固化在中心的情况下做到这一点,而是依赖一个任何 AI(或人类与 AI 的混合体)都可以参与竞争的开放市场?

为什么不直接让一个 AI 说了算?

将人类偏好注入基于 AI 的机制最简单方式就是:选择一个 AI 模型,让人类以某种方式向它输入偏好。最直接的例子是:你可以把一个包含群体指令的文本文件放进系统提示(prompt)里。然后你再用各种“代理型 AI 框架”为这个 AI 提供访问互联网的能力,把你所在组织的资产和社交媒体账号钥匙交给它,如此便大功告成。

经过几次迭代,这种方式也许就能满足许多用例需求。我也完全预期,在不久的将来我们会看到各种结构:AI 读取一个群体(甚至实时读取一个群聊)所给出的指令,然后执行相应的动作。

但在某些情况下,让 AI 全权决策并不是理想之选,尤其是那些需要长期存在的机构。对于这类机构来说,一个重要特性是可信中立性(credible neutrality)。我在介绍这个概念的文章中列出了可信中立需要的四大属性:

- 不要在机制中写死特定的人或特定的结果

- 开源并可公开验证的执行方式

- 保持机制的简单性

- 不要过于频繁地变更机制

而对于大语言模型(LLM)(或任何 AI 代理)而言,它在这四点中可谓是全部不符合:

- 0/4。模型的训练过程里,必然带有大量对特定人物与具体结果偏好的编码。有时会导致 AI 在令人意想不到的方向产生偏好。比如最近的一项研究就显示,主流大语言模型更重视巴基斯坦人的生命,而不是美国人的生命(!)。你也可以把它做成“开源权重”(open-weights),但距离真正的“开源”还差得远;我们并不真正知道模型深处藏着什么“魔鬼”。模型本身极其庞大,其复杂度以数百亿比特计,可谓与美国所有法律文本(联邦+州+地方)加起来的可描述复杂度相当。它一点也不“简单”。由于 AI 演进速度极快,你也不得不每隔三个月就得升级一次。

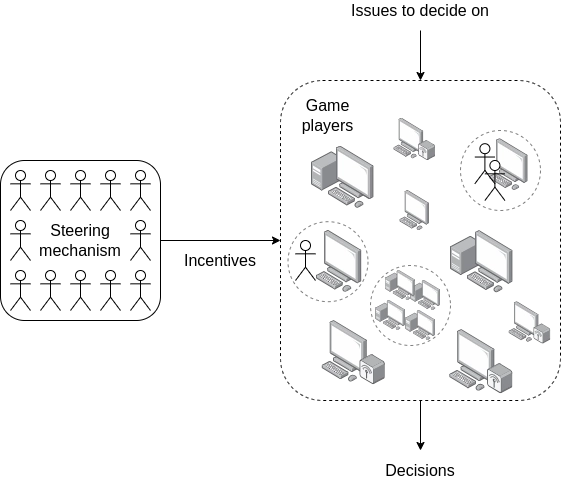

基于这些原因,我更倾向于另一个思路:让一个简单机制成为“游戏规则”,让 AI 成为“玩家”。这其实和“市场”的核心理念如出一辙:市场本质上是相对“愚蠢”的一套财产规则,边界案例则由一个缓慢积累并调整判例的司法体系来裁定;而具体如何运用这些规则,则是由“前沿”的创业者/参与者来提供“智能”和“创造力”。

个人的“游戏玩家”可以是大语言模型、由一群大语言模型交互且能访问各种互联网服务的群体、由人类与 AI 组合而成的联盟,或任何其他方式;对于设计机制的人来说,根本不必过多关心玩家内部细节。最终目标是让这个机制能像一个自动机那样运行——如果机制的目标是决定资助对象,它就应像 Bitcoin 或 Ethereum 的区块奖励那样自动完成一切工作。

个人的“游戏玩家”可以是大语言模型、由一群大语言模型交互且能访问各种互联网服务的群体、由人类与 AI 组合而成的联盟,或任何其他方式;对于设计机制的人来说,根本不必过多关心玩家内部细节。最终目标是让这个机制能像一个自动机那样运行——如果机制的目标是决定资助对象,它就应像 Bitcoin 或 Ethereum 的区块奖励那样自动完成一切工作。

这样的设计有以下好处:

- 避免在机制中固定某个单一模型。这是一个开放市场,很多有偏见的、没偏见的、开源的、闭源的、整合了人类的、乃至“无限猴子”理论式的 AI 都可以参与;机制本身并不加以歧视。

- 机制是开源的。虽然“玩家”并非完全开源,但“游戏”本身是公开的。这种模式其实很常见(例如政党制度或市场)。

- 机制保持简单,因此机制设计者往往难以在其中注入过多偏见。

- 机制无需频繁修改,即使底层的“玩家”架构可能每三个月就得重新设计一遍,机制本身依旧可以保持稳定。

方向盘(人类)提供的少量信息,其核心作用在于真实地表达参与者的目标;信息虽少,但要求高质量。

可以把这一过程理解为利用了“解答难、验证易”之间的非对称性。数独难解却易验,这是同一个道理。我们可以:(1)建立一个开放市场的“求解者”,让他们提供解决方案;(2)由一个人类管理的机制来完成验证工作——这一部分相对来说要简单得多。

Futarchy(期望主义)

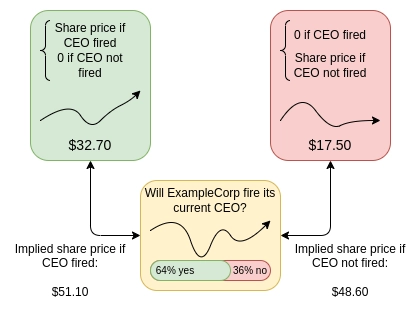

Futarchy 最初由 Robin Hanson 提出,核心口号是“用投票确定价值,用预测市场决定政策”。在该机制中,由投票机制来确定最终所追求的一系列可衡量目标(可以是任何指标,但需可以量化),并将它们合并成一个指标 M。当社区需要在某个决策上(这里先假设简化为“是/否”问题)做出选择时,便设条件市场:让人们对 (i) 若采用“是”时是否被采纳 (ii) 在采用“是”时指标 M 的数值(否则为0),(iii) 在采用“否”时指标 M 的数值(否则为0) 进行押注。通过这三部分,可以判断市场认为“是”或“否”哪个更有利于提升 M 的数值。

企业的股价(或者对于加密货币而言,是代币价格)往往是最常被引用的衡量指标,因为它容易理解、容易测量。但 Futarchy 也支持更多种类的指标:月活用户数、某群体的自报幸福度中位数、去中心化程度的量化指标等等。

企业的股价(或者对于加密货币而言,是代币价格)往往是最常被引用的衡量指标,因为它容易理解、容易测量。但 Futarchy 也支持更多种类的指标:月活用户数、某群体的自报幸福度中位数、去中心化程度的量化指标等等。

Futarchy 最初设计时,AI 还未兴起。但在我们所说的“智能求解、简单验证”的范式下,Futarchy 非常切合。在 Futarchy 中,预测市场里的交易员负责判断某个方案是否能提升未来的 M 值。这很难。但如果他们预测准确则赚钱,预测失误则赔钱。而由“验证者”(即一群人)来投票确认 M 的具体数值(或对 M 的定义进行适当修正,避免被“投机”或“作弊”),再在未来某个时点明确 M 的真实数值——这个工作相对来说要简单得多。

蒸馏的人类判断(Distilled human judgement)

“蒸馏的人类判断”指的一类机制是这样运作的:我们有非常多(假设一百万)个问题需要解答。例如:

- 针对某个项目或任务中的所有参与者,我们需要判断每个人应当分配到多少贡献度?

- 以下哪些评论违反了某个社交媒体平台(或特定子社区)的规则?

- 以下这些 Ethereum 地址,哪些是真实且唯一的人?

- 哪些实体对某环境的美观有正面贡献,哪些有负面影响?

假设我们有一个评审团(jury)可以回答这些问题,但需要投入大量的精力。如果我们让评审团直接回答全部问题,代价会很高。于是我们只让评审团回答其中的一小部分(比方说,一百万个里只回答一百个),有时甚至只是间接发问:比如,“在分配贡献度的问题上,Alice 和 Bob 的对比如何?谁贡献更大?大多少倍?” 评审团可借鉴现实生活中那些行之有效的措施(如拨款委员会、法庭判断(判决的价值),或各类评审方法)。当然,评审团成自己也可以使用 AI 工具来辅助决策。

接下来,任何人都可以提交包含完整答案的列表,即针对所有需要回答的问题都给出一个数值回答。提交者可以也被鼓励用 AI 来完成,但也可以用任何别的方式:AI + 人类混合、能上网的 AI 群体、可以自主雇佣其他人类或 AI 的 AI 系统、赛博猴子……反正如何生成答案不受限制。

然后,我们把“完整列表提交者”的答案与“评审团”针对随机抽取问题所给的答案进行比较,并将与评审团答案最匹配的一部分或某种组合当作最终结果。

蒸馏的人类判断(Distilled human judgement)不同于 Futarchy,但二者也有一些重要相似之处:

- 在Futarchy中,“求解者”在做的是预测;而可以给出“真实数据”来验证这些预测的,则是由评审团提供的指标数值。

- 在蒸馏的人类判断中,“求解者”对一大批问题给出答案;可以用来验证并对他们进行奖励或惩罚的“地面真相”(ground-truth data),则是一小部分问题的高质量参考答案,由评审团提供。

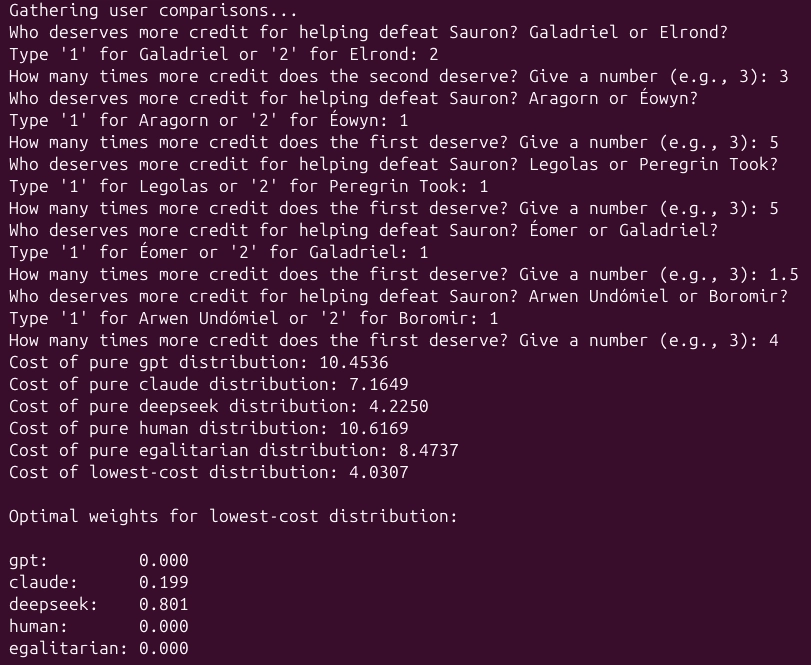

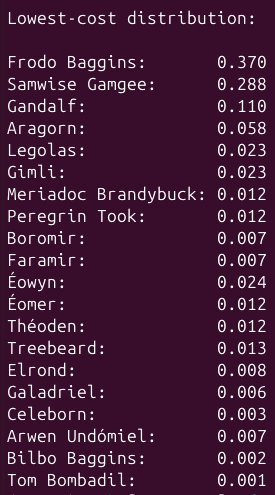

下图是一个将“蒸馏的人类判断”用于贡献度分配的示例,代码见python 示例。脚本会让你来扮演评审团,并在代码里预置一些 AI 生成(以及人类生成)的答案列表。这个机制会找出最符合评审团给出的答案的线性组合。在示例里,最佳组合是 0.199 Claude 的答案 + 0.801 Deepseek 的答案。该组合比任何单一模型更能接近评审团答案。这些系数也可以作为给予提交者的奖励权重。

下图是一个将“蒸馏的人类判断”用于贡献度分配的示例,代码见python 示例。脚本会让你来扮演评审团,并在代码里预置一些 AI 生成(以及人类生成)的答案列表。这个机制会找出最符合评审团给出的答案的线性组合。在示例里,最佳组合是 0.199 Claude 的答案 + 0.801 Deepseek 的答案。该组合比任何单一模型更能接近评审团答案。这些系数也可以作为给予提交者的奖励权重。

在“打败索伦”的设定里,“人类作为方向盘”的概念有两层体现:

- 每个问题都由评审团给出高质量的判断(评审团本身可被视为对结果有技术把控的“专业群体”)。

- 隐含的投票机制来决定“打败索伦”这个目标本身是否正确(比如有人可能会想与索伦结盟,或者把某条重要河流以东的地盘让给他以换取和平)。在另一些“蒸馏的人类判断”用例中,评审团所处理的问题会更直接地体现人类价值观:例如,在去中心化社交媒体平台(或其子社区)里,评审团的工作是随机抽取若干帖子来判定其是否违反社区规则。

在这一范式下,还有一些关键要素需要进一步讨论:

- 如何进行抽样?完整答案提交者需要回答大量问题;评审团则负责高质量评价少数问题。我们需要在选取评审团成员和选定评审团要回答的问题上下功夫,以便让评审团的判断尽可能反映答题者总体水平。专业性与偏见的平衡:具备专业能力的评审员往往在特定领域专长更高,但如果让他们自己选要评审的内容,可能会带来偏见(比如只评价他们熟悉的人),或造成抽样盲区(某些内容无人问津)。如何防止“古德哈特法则”造成的失效?有人可能会利用 AI 工具刷出大量看似华丽却毫无价值的代码,以此骗取贡献度。评审团若发现可以识别并惩戒,但静态的 AI 模型也许无法轻易辨识。一个想法是增加“挑战机制”:任何人都可举报这类滥竽充数,一旦举报成立就必须由评审团来裁定。如果举报方得到评审团支持,就可获得奖励,若评审团否决则需支付惩罚金。

- 如何设计评分函数?目前的 Deep Funding 试点中,做法是向评审团询问:“A 与 B,谁贡献更大?大多少倍?” 然后用一个类似score(x) = sum((log(x[B]) - log(x[A]) - log(juroratio)) ** 2 for (A, B, jurorratio) in jury_answers)的函数来计算偏差,即观察完整列表(x 提交的答案)给出的 A、B 之比与评审团给出的之比差距多大,并以它的平方(在 log 空间中)作为惩罚。这里之所以引入 log,是希望平衡比率的误差。当然,评分函数有很多种设计方式,与向评审团提出的问题形态紧密相关。

- 如何奖励完整答案的提交者?理想情况下,我们希望能给多位提交者一些正向激励,避免最后只剩一家独大。但同时要确保一个人无法通过提交多份近似答案(或略作修改)来重复领取奖励。一种有前景的方案是,直接计算若干提交答案的线性组合(系数非负且和为 1),使其最接近评审团答案;然后按这些系数分配奖励。还可能有其它方法。

总的来说,我们的目标就是把现实生活中相对有效、相对低偏见的人类判断机制(类似真实世界的拨款委员会、法庭、评审体系——其中常见的做法是让两方辩论、法官裁决,以对抗式结构尽量呈现充分信息)与开放的 AI 市场结合起来,让这些 AI 起到“廉价而高保真预测器”的作用。(与“大模型蒸馏”在技术上的思路也类似。)

深度资助(Deep funding)

深度资助(Deep funding)就是把“蒸馏的人类判断”运用在“为图中边缘的权重打分”这类场景:每条边的权重代表“项目 X 的贡献有多少应当归功于人物/项目 Y”。

为了更直观说明,我们直接来看一个例子:

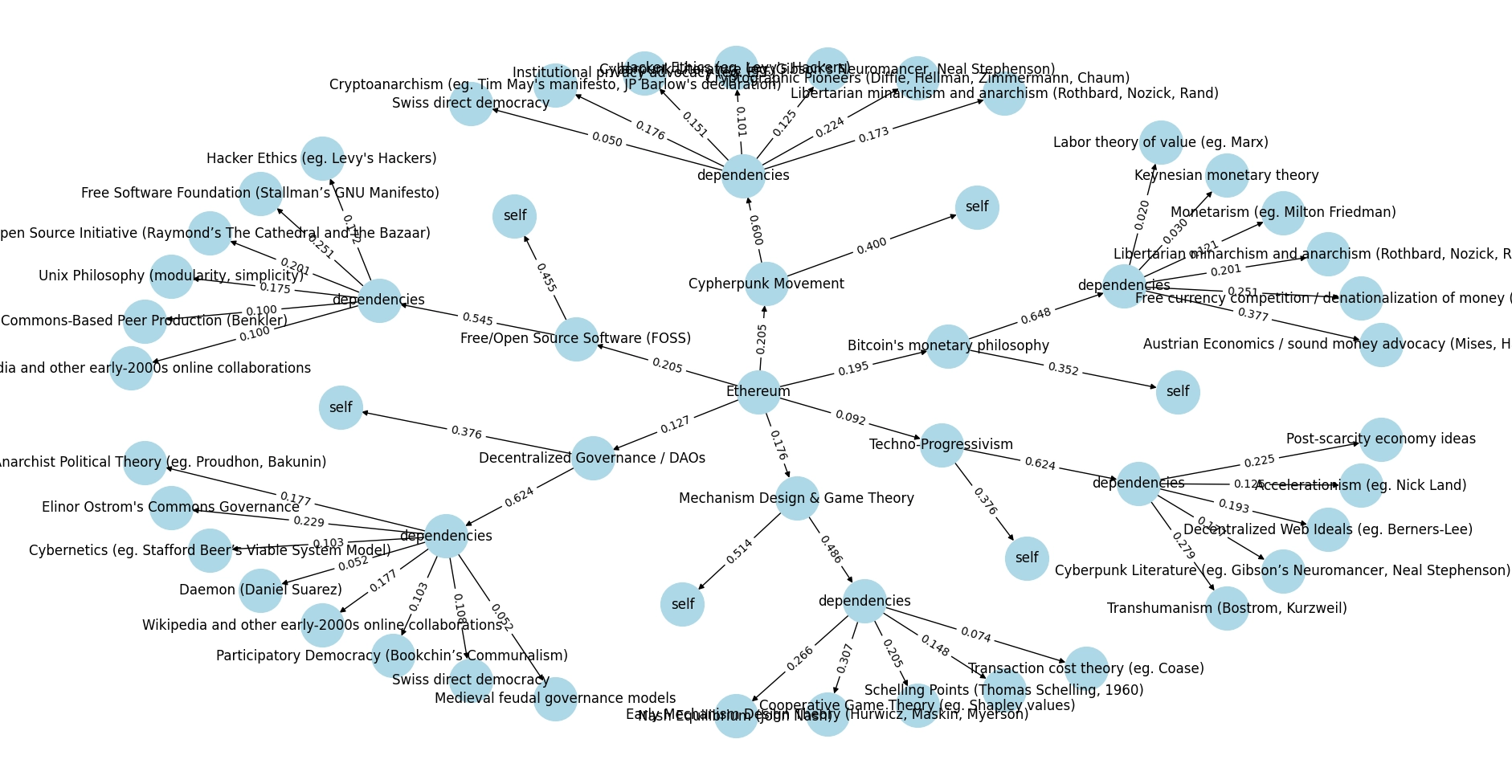

下面展示的是一个两级深度资助的示例,阐述 Ethereum 的思想起源,示例见python 代码。

下面展示的是一个两级深度资助的示例,阐述 Ethereum 的思想起源,示例见python 代码。

假设我们的目标是分配对 Ethereum 哲学产生影响的贡献度。比如,在示例中有如下结果:

- “Cypherpunk 运动”在这条链路中占比 20.5%,“技术进步主义(Techno-Progressivism)”占 9.2%。

- 对于“Cypherpunk 运动”本身,我们还要问:它有多少是“原创”(自己贡献),多少来自上游依赖?在示例中,40% 来自自身(即新贡献),60% 来自它所继承的思想。

- 再往上回溯,“自由意志主义(Libertarian)”与“无政府主义(anarchism)”对 Cypherpunk 运动的贡献度为 17.3%,而“瑞士直接民主”只占 5%。

- 但注意到“自由意志主义与无政府主义”同时也影响了 Bitcoin 的货币哲学,因此它们对 Ethereum 的影响有多条路径。

- 最后要算它对 Ethereum 的整体贡献,可以把每条路径上的权重相乘再相加。举例: 0.205×0.6×0.173+0.195×0.648×0.201≈0.04660.205 \times 0.6 \times 0.173 + 0.195 \times 0.648 \times 0.201 \approx 0.0466 所以,如果你想给与 Ethereum 的哲学起源相关的所有学说捐赠 100 美元,那么按照这个模拟,“自由意志主义与无政府主义”大约应得到 4.66 美元。

这种方法适用于那些“基于前人工作”的领域,并且前后依赖关系比较清晰。典型如学术界(文献引用图谱)和开源软件(库依赖及分叉)。

理想中的深度资助机制可以维护一张全球性的依赖图:任何对某项目感兴趣的资助方只需向对应节点的地址打款,资金就会按图中边的权重自动递归地向上游传播,直至所有间接依赖都被酬谢到。

我们还可以设想,一个去中心化协议直接内置了深度资助模块来分发其原生代币。协议通过内置治理选出评审团,让评审团参与深度资助机制,而协议会自动把新发行的代币打到代表该协议自身的节点。这种方式相当于程序化地回馈对协议作出直接或间接贡献的所有个人或项目,类似于 Bitcoin 或 Ethereum 通过区块奖励给予挖矿者酬劳的机制。通过调整图中边的权重,评审团也就能持续定义他们认为有价值的贡献形式。这种机制或可作为一种去中心化、可持续的长期激励模式,替代传统的挖矿、预售或一次性空投。

隐私保护

在很多场景下,要对上述问题做出高质量判断,需要访问一些私密信息:组织的内部聊天记录,社区成员私下提交的资料等。对于中小型组织,如果“只用一个 AI”来处理,那就比较容易把这些隐私数据给它;但如果要把问题向所有人公开,就会泄露隐私。

要在“蒸馏的人类判断”或“深度资助”中使用这类私密信息,我们需要用加密技术让 AI 可以安全地访问隐私数据。一个可行思路是使用多方安全计算(MPC)、全同态加密(FHE)或可信执行环境(TEE)等,让私密信息只能在受限的环境中被访问,且只输出一个“完整列表提交”的结果给到机制本身。

这样做的代价是,你必须限制提交者的类型:只能是以特定方式运行的 AI 模型(因为人类不允许直接查看私密数据),而且这些模型也必须在某种特殊“基底”里运行(例如 MPC、FHE 或可信硬件)。相关研究还需进一步探索,看看能否在可行性和效率间取得平衡。

“引擎 + 方向盘”设计的好处

这类设计最显著的优势是:它们允许构建一个由人类投票来控制方向、但又不会让人类因要做海量决策而不堪重负的 DAO。人类的决策既不会像代表委托制那样只有一个维度(因为你可以委托很多细分问题),也不会像常规投票那样事无巨细。相比之下,这种设计能更有效地表达人类的多重偏好。

再者,这些机制还有一“激励平滑”(incentive smoothing)的特质。所谓“激励平滑”,指的是以下两点:

- 扩散(diffusion):投票机制的某个单一决策,不会对任何单个利益主体产生过大的影响。

- 混淆(confusion):投票结果与某个利益主体间的具体关联往往很复杂,不容易计算清楚。

“扩散”和“混淆”这两个术语来源于密码学,它们是加密算法和哈希函数能保持安全的关键要素。

现实中,“法治”是一个典型的“激励平滑”例子:政府的最高层并不直接决策“给 Alice 的公司 2 亿美元”或者“罚 Bob 的公司 1 亿美元”这类具体的事情,而是制定普适规则,交由独立的司法系统来执行。这样一来,直接贿赂或腐败的效益就大大降低。而当政府越过这层机制直接干预时,就更容易出现严重腐败问题。

AI 显然会在未来扮演重要角色,包括在治理领域。但如果让 AI 深度介入治理,人们自然会担心 AI 的偏见、训练过程中的潜在操纵,以及AI 技术迭代如此之快,实际上“让 AI 管理”可能就意味着“让负责升级 AI 的人来做主”。而“蒸馏的人类判断”则提供了另一条路径:我们可以开放一个自由竞争的 AI 市场来承担繁重部分,但仍然让以人为主的民主进程掌控方向。

如果你对这些机制感兴趣,或想深度参与,目前正在进行的深度资助轮次可以在这里找到:https://cryptopond.xyz/modelfactory/detail/2564617。欢迎前往了解并参与。