最近,Salesforce AI 研究团队推出了一款全新的多模态语言模型 ——BLIP-3-Video。随着视频内容的快速增加,如何高效处理视频数据成为了一个亟待解决的问题。这款模型的出现,旨在提升视频理解的效率和效果,适用于从自动驾驶到娱乐等各个行业。

传统的视频理解模型往往是逐帧处理视频,生成大量的视觉信息。这一过程不仅消耗了大量的计算资源,还极大地限制了处理长视频的能力。随着视频数据量的不断增长,这种方法变得愈发低效,因此,找到一种既能捕捉到视频的关键信息,又能减少计算负担的解决方案至关重要。

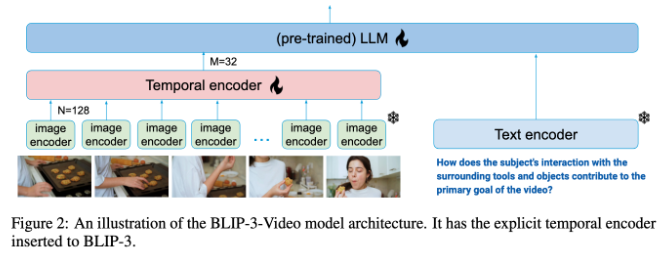

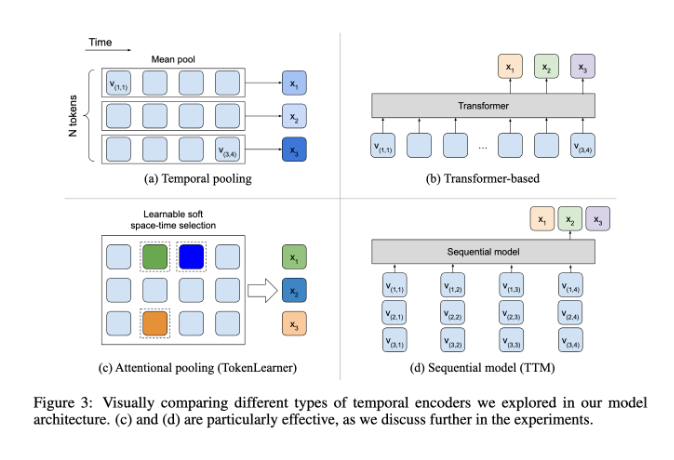

在这方面,BLIP-3-Video 表现得相当出色。该模型通过引入 “时序编码器”,成功将视频中所需的视觉信息数量减少到16到32个视觉标记。这一创新设计大大提高了计算效率,让模型能够以更低的成本完成复杂的视频任务。这个时序编码器采用了一种可学习的时空注意力池化机制,能够从每一帧中提取最重要的信息,将其整合成一个紧凑的视觉标记集。

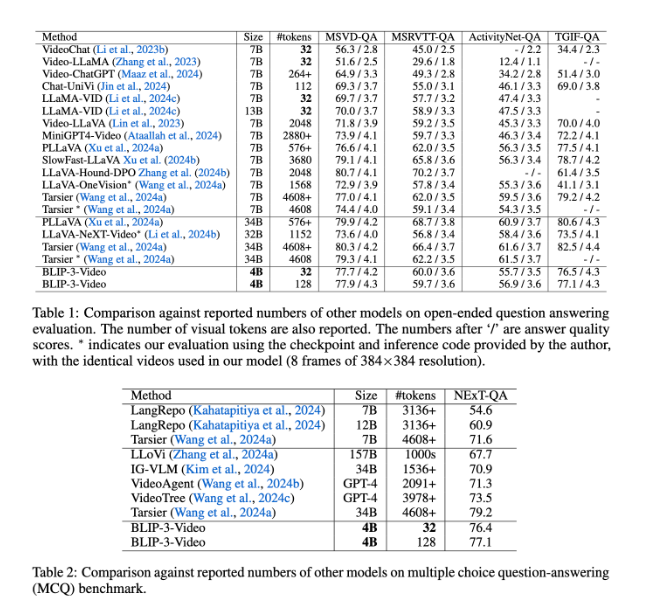

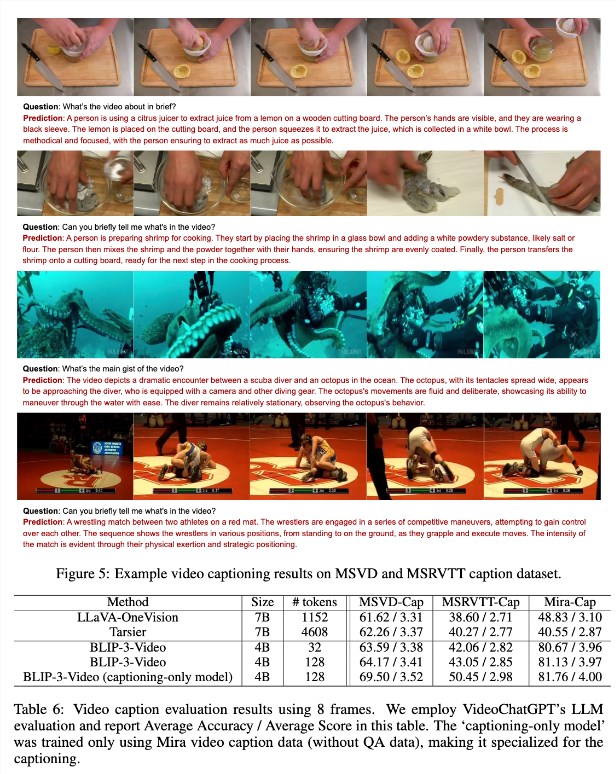

BLIP-3-Video 的表现也非常出色。通过与其他大型模型的比较,研究发现,该模型在视频问答任务中的准确率与顶尖模型相当。例如,Tarsier-34B 模型处理8帧视频需要4608个标记,而 BLIP-3-Video 只需32个标记,就能实现77.7% 的 MSVD-QA 基准得分。这显示出 BLIP-3-Video 在维持高性能的同时,显著减少了资源消耗。

此外,BLIP-3-Video 在多项选择问答任务中的表现同样不容小觑。在 NExT-QA 数据集中,模型取得了77.1% 的高分,而在 TGIF-QA 数据集中,也达到了77.1% 的准确率。这些数据都表明,BLIP-3-Video 在处理复杂视频问题时的高效性。

BLIP-3-Video 通过创新的时序编码器,在视频处理领域开辟了新的可能性。这款模型的推出,不仅提升了视频理解的效率,也为未来的视频应用提供了更多可能性。

项目入口:https://www.salesforceairesearch.com/opensource/xGen-MM-Vid/index.html

划重点:

🚀 * 新模型发布 *:Salesforce AI 研究推出 BLIP-3-Video,多模态语言模型,专注于视频处理。

⚡ * 高效处理 *:采用时序编码器,大幅减少所需视觉标记数量,显著提升计算效率。

📈 * 优越表现 *:在视频问答任务中表现优异,保持高准确率,同时减少资源消耗。