Decart 发布了 MirageLSD,一个前所未有的实时 AI 视频处理工具。它能将任意视频流实时转换为用户设定的视觉风格,且支持极低延迟和无限时长生成。用户无需专业设备即可体验高质量沉浸式体验,从个人变装、直播表演到游戏画面再创造,Mirage 打开了交互式虚拟现实创作的新范式。

- 产品:MirageLSD(Live-Stream Diffusion)实时视频生成 AI 模型

- 特点:将任意视频流(摄像头、视频通话、屏幕、游戏等)实时转化为想象中的视觉世界

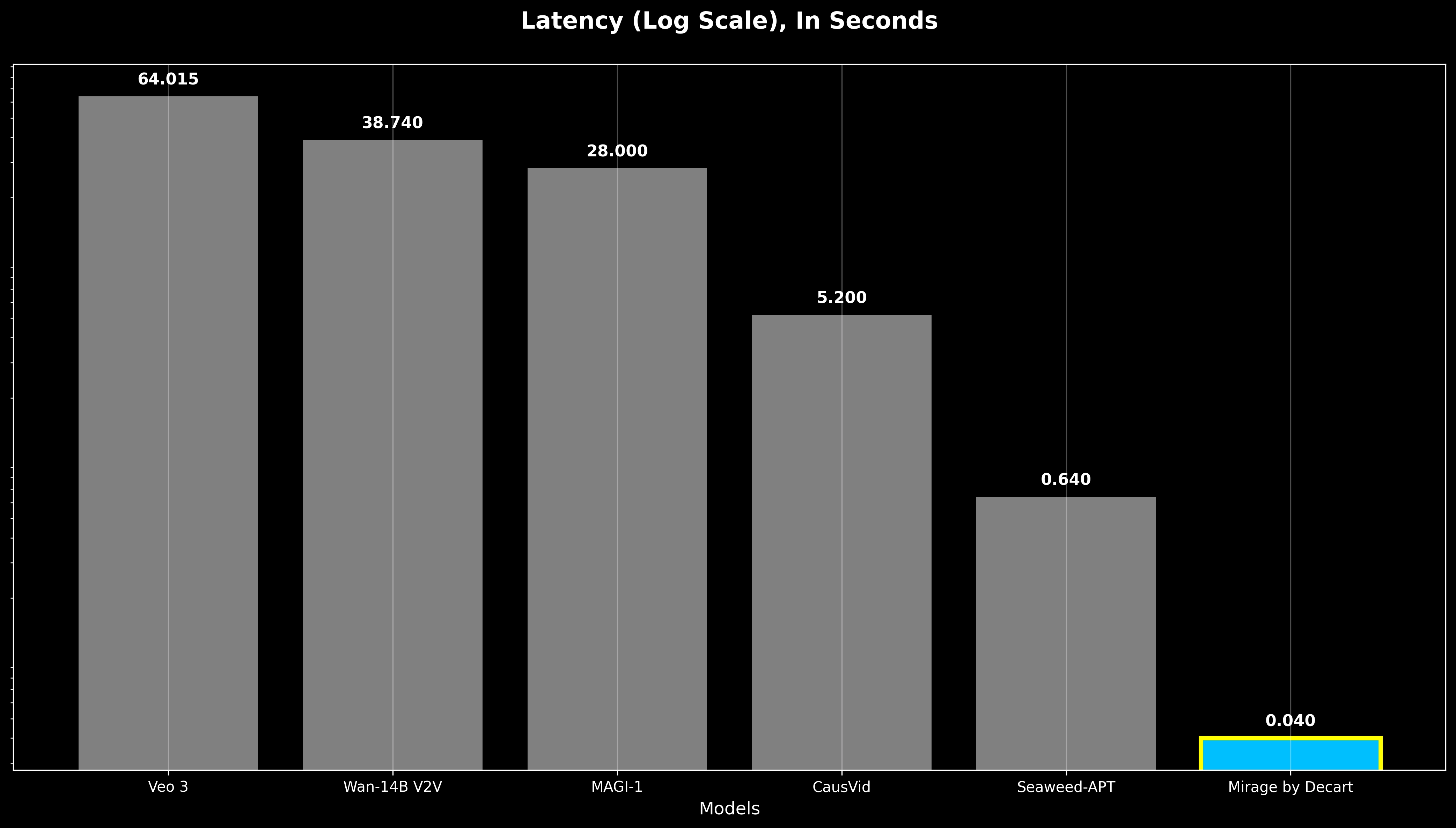

- 性能:运行帧率 24 FPS,延迟低于 40 毫秒

它可以把你正在看的任何视频(比如摄像头画面、视频聊天、打游戏、看电影)实时转换成一个完全不同的世界。就像魔法一样,只需几毫秒(不到 0.04 秒),你的视频就焕然一新。

它能做什么?

实时变装、换脸、换背景:

- 你可以变身成机器人、巫师,背景变成海岛、雪国,甚至中世纪斗兽场

- 拉一下衣服能换造型,挥挥手可以换脸

- 拿起扫帚,它能变成光剑,笔也能变魔杖!

改变你正在看的视频:

- 看健身视频?背景变成古罗马斗兽场

- 看滑雪?背景换成沙漠,视觉体验瞬间升级!

让游戏更酷:

- 由于 Mirage 实时运行,你可以将你最喜欢的视频游戏设置在任何你选择的宇宙中。

- 把任意游戏画面(比如马里奥、GTA)变成奇幻、科幻世界

甚至用一句提示词,自动“生成一款游戏”,你就是游戏设计师!

你可以在 30 分钟内用 vibe-code 制作游戏,让 Mirage 处理图形。从提示到 GTA VII,先于 GTA VI。

创作门槛超低:

- 不需要高端设备

- 扫帚当麦,纸箱当混音台,也能录出大片级效果

技术也很强

- 超级快:每秒生成 24 帧画面,几乎没有延迟

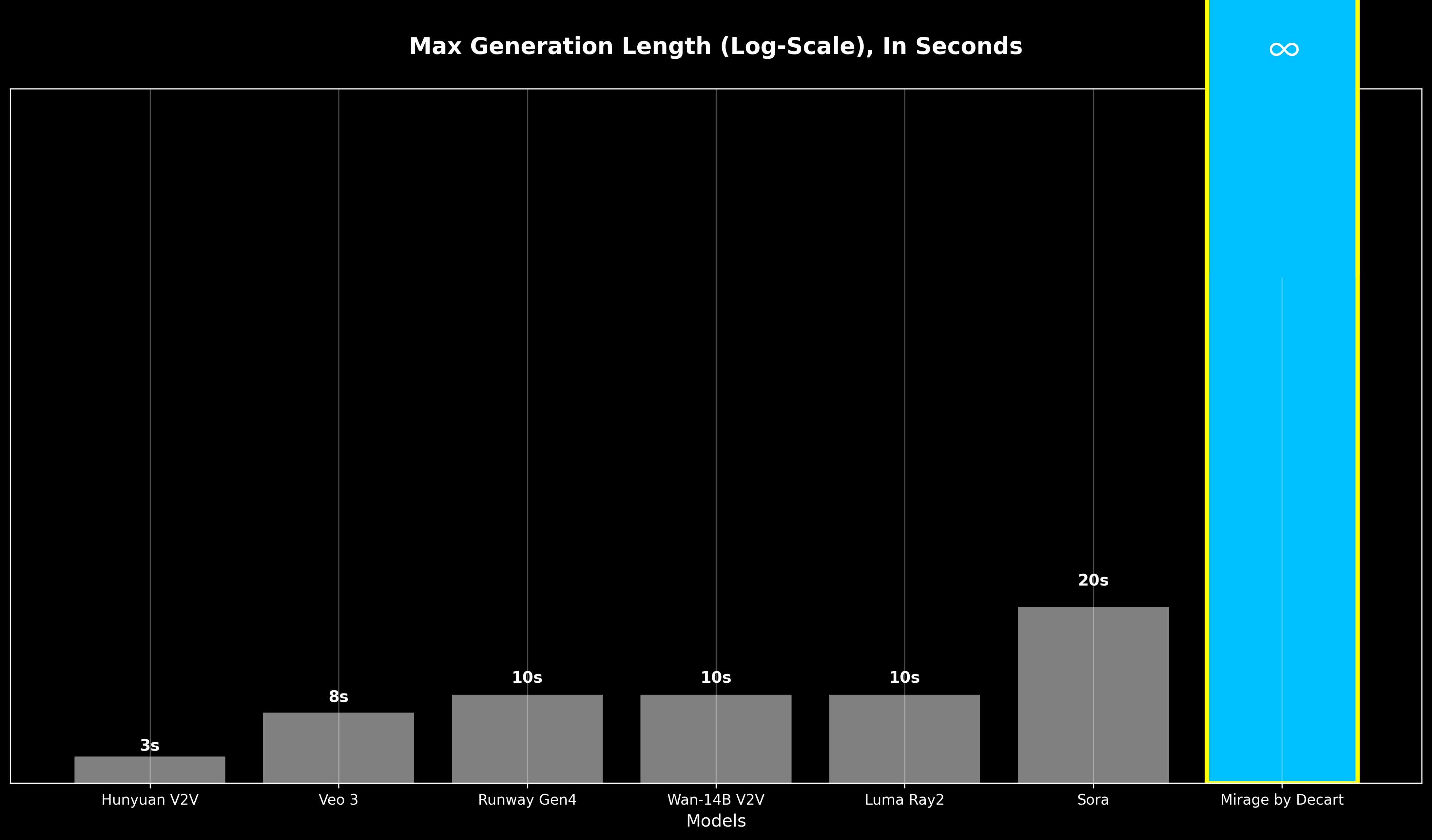

- 无限时长:生成的视频可以一直持续,不受限制

- 超高效率:用了最新技术,让速度和质量都大提升

核心方法与创新

✅ 技术1:逐帧生成 + 记忆修复

- 每次只生成一帧,快得多

- 带记忆的训练方式能“自动纠错”,不会越生成越乱

✅ 技术2:极限 GPU 优化

- 写了专门适配 NVIDIA Hopper 显卡的超级代码

- 所有模型步骤都合并成一个“大动作”执行 → 节省时间

✅ 技术3:小模型模仿大模型

- 训练一个“小模型”快速学会“大模型”的生成方法

- 大幅减少每帧所需步骤 → 提升速度不牺牲质量

- Live Stream Diffusion (LSD) 模型

- 每帧独立生成,保持时间连贯性

- 支持用户实时提示和视频编辑

- 实现了 <40ms 延迟,可达 24 FPS 实时输出

- 解决误差累积的问题

- 使用 Diffusion Forcing:每帧独立加噪 → 去噪学习

- 引入 历史增强训练(history augmentation):模型在训练时见过有瑕疵的历史帧,具备抗漂移能力

- 实现实时响应的三项系统优化

- Hopper GPU 优化 Mega Kernels:高度并行处理每帧

- 架构感知剪枝(architecture-aware pruning):减少 FLOPs,优化硬件利用

- Shortcut Distillation:小模型模仿大模型的去噪轨迹,降低运算复杂度

实验结果与性能提升

- 相比以往模型,MirageLSD 提升了 16 倍的响应速度

- 首次实现了:零延迟 + 无限时长 + 稳定生成

在直播、游戏、视频通话等场景具备良好应用前景

局限性与未来方向

- 当前仅依赖短期帧历史,缺乏长期记忆机制

- 对 精确对象控制、区域控制、动作控制 支持有限

- 在风格剧烈变化时,结构保真性仍待改进

- 未来方向包括:引入关键点控制、场景结构信息、语义记忆增强

- 已上线网页版体验:点击使用 Mirage 应用

- iOS 和安卓版本下周上线

- 想了解背后的技术?点这里看技术博客