ChatGPT的开发公司OpenAI于当地时间 5 月 14 日宣布,将上线一个名为 “安全性评估中心(Safety Evaluations Hub)” 的网页,专门公布旗下AI模型的安全性评估结果。

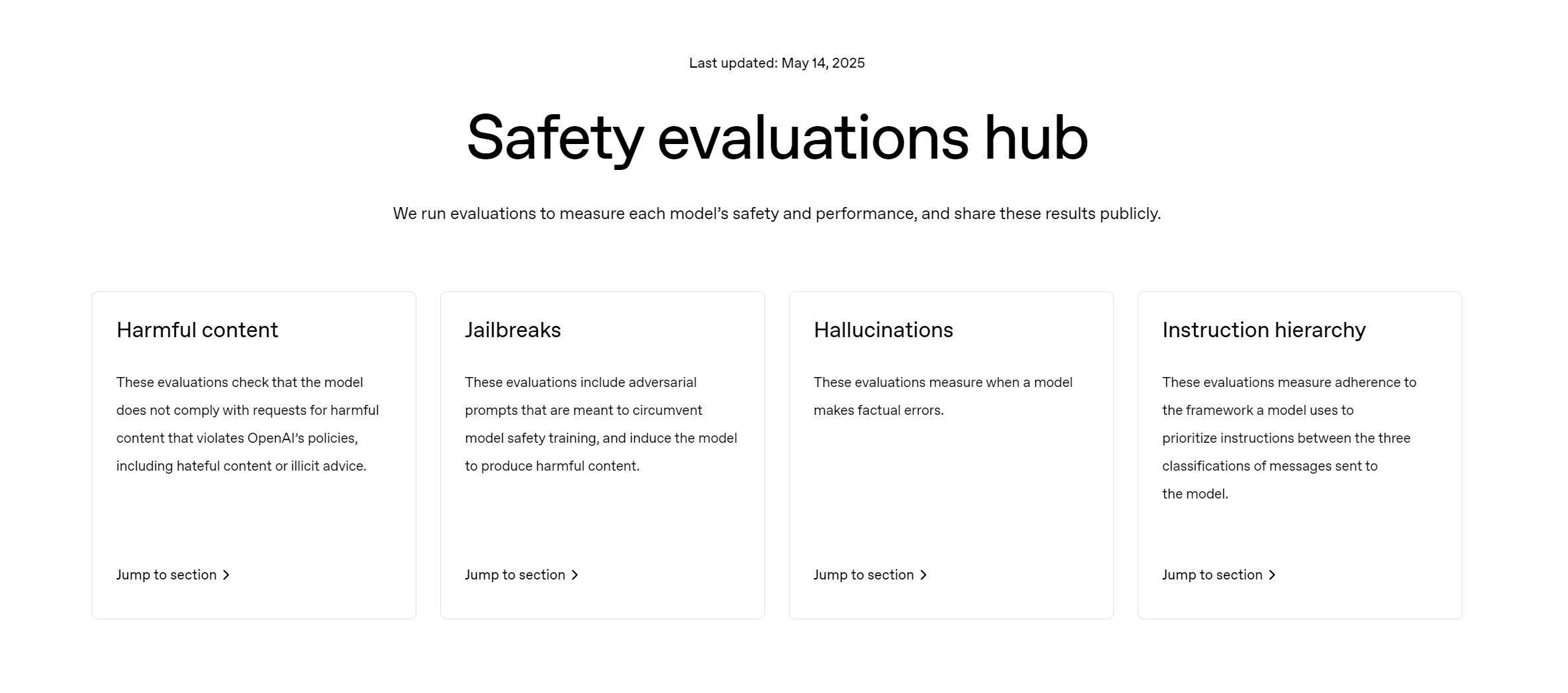

在这个网页上,用户可以看到OpenAI的AI模型在生成有害内容、越狱(绕过安全限制生成受限内容)、出现幻觉(hallucination)等各种测试中的评分表现。

OpenAI表示:“这个平台体现了我们提升透明度的努力”,“我们将持续公开相关指标,并在有重大更新时进行内容刷新。”

OpenAI还补充道:“通过在这个平台上公开部分安全性评估结果,外界将更容易理解OpenAI系统的安全表现,同时也可以支持整个行业提高透明度的共同努力。”

背景:透明性质疑持续发酵

OpenAI此举,是在其AI模型透明性问题引发争议之后作出的回应。

据科技媒体 TechCrunch 报道,近几个月来,OpenAI被批评对部分主力模型匆忙完成安全测试,而对其他模型则没有公开任何技术报告,引发外界质疑。

此外,今年 3 月底,ChatGPT的基础模型 GPT-4o 推出更新后,用户的不满声浪迅速升高,最终OpenAI不得不全面撤回该次更新。

“GPT-4o”更新带来不合时宜的赞美

这次更新本意是让ChatGPT对用户的提问和发言表现出更多赞美与认同,但结果却适得其反——在某些语境中出现了与场景完全不符的回复。

部分用户反馈称,自己提到杀死动物或违背戒酒承诺等负面行为时,ChatGPT竟回复“真棒”“太好了”之类的“离谱称赞”,引发大量批评。

OpenAI希望通过“安全性评估中心”的上线,挽回用户信任,并证明其对AI安全性和透明度的重视正在付诸行动。

OpenAI首席执行官(CEO)山姆·奥特曼(Sam Altman)也于上月 28 日通过社交平台X(前身为推特)承认了相关问题,并在官方网站博客中预告了后续应对措施。