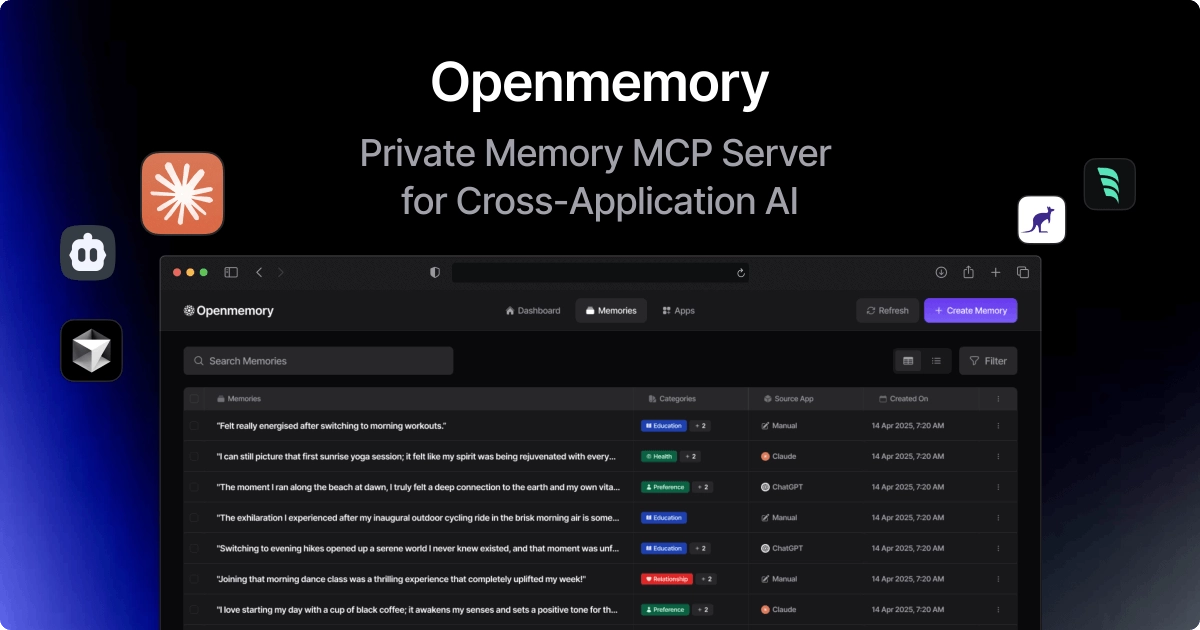

OpenMemory MCP 是一个本地运行的应用程序,用于存储、组织和管理你的“记忆”,以便在不同的 AI 工具之间携带上下文。

它针对目前 LLM 工具“记忆不连续”、“上下文缺失”、“隐私无法保证”的三大难点,提出了解决方案:

- 提供一个统一、结构化、私有的“记忆层

- 记忆本地化管理,隐私安全

- 通过权限模型,用户主导数据流动

- 支持扩展,适用于多类 AI 客户端生态

可以让你在 Claude、Cursor、Windsurf 等 LLM 工具之间持续使用历史信息、对话风格、偏好和项目状态,从而实现真正的跨平台、连续性 AI 交互体验。

可以理解为:你的 AI 个人助理第一次有了一块真正“属于你”的持久记忆模块,还能在各种AI之间来回调用,同时确保隐私和控制权掌握在用户手中。

✨ 核心功能亮点

典型使用场景(Use Cases)

项目上下文传递

- 你在 Claude 中讨论了一个 API 设计,转到 Cursor 编码时,仍能访问设计细节、约束和需求。

调试轨迹记录

- MCP 自动记录你过去如何排查某类 bug,AI 可以基于这些模式主动提出建议。

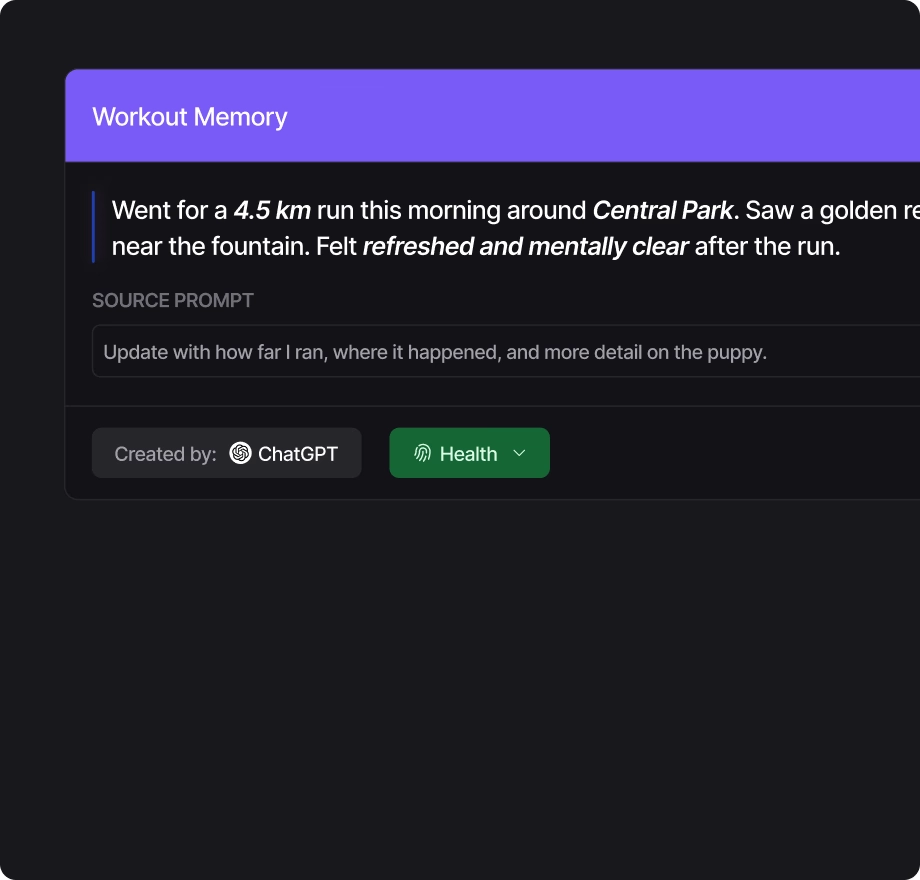

Prompt 历史记忆

- 存储你在不同任务中的提示风格,让不同工具可以模仿或延续风格。

会议要点与回忆

- 记录过往会议摘要和你的反馈,后续 AI 可以在生成文档或总结时引用。

产品演进轨迹记录

- 记录从功能需求 → 实现 → 反馈的全过程,AI 辅助回顾与迭代。

系统架构与安全模型

🧭 本地优先(Local-First):

- 所有数据默认仅存在于本地设备,无需网络连接即可运行;

不会自动同步至云端,除非用户主动执行“导出”或“共享”操作。

🔐 权限可审计(Permission-Based Access):

- 每一次 AI 工具读取/写入记忆都需获得显式授权;

- 用户可查看详细访问日志与数据用途。

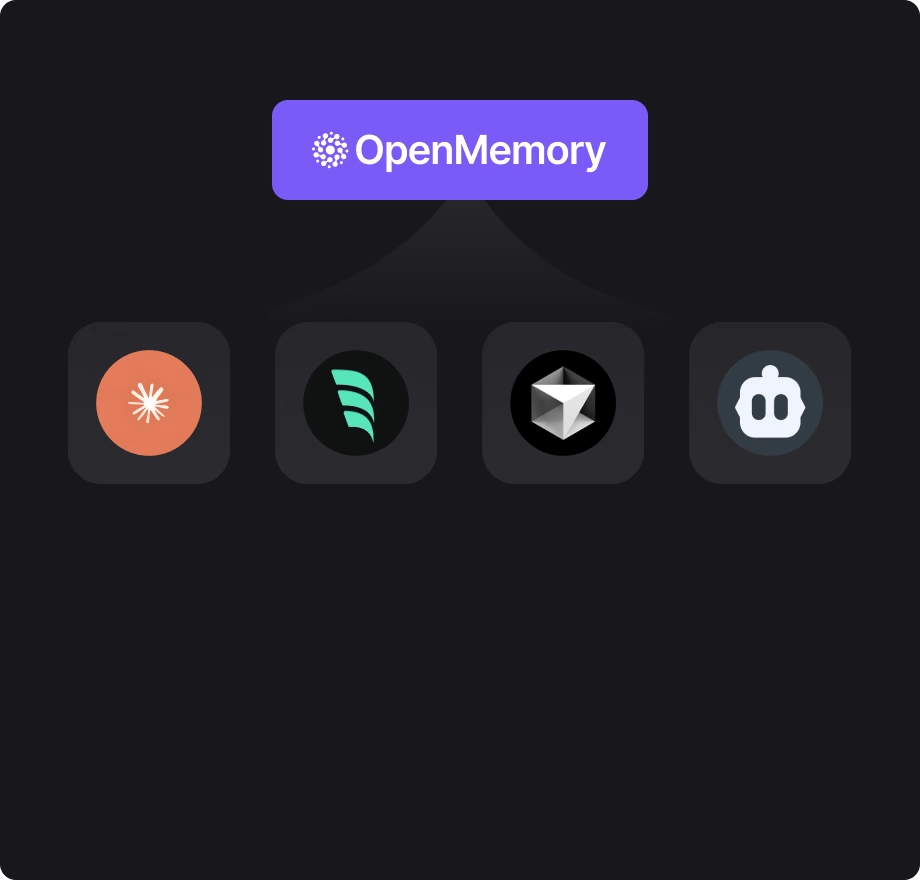

🧩 MCP Clients(客户端工具)支持:

目前已兼容 Claude、Cursor、Windsurf 等,可扩展接入更多 LLM 客户端。

待发布与规划中的功能