耶路撒冷希伯来大学的研究人员最近发现,在检索增强生成(RAG)系统中,即使总文本长度保持不变,处理的文档数量也会显著影响语言模型的性能。

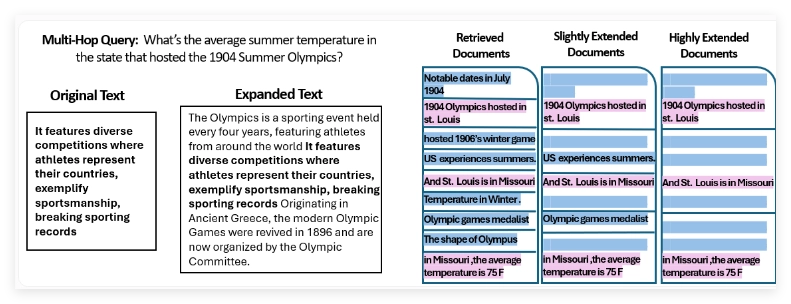

研究团队利用MuSiQue验证数据集中的2,417个问题进行实验,每个问题链接到20个维基百科段落。其中两到四段包含相关答案信息,其余段落作为干扰项。为研究文档数量的影响,团队创建了多个数据分区,逐步将文档数量从20个减少到最少只保留包含相关信息的2-4个文档。为确保总标记数一致,研究人员使用原始维基百科文章的文本扩展了保留的文档。

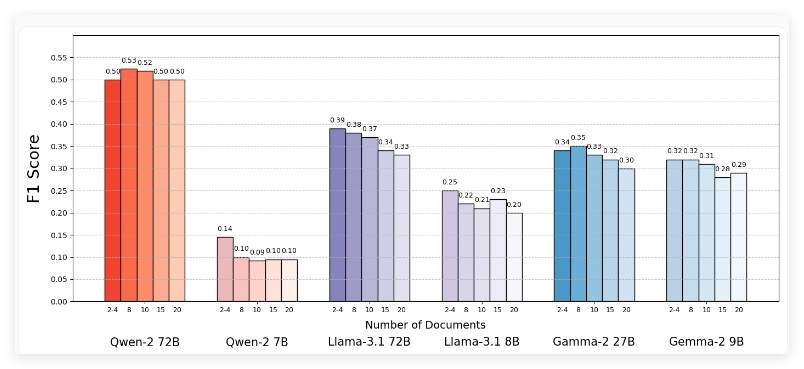

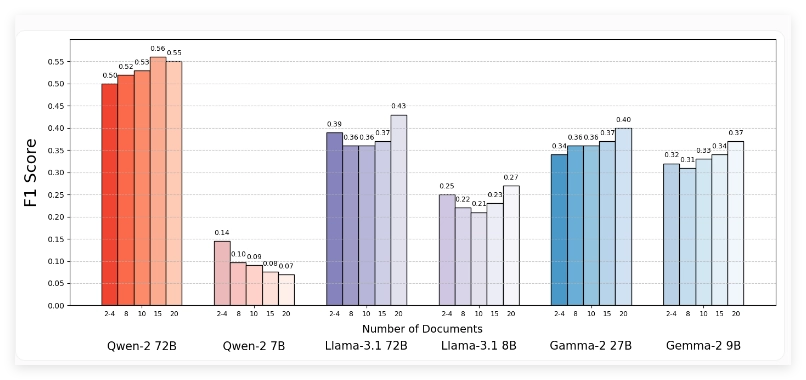

实验结果表明,在大多数情况下,减少文档数量可提高语言模型性能约10%。研究测试了包括Llama-3.1、Qwen2和Gemma2在内的多个开源模型。值得注意的是,Qwen2模型表现出例外,能够在文档数量变化时保持相对稳定的性能,而Llama-3.1和Gemma-2的性能随着文档数量增加明显下降。

当仅提供包含支持性信息的文档时,所有模型表现都明显提升,这表明RAG系统中常见的相似但不相关的文档会使模型混淆并降低性能。有趣的是,模型在处理明显不相关的随机文档时表现反而更好,说明它们更容易识别和过滤明显无关内容。

研究人员强调,在设计检索系统时需要平衡相关性和多样性,以减少信息冲突。他们也承认研究存在一些局限性,包括缺乏对提示变化和数据顺序影响的分析。该团队已公开数据集,以促进这一领域的进一步研究。