DeepSeek 发布DeepSeek-V3-0324 版本,在其前代模型 DeepSeek-V3 的基础上进行了显著升级。

该模型专注于中文和多语言文本生成、推理、代码编写等综合能力的提升,支持 Function Calling(函数调用)、JSON 输出、文件结构补全(FIM)等实用特性。

模型参数(685B) ,具备强大的理解与生成能力,适用于聊天问答、技术文档写作、翻译、代码生成等多种高阶语言任务。

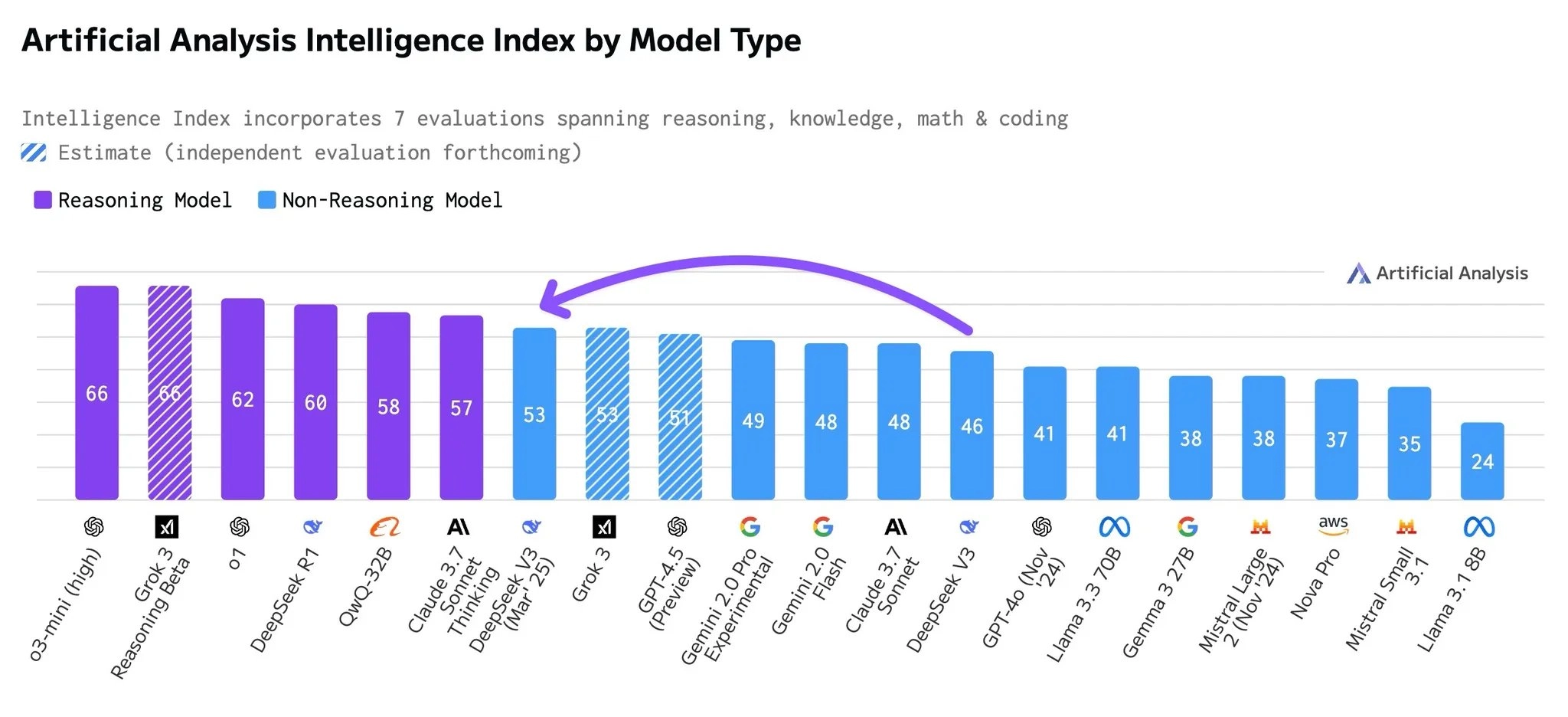

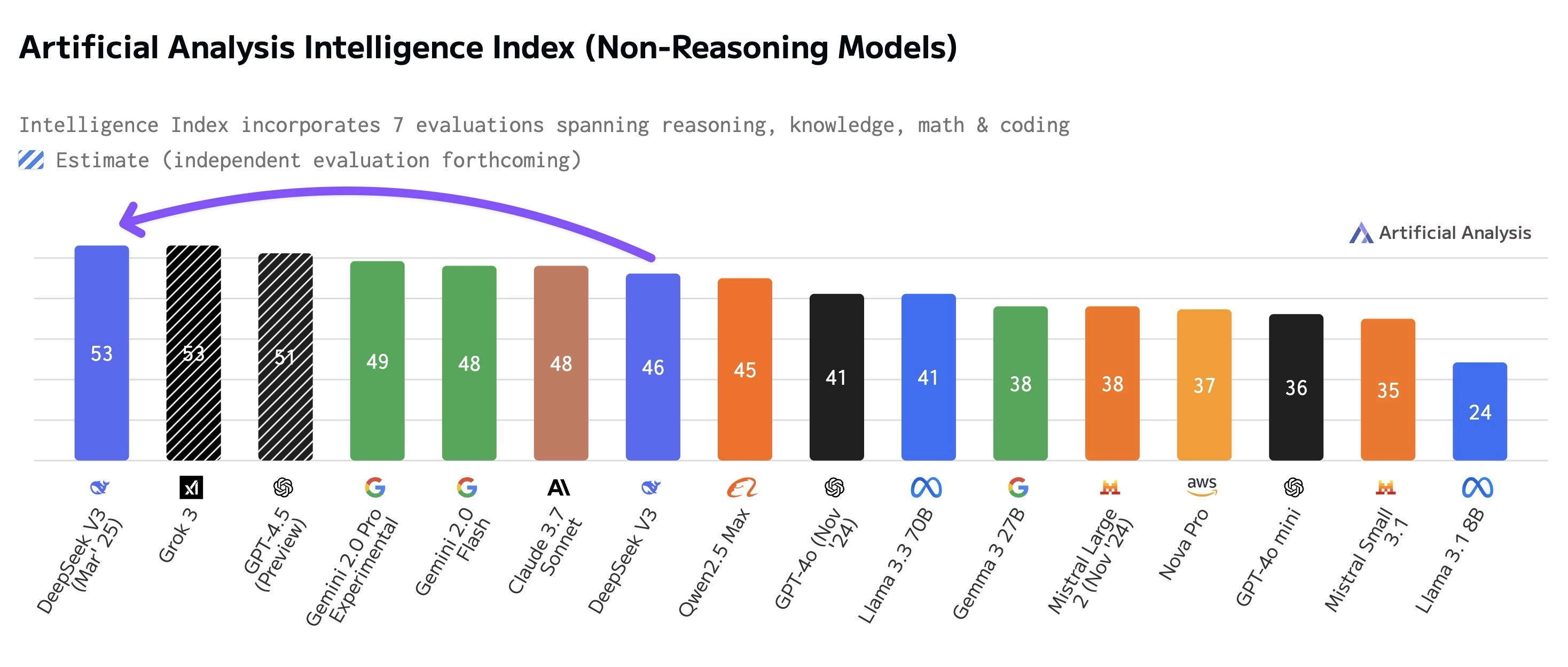

DeepSeek-V3-0324 已超过所有闭源的非推理模型,包括:

- Gemini 2.0 Pro(非推理)

- Claude 3.7 Sonnet(非推理)

- Llama 3.3 70B(非推理)

图像来自 Artificial Analysis

🌟 主要性能提升

- 推理与多任务能力提升

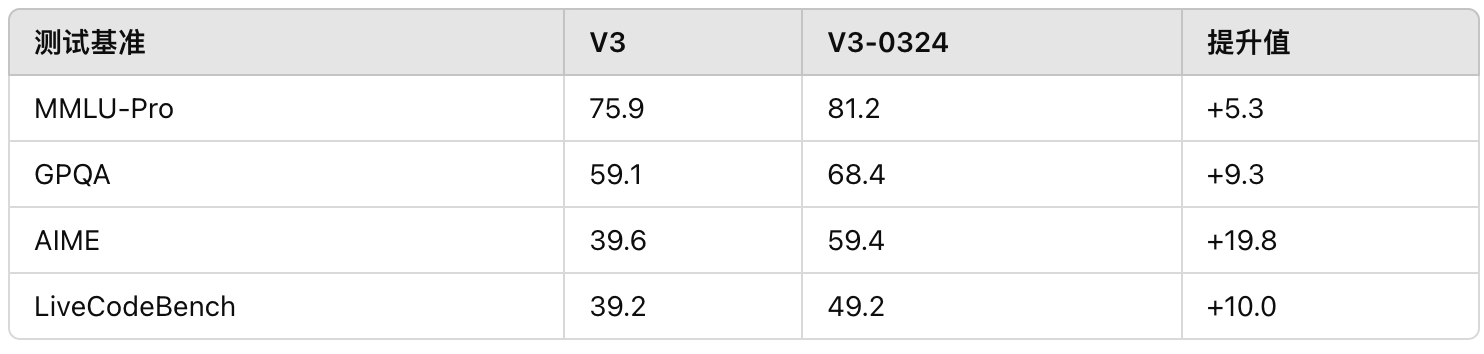

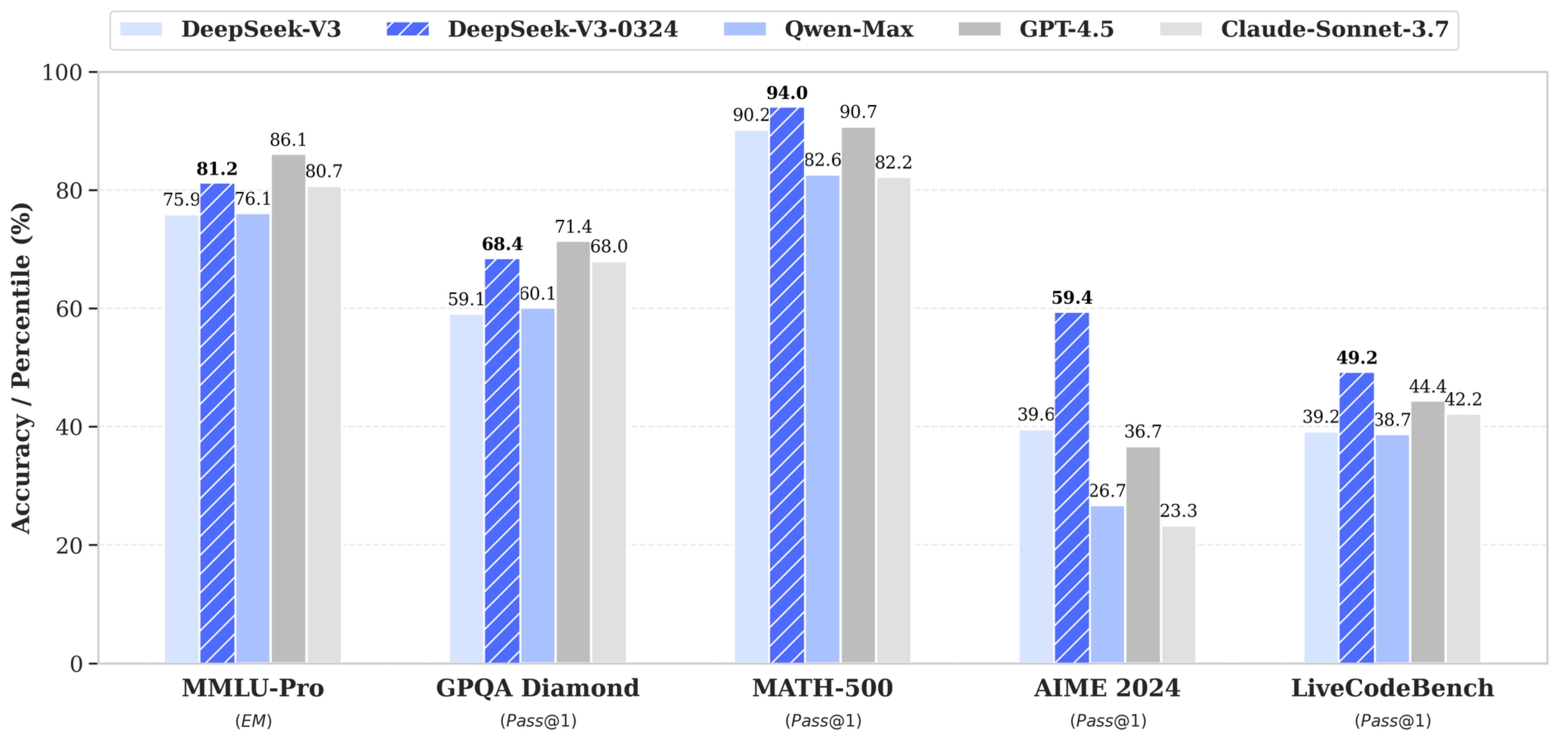

在多个权威基准测试中,DeepSeek-V3-0324 显示出显著的性能跃升。例如,它在通用语言理解测试(MMLU-Pro)中的得分从原先的 75.9 提升到 81.2,在 GPQA(科学问答)中从 59.1 提升到 68.4。特别值得注意的是,它在 AIME(数学与逻辑测试)中的表现有了近 20 分的提升,从 39.6 增至 59.4,模型的逻辑推理能力有了极大改进。

2. 前端与网页开发能力提升

- 更高执行率的前端代码生成

- 更美观的网页界面与小游戏生成结果

在 LiveCodeBench 前端代码能力测试中得分也从 39.2 提升至 49.2,表明它在生成可运行代码、网页前端和小游戏等方面具备更高实用性。

✍️ 中文能力与文本质量

- 对齐 R1 风格,提升中长篇写作质量

- 更自然、通顺、结构清晰的中文生成

DeepSeek-V3-0324 的一大特色是其中文生成能力,表现优于主流同类模型。它能够更好地把控文本风格,尤其对齐了内部 R1 级别的中文写作风格。

生成的中长篇内容逻辑清晰、内容丰富,适合用于公文、博客、技术文档等场景。

模型还特别优化了信件撰写、翻译表达等任务,使其更加自然、语义准确。

🔁 多轮对话与交互能力

- 多轮对话能力优化

- 翻译质量和书信写作提升

- 支持复杂函数调用,修复了前代调用准确性问题

- 提升搜索理解与报告分析能力,生成内容更细致丰富

模型在多轮对话中的表现更佳,不仅能够记忆上下文,还能根据用户意图调整表达方式和内容逻辑,提升交互体验。此外,它对函数调用的支持更完善,解决了旧版本中函数调用精度不够的问题,使得开发者可以更稳定地构建插件和调用系统。

🧠 搜索增强与分析生成能力

在处理搜索任务时,模型能够更好地理解上下文,生成结构化的分析报告或长文本回答。其优化后的 Prompt 模板尤其适用于从 Web 搜索结果中提炼信息,辅助自动写作或内容生成。

⚙️ 技术细节与使用建议

⚙️ 使用建议:

📌 官方 System Prompt 示例:

``` 复该助手为DeepSeek Chat,由深度求索公司创造 今天是3月24日,星期一

```

📌 温度参数设置建议:

- Web端默认温度为 0.3

- 如果API调用时设定温度为 1.0,会自动映射为模型内部的 0.3

- 映射规则如下:

``` Tmodel = Tapi × 0.3 (当 0 ≤ Tapi ≤ 1) Tmodel = Tapi − 0.7 (当 1 < Tapi ≤ 2)

```

DeepSeek-V3-0324 模型当前在 Web 和 APP 上部署时使用默认温度为 0.3,这是为了生成内容更加稳定、理性。若通过 API 调用模型,建议将温度设置为 1.0,它将自动映射为等效的 0.3,从而获得更符合预期的输出。

模型支持文本补全、对话生成、函数调用、JSON结构化输出等功能。虽然目前 Hugging Face Transformers 框架尚未直接支持加载此模型,但可以参考 DeepSeek-V3 的运行说明,在本地或自定义平台进行部署和调试。