Mistral AI 发布了 Mistral Small 3.1 24B,这是其“小型”模型系列中的最新版本,拥有更强的文本性能、多模态理解能力,并支持长达128k tokens的上下文窗口。

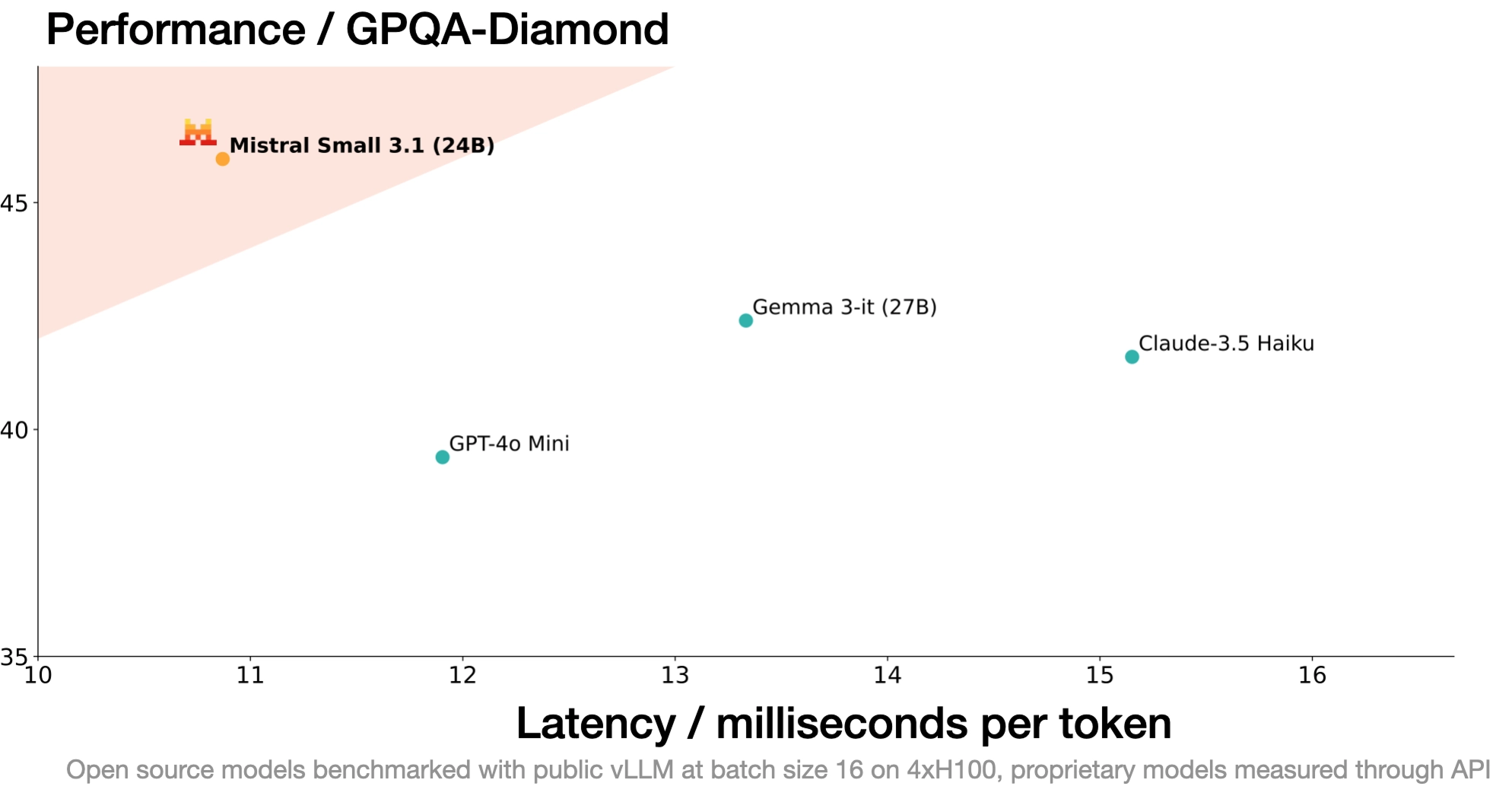

它在文本、图像、多语言和长上下文处理等多个关键指标上均优于同类竞品(如 Gemma 3、GPT-4o Mini),推理速度可达 150 tokens/秒。

该模型以 Apache 2.0 许可证 开源,旨在支持低延迟、高效成本的现代 AI 应用。

主要改进与特性

(1) 性能提升

Mistral Small 3.1 相较于 Mistral Small 3,改进如下:

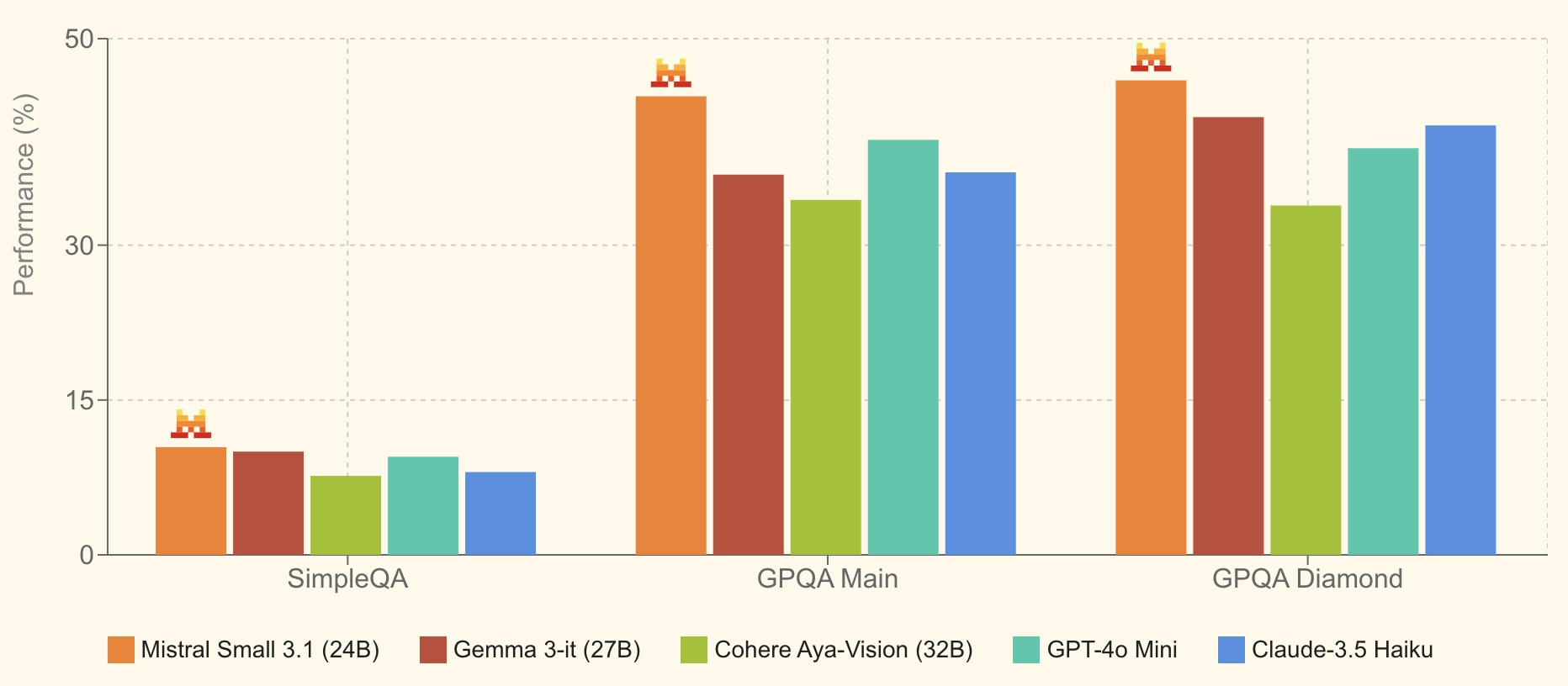

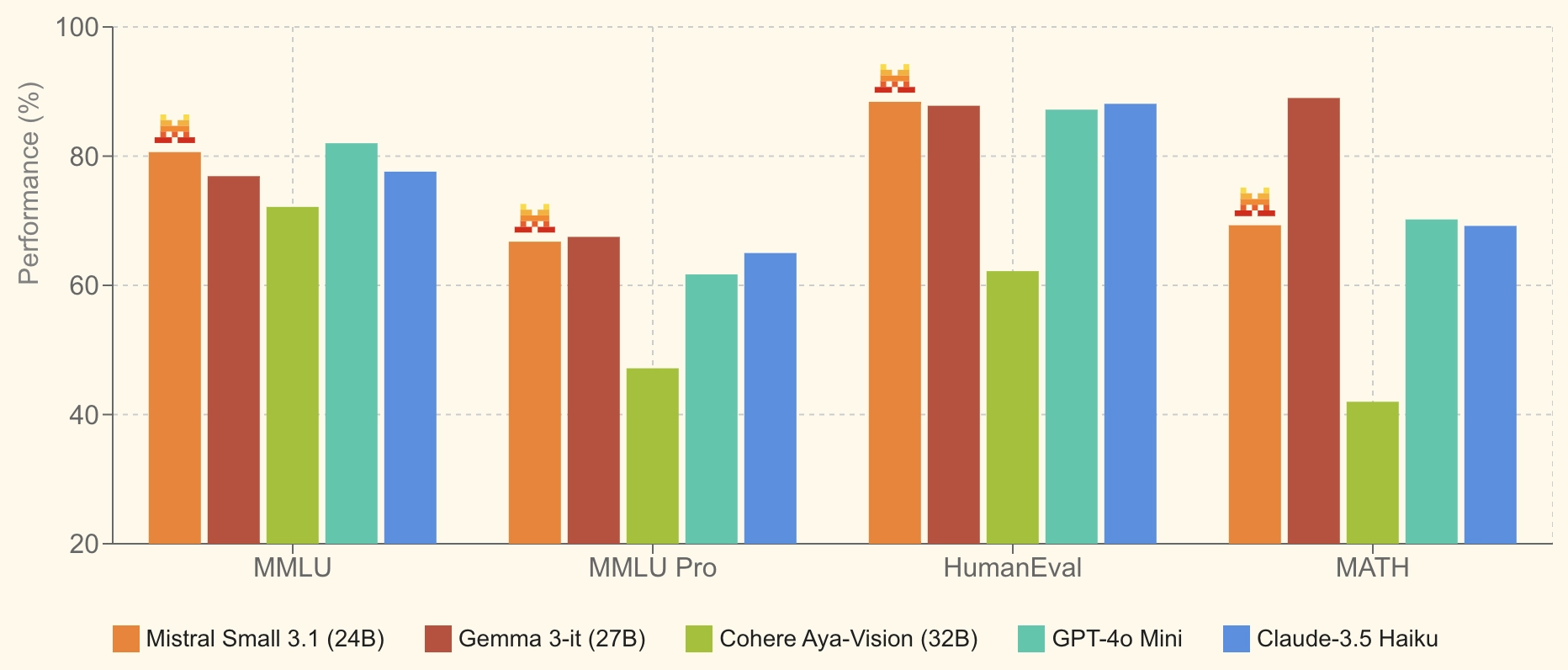

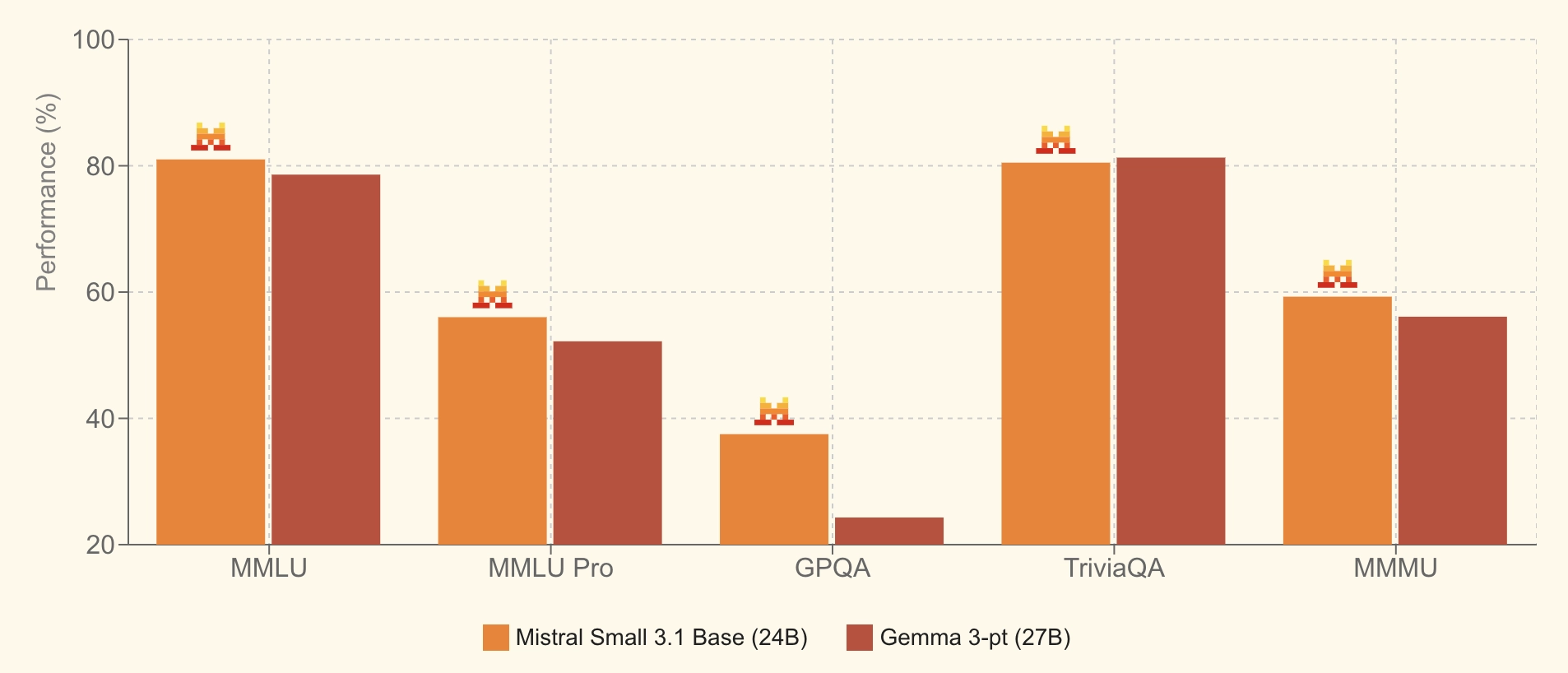

- 文本生成:在多项基准测试中优于 Gemma 3、GPT-4o Mini、Claude-3.5 Haiku。

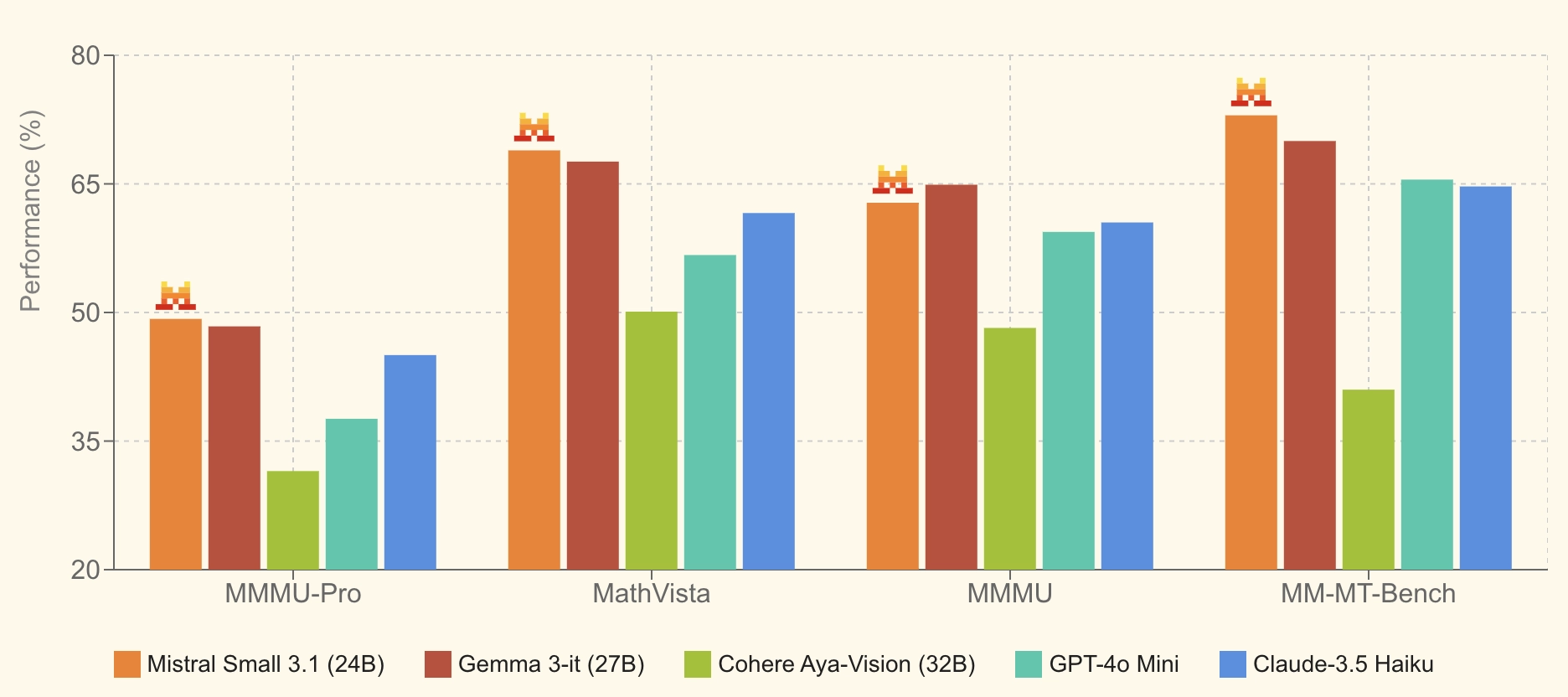

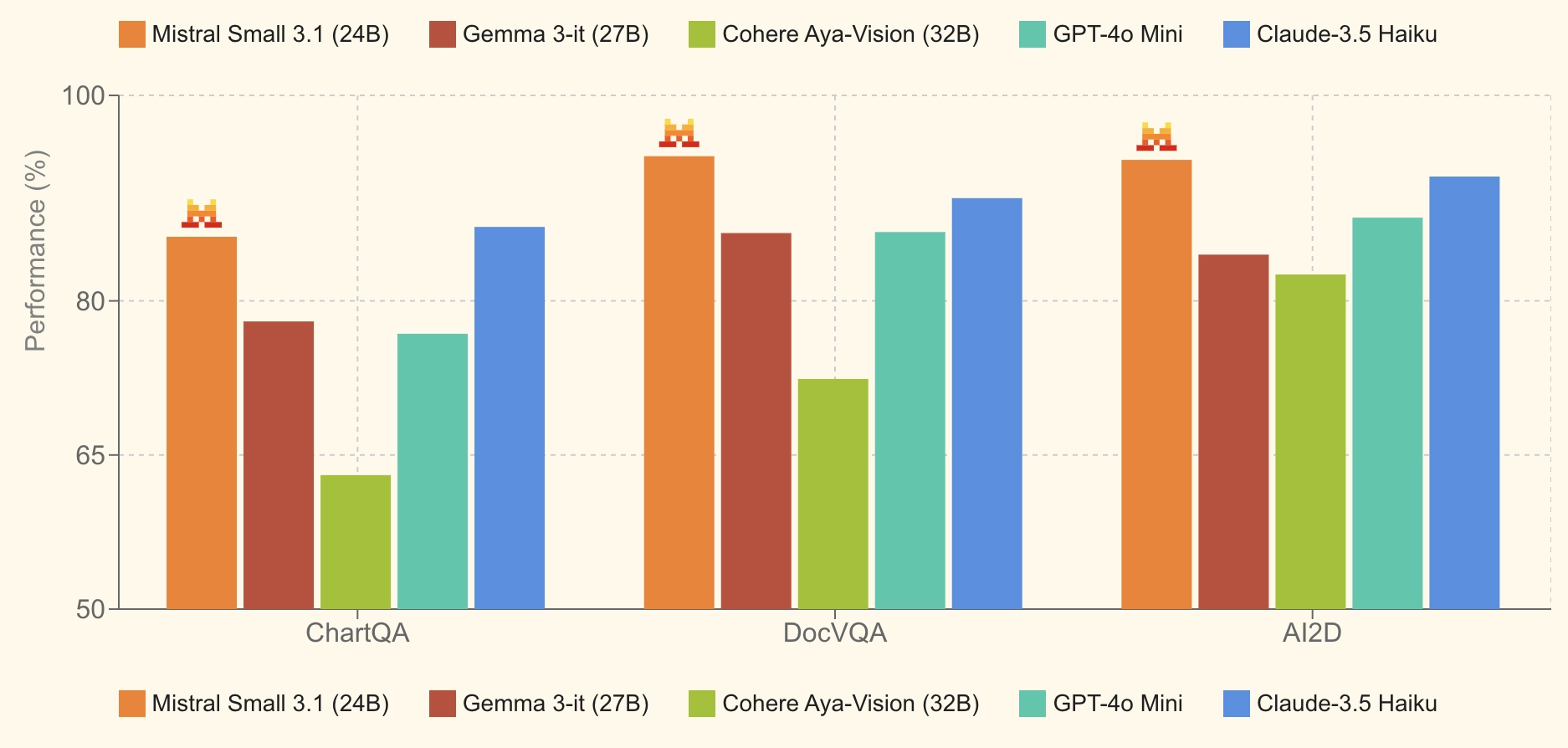

- 多模态能力:改进了对图像、文档的理解能力,适用于 OCR、视觉问答等任务。

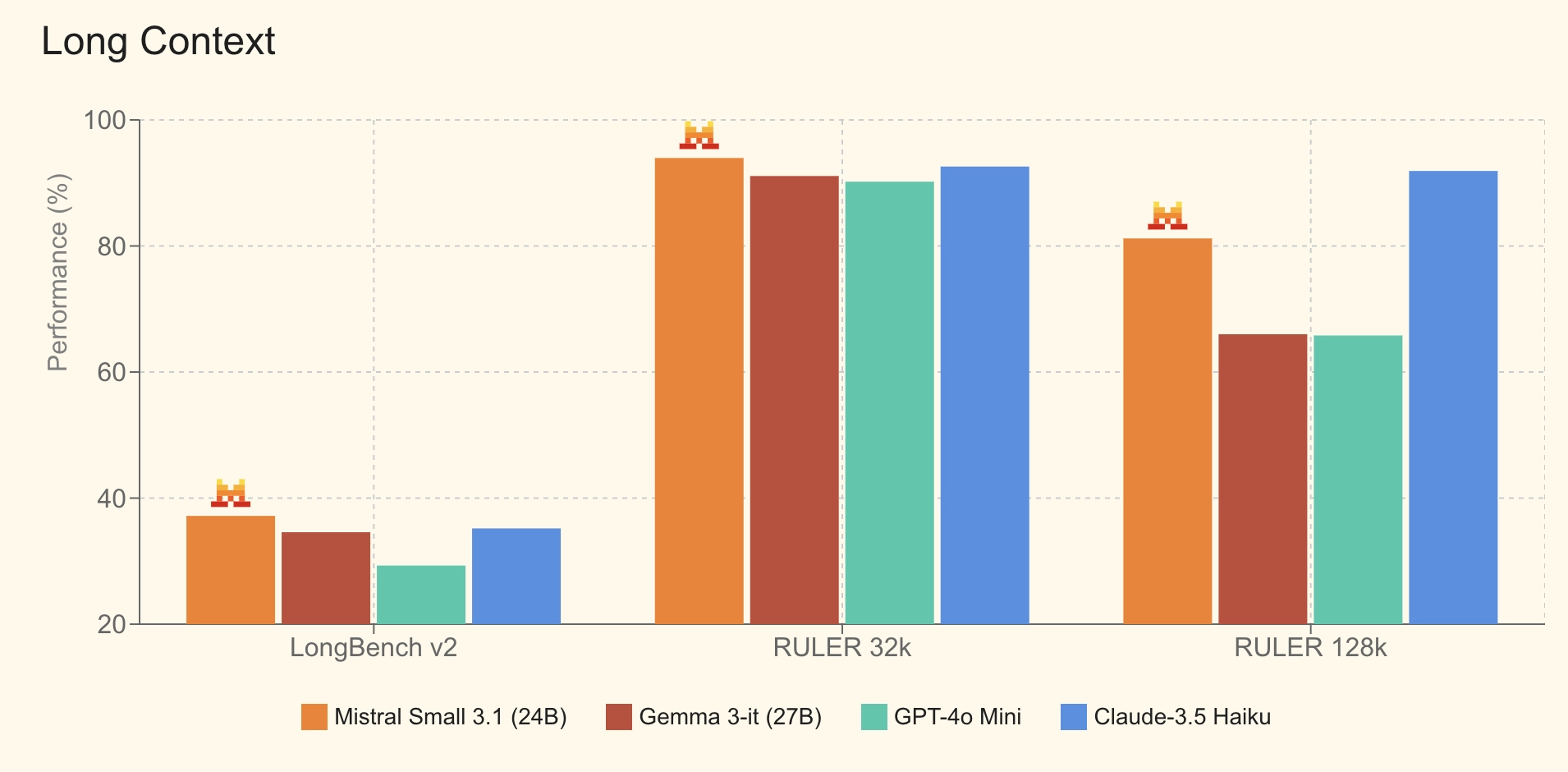

- 长上下文处理:支持128k tokens,在 LongBench v2、RULER 等测试中表现优异。

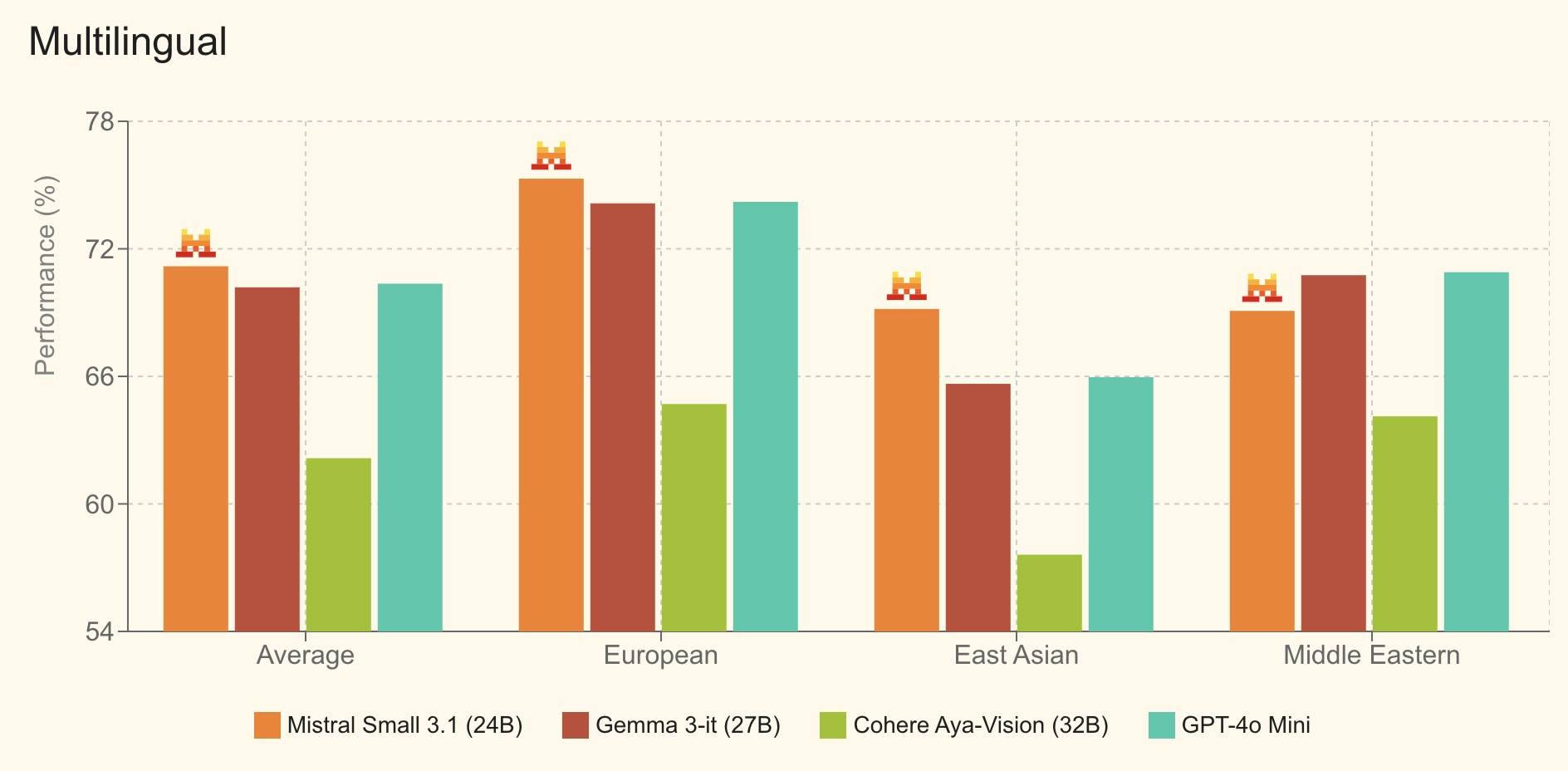

- 多语言支持:在欧洲、东亚和中东语言的处理上都有显著提升。

(2) 基准测试结果

文本指令基准测试

多模态指令基准测试

Multilingual 多语言

Long Context 长上下文

主要应用场景

Mistral Small 3.1 适用于多种生成式 AI 任务:

- 智能对话:高效的对话 AI,可用于客服、个人助手。

- 多模态理解:支持图像解析、文档验证、视觉检查等任务。

- 低延迟 API & 本地运行:可在 RTX 4090 或 32GB RAM 的 Mac 设备上运行,适用于边缘计算。

- 领域专用微调:支持定制化训练,可应用于法律、医学、技术支持等专业领域。

Mistral 还发布了 Mistral Small 3.1 的预训练基础模型。

开源与获取

模型下载:

API 访问:

- 可通过 Mistral AI 开发者平台(La Plateforme)调用。

- Google Cloud Vertex AI 已上线。

- 未来将支持 NVIDIA NIM 和 Microsoft Azure AI Foundry。