《Factorio》是一款复杂的电脑游戏,专注于建造与资源管理,最近成为研究人员评估人工智能能力的新工具。这款游戏能够测试语言模型在规划和构建复杂系统的能力,同时管理多个资源和生产链。

为此,研究团队开发了一个名 “Factorio 学习环境”(FLE)的系统,提供了两种不同的测试模式。“实验模式” 包含24个结构化挑战,设定了具体目标和有限资源,任务从简单的两台机器建造到复杂的近百台机器工厂都有。而在 “开放模式” 下,AI 代理可以探索程序生成的地图,唯一目标是建造尽可能大的工厂。

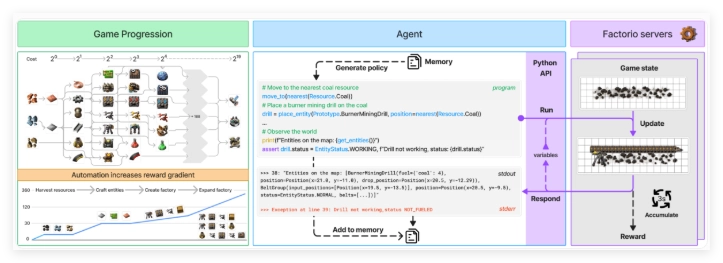

代理通过一个 Python API 与《Factorio》进行交互,能够生成代码以执行各种操作并检查游戏状态。这个系统旨在测试语言模型合成程序的能力以及处理复杂系统的能力。API 允许代理执行诸如放置和连接组件、管理资源和监控生产进度等功能。

为了评估代理的表现,研究者使用了两个关键指标:“生产评分”,用于计算总产出价值,且随着生产链复杂性的增加而呈指数增长;“里程碑” 则跟踪诸如创造新物品或研究技术等重要成就。游戏的经济模拟考虑了资源稀缺性、市场价格和生产效率等因素。

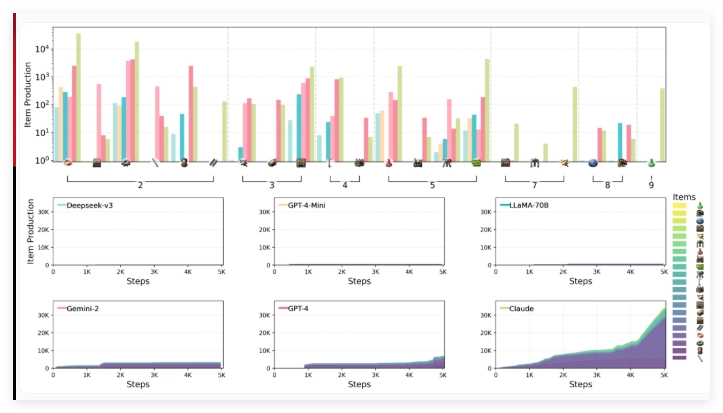

研究团队,包括来自 Anthropic 的科学家,评估了六种领先的语言模型在 FLE 环境下的表现,包括 Claude3.5Sonnet、GPT-4o 及其迷你版、DeepSeek-V3、Gemini2.0Flash 以及 Llama-3.3-70B-Instruct。在这轮测试中,未包含大型推理模型(LRMs),但以往的基准测试表明,像 o1这样的模型在规划能力上表现优异,尽管自身也存在局限性。

测试显示,参与评估的语言模型在空间推理、长期规划和错误纠正方面面临显著挑战。构建工厂时,AI 代理在高效安排和连接机器方面出现困难,导致了次优布局和生产瓶颈。战略思维同样成为挑战,模型们普遍更倾向于优先考虑短期目标,而不是长期规划。此外,尽管它们能够处理基本的故障排查,但在面对更复杂问题时,往往陷入低效的调试循环。

在测试的模型中,Claude3.5Sonnet 表现最为出色,但仍未能掌握所有挑战。在实验模式中,Claude 成功完成了24个任务中的15个,而其他模型最多也只完成了10个。在开放测试中,Claude 的生产评分达到2456分,GPT-4o 以1789分紧随其后。Claude 展现出复杂的《Factorio》游戏玩法,通过其战略性制造和研究方法,快速从基础产品转向复杂生产过程,尤其是电钻技术的提升,显著提高了铁板的生产速度。

研究者认为,FLE 开放且可扩展的特性,使其在未来测试更强大的语言模型时具有重要价值。他们建议扩展该环境以包含多代理场景和人类表现基准,以便提供更好的评估背景。这项工作进一步丰富了基于游戏的 AI 基准测试的集合,其中还包括 BALROG 和即将推出的 MCBench,这些都将利用《Minecraft》进行模型测试。

Factorio 学习环境:soraor.com

划重点:

🌟 《Factorio》游戏成为评估 AI 能力的新工具,测试语言模型的复杂系统管理能力。

🛠️ Factorio 学习环境(FLE)提供实验和开放模式,允许 AI 在不同条件下进行挑战。

📊 测试显示 Claude3.5Sonnet 表现最佳,但仍存在长期规划和复杂问题处理的困难。