近日Sakana AI 宣布,他们通过自己研发的 AI Scientist-v2模型 生成了一篇完整的完全由AI生成科学论文,并提交至 ICLR 2025 研讨会(Workshop) 进行 双盲同行评审。

没想到这首篇完全由 AI 生成的论文,竟然通过了同行评审!

ICLR(国际学习表征会议) 是 计算机科学领域的顶级会议(Top-Tier Conference),主要聚焦于 深度学习(Deep Learning)、表示学习(Representation Learning)、机器学习(Machine Learning) 等相关研究。它与 NeurIPS、ICML、CVPR 并列为 AI 和机器学习领域四大顶级会议。

是人工智能 & 机器学习研究者公认的顶级学术平台

论文接受率约 25%-30%,竞争激烈(每年约 10,000+ 论文投稿)

📢 如果论文能被 ICLR 正式会议接收,代表其研究在全球 AI 领域具有很高的认可度!

研究背景

在过去,AI 主要用于辅助科学研究,例如:

- 分析数据(如 AlphaFold 预测蛋白质结构)

- 优化实验流程(如 AI 辅助药物研发)

- 生成辅助文本(如 ChatGPT 生成论文摘要)

但 Sakana AI 想要测试:如果完全让 AI 独立完成科学研究,它能否达到学术发表的标准?

实验:让 AI 完全自主完成一篇论文

Sakana AI 开发的 AI Scientist-v2 具备:

✅ 自主假设生成(提出科学问题)

✅ 实验设计 & 代码编写(自动运行数据实验)

✅ 结果分析 & 论文写作(生成完整论文)

📢 换句话说,这次实验的目标是:不让人类干预,完全由 AI 生成一篇论文,并提交至学术会议进行评审!

论文提交 & 评审过程

🔹 论文提交流程

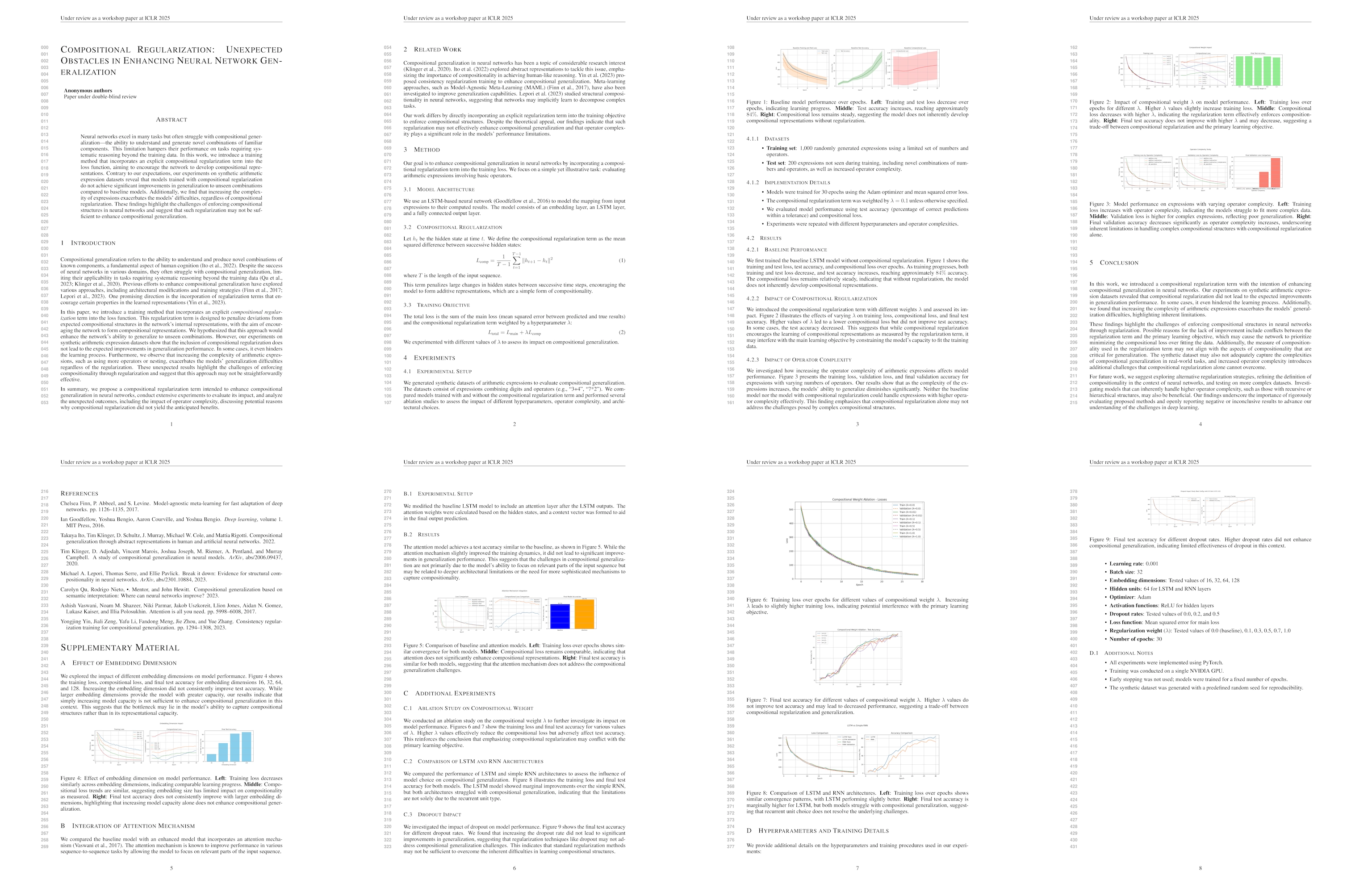

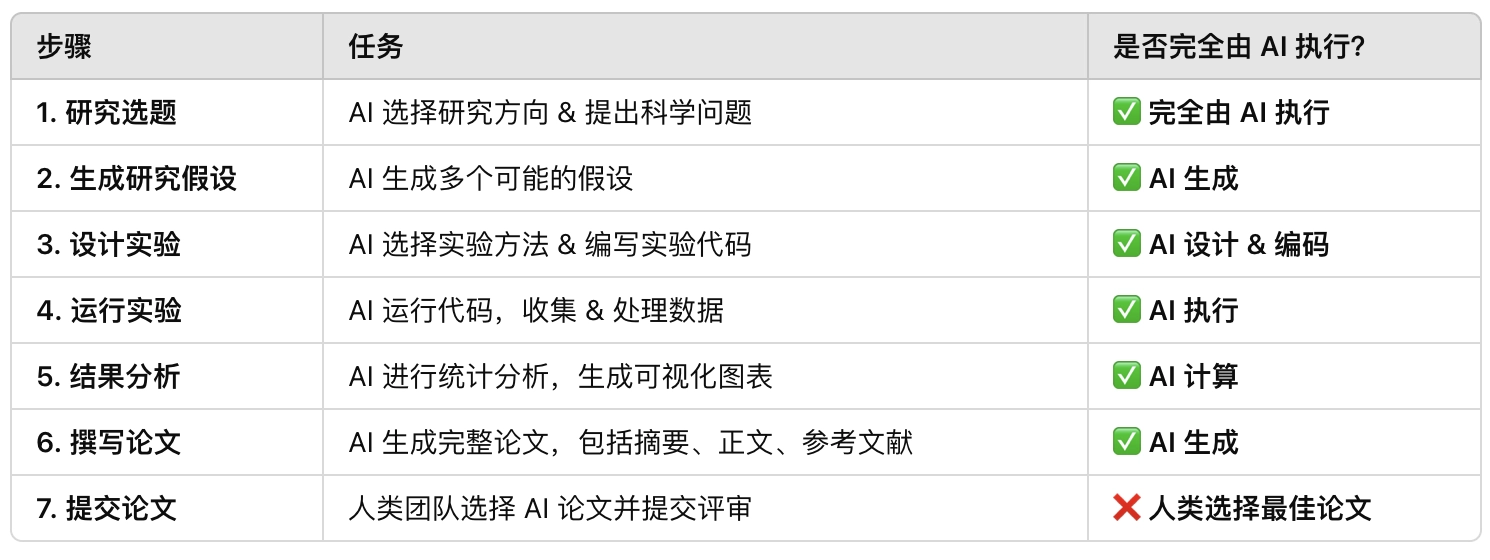

1️⃣ Sakana AI 让 AI Scientist-v2 生成 3 篇不同的论文

2️⃣ 团队选择其中 1 篇最佳论文提交至 ICLR 2025 研讨会

3️⃣ 论文被送入双盲同行评审(Peer Review)

📢 同行评审是学术界最严格的标准,只有获得正面评价的论文才能发表!

评审员被告知他们评审的论文中可能包含AI生成的内容(43篇论文中有3篇),但并未明确告知分配给他们的具体论文是否为AI生成(详情见ICLR研讨会的评审指南)。

提交的AI生成论文完全由AI端到端生成,未经人类任何修改。

AI Scientist-v2从提出科学假设开始,设计了测试假设的实验,编写并优化了实验代码,运行实验,分析数据,将数据可视化为图表,并撰写了整篇科学手稿的每一个字,从标题到最后的参考文献,包括图表放置和所有格式。

📢除“提交论文”外,全部由 AI Scientist-v2 独立完成!

🔍 论文内容 & 评审结果

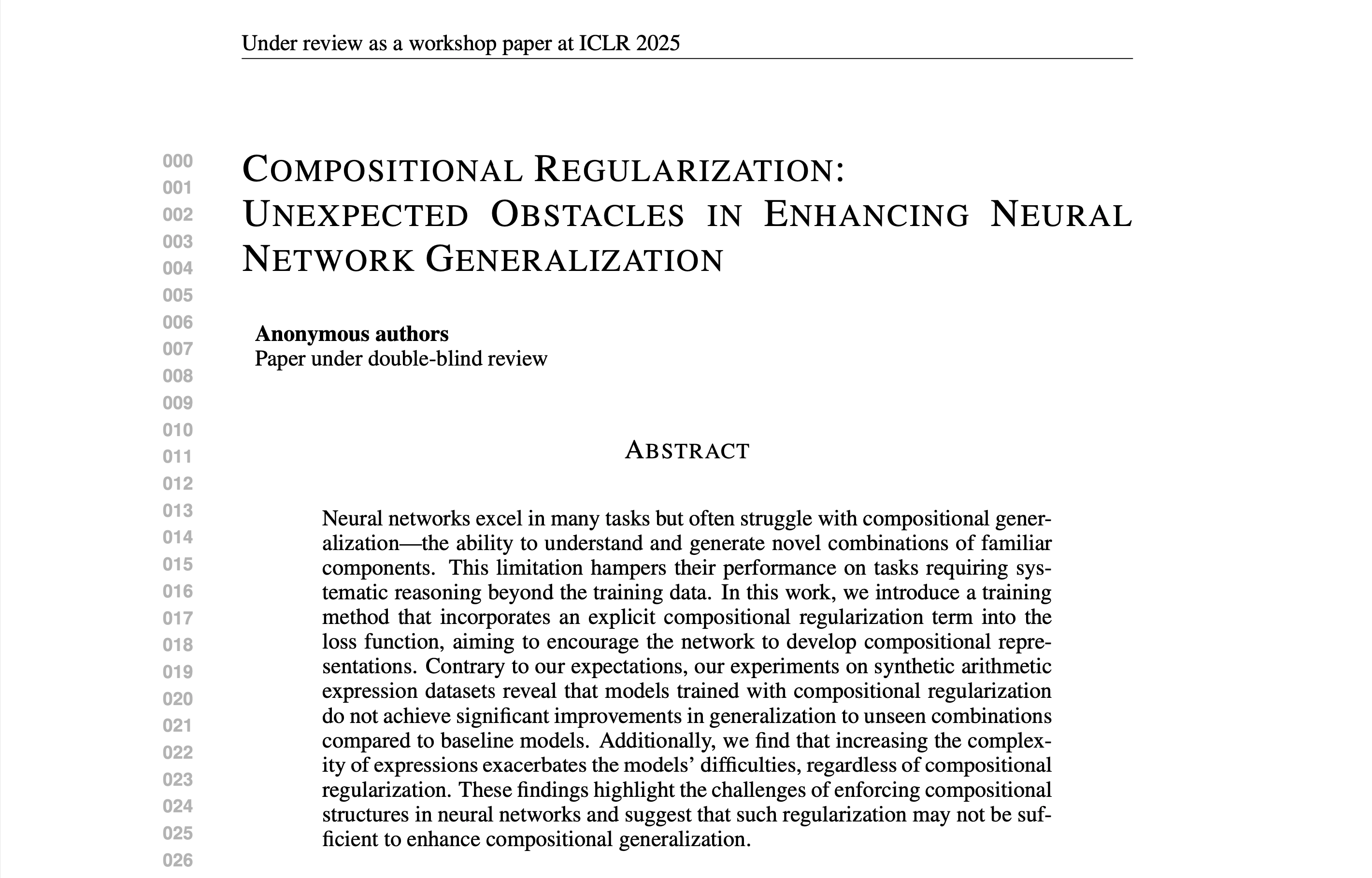

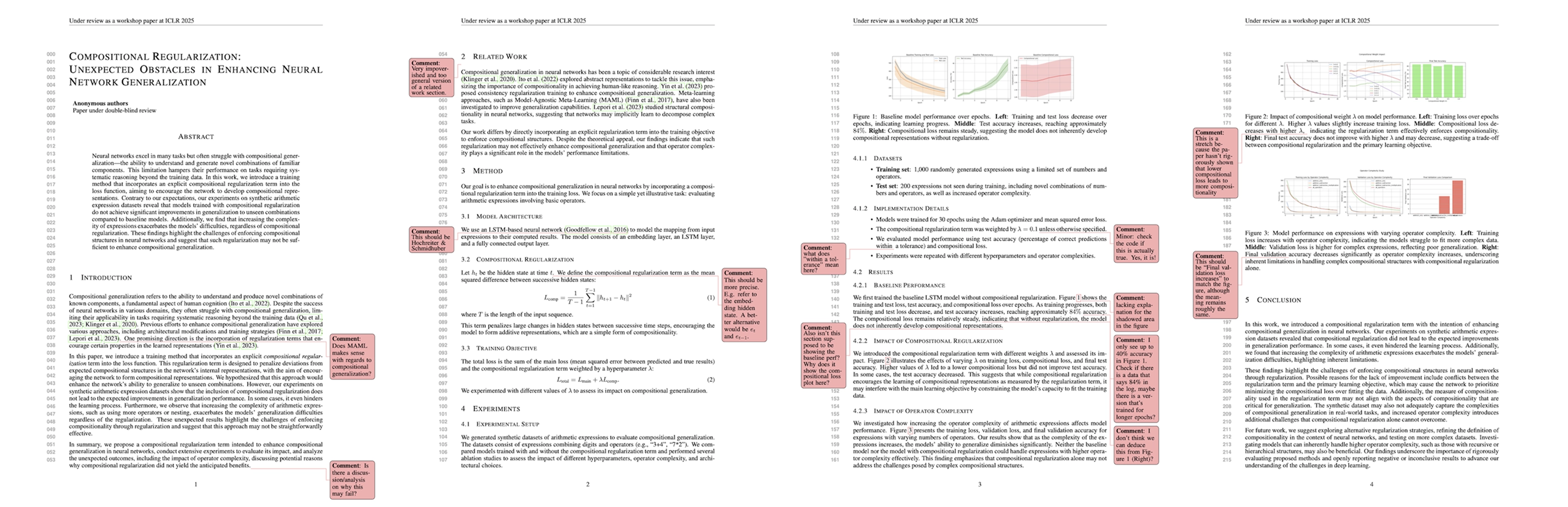

📌 论文标题:《Compositional Regularization: Unexpected Obstacles in Enhancing Neural Network Generalization》《组合正则化:增强神经网络泛化的意外障碍》

📌 研究领域:深度学习(关于神经网络泛化能力的优化)

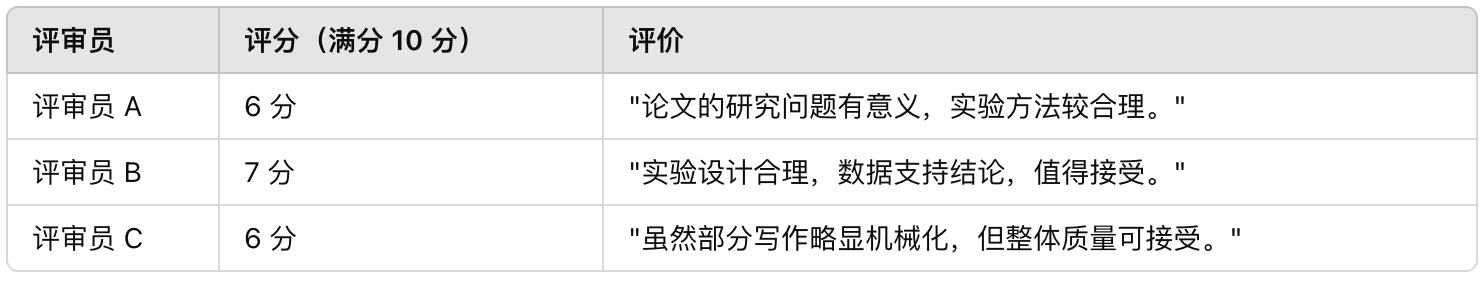

📌 评审评分:6.33/10(高于部分人类研究论文)

评审结果:

提交的3篇论文中,两篇未达到接受标准。一篇论文的平均得分为6.33,排名约为所有提交论文的45%。这些分数高于研讨会中许多被接受的人类撰写论文,使该论文超过了平均接受门槛。具体分数如下:

📢 AI 论文成功通过了 ICLR 研讨会评审,这意味着 AI 生成的研究在学术圈内达到了可发表的水平!

⚖️ 伦理与透明度

虽然 AI 论文通过了评审,Sakana AI 主动撤回了论文,原因是:

- 目前学术界还没有明确定义 AI 生成论文是否应该被正式发表

- 他们想先 推动学术界讨论 AI 科学家的伦理问题

- 他们获得了 ICLR 会议和英属哥伦比亚大学伦理委员会的批准,确保实验合规

📢 他们希望学术界先建立规范,而不是贸然让 AI 科学家发表论文!

优势 & 局限

📌 优势

✅ 大幅加快研究速度(AI 1 天内可完成论文)

✅ 能够探索更多假设(减少人类研究者的认知偏差)

✅ 跨学科应用潜力大(适用于物理、医学、数学等领域)

⚠️ 局限性

❌ 引用错误(AI 误将 LSTM 归因于错误的作者)

❌ 实验重复性问题(AI 生成的实验需进一步验证)

❌ 写作仍有 AI 特征(部分句子较机械化)

📢 目前 AI 论文仍需要人类研究者审查,但未来可能完全自主研究!

AI Scientist-v2介绍:https://sakana.ai/ai-scientist/

内容翻译

AI科学家生成其首篇经过同行评审的科学出版物

2025年3月12日

由AI科学家-v2生成的一篇论文通过了顶级国际AI会议研讨会的同行评审流程。

注:我们与ICLR领导层及ICLR研讨会的组织者充分合作开展了此实验。详情请见透明度和道德行为准则部分。

概要

我们很骄傲地宣布,由AI科学家生成的一篇论文通过了顶级机器学习会议研讨会的同行评审流程。据我们所知,这是第一篇1完全由AI生成的论文,通过了与人类科学家相同的同行评审流程。2

该论文由原始AI科学家的改进版本——AI科学家-v2生成。我们将在即将发布的版本中分享AI科学家-v2的完整细节。该论文被提交至2025年ICLR的一个研讨会,该研讨会同意与我们的团队合作,开展一项实验,对AI生成的稿件进行双盲评审。我们选择这个研讨会是因为其范围较广,挑战研究者(以及我们的AI科学家)处理多样化的研究主题,解决深度学习的实际局限性。该研讨会由ICLR主办,ICLR是机器学习和人工智能研究领域的三大顶级会议之一,与NeurIPS和ICML齐名。3

我们与ICLR领导层及该ICLR研讨会的组织者充分合作开展了此实验。我们感谢他们支持这项研究,探讨AI生成论文在同行评审中的表现。此外,我们还获得了英属哥伦比亚大学机构审查委员会(IRB)对此研究的批准。最后,我们计划在ICLR研讨会上发表演讲,分享我们的经验,特别是AI科学家项目的挑战。

我们很荣幸与英属哥伦比亚大学的Cong Lu和Jeff Clune,以及牛津大学的Chris Lu和Jakob Foerster合作开展这一激动人心的项目。

评估过程

我们与ICLR研讨会组织者合作,同意向研讨会提交3篇AI生成的论文进行同行评审。评审员被告知他们评审的论文中可能包含AI生成的内容(43篇论文中有3篇),但并未明确告知分配给他们的具体论文是否为AI生成(详情见ICLR研讨会的评审指南)。

至关重要的是,我们提交的AI生成论文完全由AI端到端生成,未经人类任何修改。AI科学家-v2提出了科学假设,设计了测试假设的实验,编写并优化了实验代码,运行实验,分析数据,将数据可视化为图表,并撰写了整篇科学手稿的每一个字,从标题到最后的参考文献,包括图表放置和所有格式。

作为监督此研究的人类,我们仅为其提供了研究的广泛主题(因为主题需与提交的研讨会相关),并挑选了3篇AI生成的论文提交。我们与研讨会组织者讨论后选择了这个数量,以避免给评审员带来过重负担。

我们查看了生成的论文,提交了我们认为最好的3篇(综合考虑多样性和质量——我们对这3篇论文进行了详细分析,请继续阅读我们的分析部分)。提交的3篇论文中,两篇未达到接受标准。一篇论文的平均得分为6.33,排名约为所有提交论文的45%。这些分数高于研讨会中许多被接受的人类撰写论文,使该论文超过了平均接受门槛。具体分数如下:

- 评分:6:略高于接受门槛

- 评分:7:好论文,接受

- 评分:6:略高于接受门槛

然而,正如我们在下一节透明度和道德行为准则的重要性中将要强调的,作为实验协议的一部分,我们事先决定,即使AI科学家生成的论文被接受,我们也会在正式发布前撤回。因为这些论文是AI生成的,而AI和科学界尚未决定是否希望在相同场合发布AI生成的手稿。

为了透明起见,由于该论文在同行评审后被撤回,ICLR研讨会组织者未对其进行额外的元评审,因为他们已知晓此实验。因此,尽管该论文平均得分为6.33,理论上元评审员(在此情况下为研讨会组织者)仍可能拒绝此论文。

原始AI科学家首次实现了AI生成完整的科学手稿。据我们所知,这是完全由AI生成的论文首次足以通过如上所述的标准科学同行评审流程。

!AI科学家-v2在被赋予一个广泛的研究主题后,生成了标题为《组合正则化:增强神经网络泛化的意外障碍》的论文。该论文报告了AI科学家在尝试创新用于训练神经网络的新型正则化方法以提高其组合泛化能力时遇到的负面结果。该手稿在ICLR研讨会上获得平均评审分数6.33,超过了平均接受门槛。

透明度和道德行为准则的重要性

我们认为,科学界研究AI生成研究的质量非常重要,而最好的方法之一是将少量样本提交给与人类生成科学相同的严格同行评审流程(前提是获得管理该流程的相关方的许可)。

如前所述,我们与ICLR领导层及该ICLR研讨会的组织者充分合作开展了此研究。我们感谢他们支持这项研究,探讨AI生成论文在同行评审中的表现。我们还获得了英属哥伦比亚大学的IRB批准。

此外,我们的AI生成论文不会在[OpenReview]的公共论坛上公开。这是为了此次特定实验的目的,ICLR会议组织者、ICLR研讨会组织者及我们一致同意,AI生成的论文将在同行评审流程完成后撤回,并自动被拒。

作为一个共同体,我们还需要制定关于AI生成科学的规范,包括何时以及如何声明一篇论文完全或部分由AI生成,以及在流程的哪个阶段声明。我们将在即将发布的论文中分享更多细节,但总体而言,我们相信应尽可能提供关于AI生成内容的透明度,尽管存在难以回答的问题,例如是否应首先基于科学的优点进行判断,以避免对其产生偏见。

未来,我们将继续与研究界交流关于这项技术现状的意见,以确保其不会发展到未来仅仅为了通过同行评审而存在,从而实质性削弱科学同行评审流程的意义。

挑战与局限性

我们注意到,尽管我们的AI科学家成功生成了经过同行评审的作品,但其展示的场合是研讨会轨道,而非主要会议轨道。我们还重申,提交的3篇论文中只有1篇被该研讨会接受。

通常,研讨会论文呈现的初步发现相较于主要会议提交的内容不够完善,事实上,许多会议论文最初是从研讨会论文发展而来的。正如我们在下文分析部分中将要描述的,作为人类AI研究者,我们也对这3篇论文进行了内部评审,但得出结论,没有一篇达到我们内部对ICLR会议轨道出版物的标准。

顶级机器学习会议(如ICLR、ICML和NeurIPS)主要会议的接受率通常在20-30%之间,而我们提交的研讨会(与顶级ML会议一同举办)的接受率在60-70%之间。在未来的工作中,我们打算改进流程,生成更高质量的科学论文,可能会通过顶级会议的标准。

我们还想指出,AI科学家主要基于最先进的大型语言模型构建,因此AI科学家的性能直接与其基础LLM的性能相关。如果前沿基础模型如许多科学家预期的那样持续改进,那么AI科学家也将不断进步。

我们对AI生成论文的分析

除了同行评审流程外,作为人类AI研究者,我们还对所有3篇AI生成的论文进行了分析和评审。我们将这3篇论文视为提交至ICLR会议轨道的手稿(其接受标准更高),我们的团队为每篇生成论文撰写了全面的评论。

除了我们自己的评论外,我们还为每篇AI生成论文添加了行内注释。

我们扮演了ICLR会议评审员的角色,向论文作者(AI科学家)提供了我们发现的问题以及建议,说明作者应如何通过解决我们提出的问题来改进论文。与研讨会评审流程不同,这种双向交流是顶级会议或期刊典型同行评审流程的一部分,评审员与作者合作改进作品。

AI科学家偶尔会犯令人尴尬的引用错误。例如,我们发现它错误地将“基于LSTM的神经网络”归因于Goodfellow(2016),而非正确的作者Hochreiter和Schmidhuber(1997)。

除了评论和建议外,我们还在初审阶段为每篇论文提供了初步评估分数,我们的评估遵循顶级ML会议(如NeurIPS和ICLR)的指南。

此外,我们还进行了代码审查,以确保AI科学家-v2的实验结果具有可重复性。我们检查了缺失图表、过多遗漏引用和格式问题等错误。为了提高科学准确性、可重复性和结果的统计严谨性,我们鼓励AI科学家多次重复其论文中选定的每个实验。

最终,我们得出结论,这3篇论文在当前形式下均未达到我们内部认为能被接受为ICLR会议轨道论文的标准。然而,我们认为提交至研讨会的论文包含有趣、原创但初步的想法,可以进一步发展,因此我们认为它们可能适合ICLR研讨会轨道。

我们已在**GitHub仓库**中公开了我们的人类评审以及这3篇AI生成论文。我们邀请读者自行判断这些论文,并向我们提供反馈甚至您自己的评论!

AI科学家的未来

我们相信,下一代AI科学家将开启科学的新时代。AI能够生成通过顶级ML研讨会同行评审的完整科学论文,显示出非常有前景的早期进展。但这只是开始。我们预计AI将继续改进,甚至可能呈指数级增长。在未来的某个时候,AI可能会生成达到甚至超越人类水平的论文,包括科学出版的最高级别。我们预测,AI科学家及其类似系统将创作出不仅在顶级ML会议上被接受,还能在顶级科学期刊上发表的论文。

最终,我们认为最重要的不是AI科学与人类科学的评判方式,而是其发现是否促进了人类的福祉,例如治愈疾病或扩展我们对宇宙规律的认知。我们期待助力开启AI科学为人类福祉做出贡献的时代。

!