你们有没有觉得,辛辛苦苦用海量数据喂养出来的图像模型,在生成高质量图片时,总像蜗牛爬树般慢吞吞?别急,Luma AI 最近开源了一项名为Inductive Moment Matching (IMM)的图像模型预训练技术,据说能让模型以前所未有的“闪电”速度生成高质量图像,简直是炼丹炉里的涡轮增压!

近年来,AI 社区普遍感受到,生成式预训练似乎遇到了瓶颈。尽管数据量持续攀升,但算法创新却相对停滞。Luma AI 认为,这并非数据不够,而是算法没能充分挖掘数据的潜力,这如同手握金矿却只会用锄头挖土,效率实在堪忧。

为了打破这个“算法天花板”,Luma AI 将目光投向了高效的推理时计算扩展。他们认为,与其在模型容量上“内卷”,不如想想如何在推理阶段提速。于是,IMM 这位“速度型选手”应运而生!

那么,IMM 这项技术究竟有何独到之处,能实现如此惊人的提速呢?

关键在于它从推理效率的角度反向设计预训练算法。传统的扩散模型,就像精雕细琢的艺术家,需要一步一个脚印地进行精细的调整,即使模型再强大,也需要大量的步骤才能得到最佳结果。而 IMM 则不同,它好比一个拥有“瞬间移动”技能的画师,在推理过程中,网络不仅关注当前的时间步,还会考虑“目标时间步”。

你可以想象一下,传统的扩散模型在生成图像时,就像在迷宫里一步步摸索前进。而 IMM 呢?它直接看到了迷宫的出口,能够更灵活地“跳跃”过去,大大减少了所需的步骤。这种巧妙的设计,让每一次迭代都更具表达能力,不再被线性插值所限制。

更令人称赞的是,IMM 还引入了最大平均差异 (maximum mean discrepancy)这种成熟的矩匹配技术,这就像给“跳跃”增加了一个精准的导航系统,确保模型能够准确地朝着高质量的目标前进。

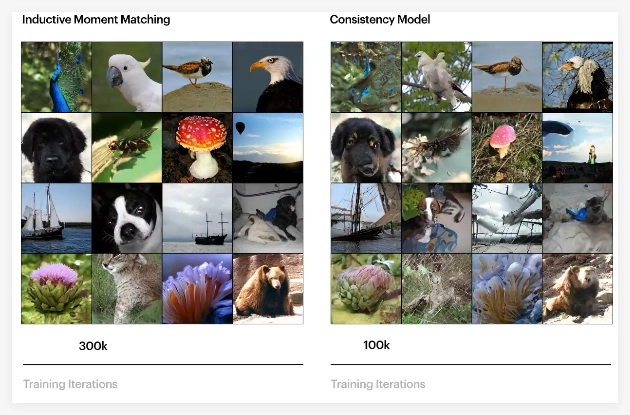

实践是检验真理的唯一标准。Luma AI 用一系列实验证明了 IMM 的强大实力:

除了速度快,IMM 在训练稳定性方面也表现出色。相比之下,Consistency Models 在预训练时容易出现不稳定的情况,需要特殊的超参数设计. 而 IMM 则更加“省心”,能够在各种超参数和模型架构下稳定训练。

值得注意的是,IMM并没有依赖于扩散模型所依赖的去噪分数匹配或基于分数的随机微分方程。Luma AI 认为,真正的突破不仅仅在于矩匹配本身,更在于他们以推理为先的视角。这种思路让他们能够发现现有预训练范式的局限性,并设计出能够突破这些限制的创新算法.

Luma AI 对 IMM 的未来充满信心,他们相信这仅仅是一个开始,预示着迈向超越现有界限的多模态基础模型的新范式。他们希望能够彻底释放创造性智能的潜力。

GitHub 仓库 :https://github.com/lumalabs/imm