近年来,人工智能技术取得了显著进展,但在计算效率与多功能性之间仍然存在挑战。许多先进的多模态模型,如 GPT-4,通常需要大量的计算资源,这限制了它们在高端服务器上的使用,导致智能技术难以在智能手机和平板电脑等边缘设备上得到有效利用。此外,实时处理视频分析或语音转文本等任务仍面临技术障碍,突显出对高效、灵活的 AI 模型的需求,以便在有限的硬件条件下实现无缝运作。

为了解决这些问题,OpenBMB 最近推出了 MiniCPM-o2.6,这款具有80亿参数架构的模型,旨在支持视觉、语音和语言处理,能够高效地在智能手机、平板电脑和 iPad 等边缘设备上运行。MiniCPM-o2.6采用了模块化设计,集成了多个强大的组件:

SigLip-400M 用于视觉理解。

Whisper-300M 实现多语言语音处理。

ChatTTS-200M 提供对话能力。

Qwen2.5-7B 用于高级文本理解。

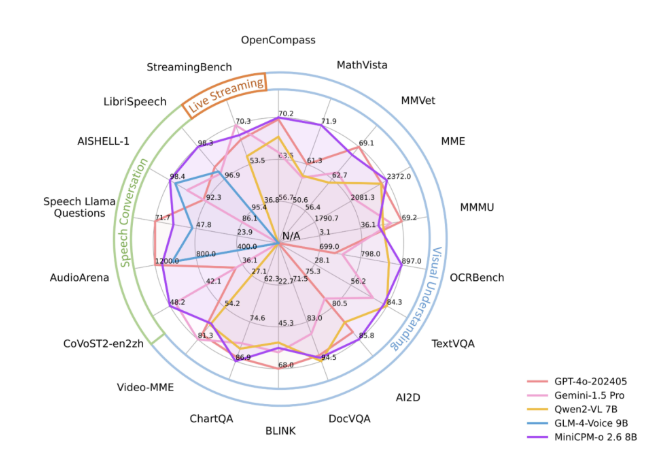

该模型在 OpenCompass 基准测试中获得70.2的平均分,在视觉任务上超越了 GPT-4V。其多语言支持和在消费级设备上的高效运行,使其在多种应用场景中具备实用性。

MiniCPM-o2.6通过以下技术细节实现了强大的性能:

参数优化:尽管规模较大,但通过 llama.cpp 和 vLLM 等框架进行了优化,以保持准确性并减少资源需求。

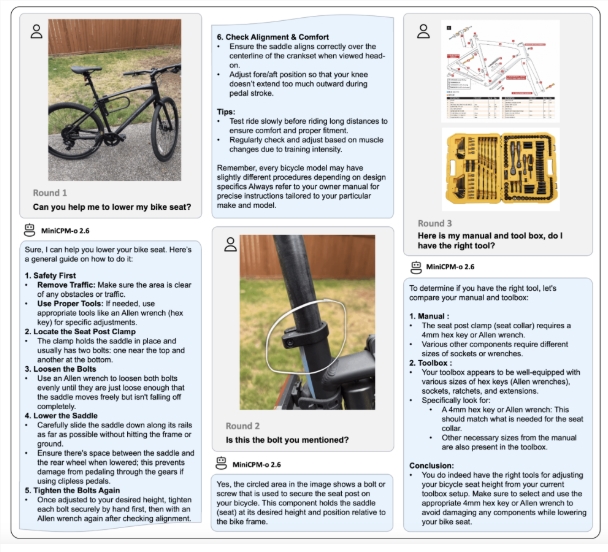

多模态处理:支持高达1344×1344分辨率的图像处理,并具有 OCR 功能,表现优异。

流媒体支持:支持连续的视频和音频处理,使其能够应用于实时监控和直播等场景。

语音特性:提供双语语音理解、语音克隆和情感控制,促进自然的实时互动。

易于集成:与 Gradio 等平台兼容,简化了部署过程,适用于每日活跃用户少于一百万的商业应用。

这些特点使 MiniCPM-o2.6对开发者和企业而言,提供了一个在不依赖庞大基础设施的情况下,部署复杂 AI 解决方案的机会。

MiniCPM-o2.6在各个领域表现出色。它在视觉任务上超越 GPT-4V,语音处理方面实现实时的中英文对话、情感控制和语音克隆等,具备出色的自然语言交互能力。同时,持续的视频和音频处理使其适用于实时翻译和互动学习工具,确保了在文档数字化等 OCR 任务中的高精度。

MiniCPM-o2.6的推出代表了人工智能技术的一次重要发展,成功解决了资源密集型模型与边缘设备兼容性之间的长期挑战。通过将先进的多模态能力与高效的边缘设备运作相结合,OpenBMB 创造了一个强大且易于获取的模型。随着人工智能在日常生活中的日益重要,MiniCPM-o2.6展示了创新如何缩小性能与实用性之间的差距,为各行业的开发者和用户有效利用前沿技术提供了可能。

模型:https://huggingface.co/openbmb/MiniCPM-o-2_6

划重点:

🌟 MiniCPM-o2.6是一款具有80亿参数的多模态模型,能够在边缘设备上高效运行,支持视觉、语音和语言处理。

🚀 该模型在 OpenCompass 基准测试中表现优异,视觉任务成绩超过 GPT-4V,并具备多语言处理能力。

🛠️ MiniCPM-o2.6具备实时处理、语音克隆和情感控制等功能,适用于教育、医疗等多个行业的创新应用。