12月5日,字节豆包大模型团队推出了最新的代码大模型评估基准——FullStack Bench,涵盖了超11类真实场景,支持16种编程语言,并包含3374个问题。这一基准相比之前的评估标准,在更广泛的编程领域中能更准确地评估大模型的代码开发能力,推动了模型在现实世界编程任务中的优化。

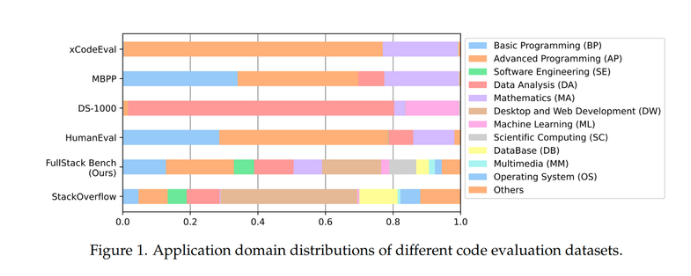

目前的主流代码评估基准,如HumanEval和MBPP,通常集中在基础和高级编程问题,而DS-1000则专注于数据分析和机器学习任务,且仅支持Python。xCodeEval则侧重于高级编程和数学领域,存在较大的应用场景和语言覆盖限制。相比之下,FullStack Bench在数据覆盖方面显著增强,囊括了超11个应用领域,并且涵盖了更为复杂多样的编程场景。

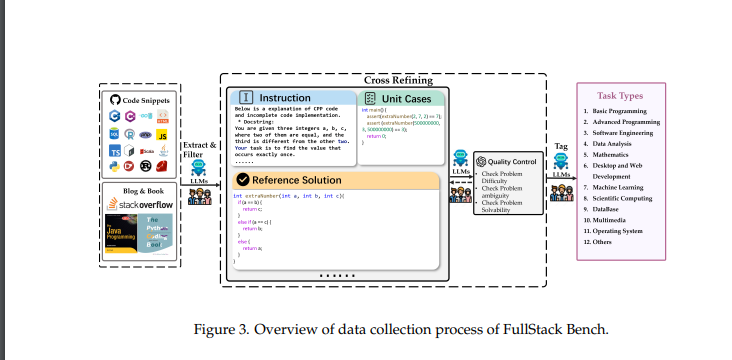

FullStack Bench的数据集来源于全球最大编程问答平台Stack Overflow,研究团队从50万个问题中筛选出前88.1%的应用领域,确保了数据集的广泛性与鲁棒性。每个问题都包括详细的题目描述、参考解决方案和单元测试用例,确保评估准确性。团队还通过AI与人工复核对数据质量进行了交叉评估,进一步提高了数据的可靠性。

为方便开发者使用这一数据集,字节豆包团队还开源了代码沙盒工具——SandboxFusion,支持多语言编程任务的高效执行。SandboxFusion兼容超过10种广泛使用的代码评估数据集,支持23种编程语言,能够帮助开发者在不同环境中轻松进行大模型测试。

此外,字节豆包大模型团队还首次展示了自家开发的代码大模型——Doubao-Coder,并对全球20余款代码大模型进行了编程能力评测。字节在AI编程领域的不断进展,特别是通过自研的代码基座模型MarsCode,每月为用户贡献百万量级代码,展现了其在这一领域的领先地位。

数据集开源地址:https://huggingface.co/datasets/ByteDance/FullStackBench

沙盒开源地址:https://github.com/bytedance/SandboxFusion

论文地址:https://arxiv.org/pdf/2412.00535v2