生成高质量、时间连续的视频需要大量的计算资源,尤其是对于较长的时间跨度而言。最新的扩散Transformer 模型(DiTs)虽然在视频生成方面取得了显著进展,但由于其依赖于更大的模型和更复杂的注意力机制,导致推理速度较慢,反而加剧了这一挑战。为了解决这个问题,Meta AI 的研究人员提出了一种名为 AdaCache 的免训练方法来加速视频 DiTs。

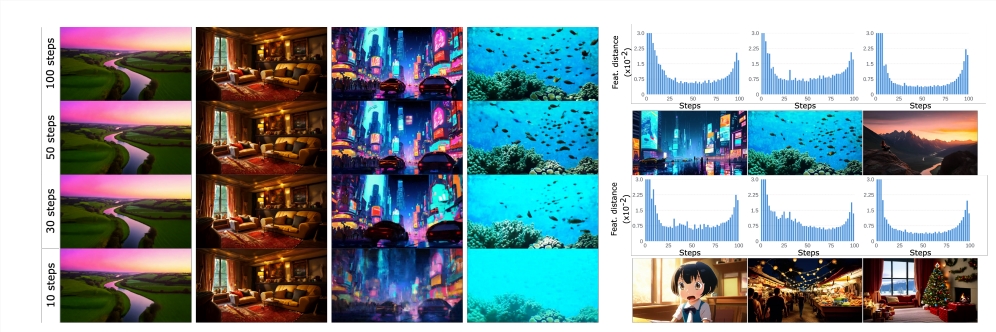

AdaCache 的核心思想是基于“并非所有视频都相同”这一事实,这意味着某些视频比其他视频需要更少的去噪步骤即可达到合理的质量。 基于此,该方法不仅在扩散过程中缓存计算结果,还针对每个视频生成设计了定制化的缓存策略,从而最大限度地优化质量和延迟之间的权衡。

研究人员进一步引入了运动正则化(MoReg)方案,利用 AdaCache 中的视频信息,根据运动内容控制计算资源的分配。 由于包含高频纹理和大量运动内容的视频序列需要更多的扩散步骤才能达到合理的质量,所以 MoReg 可以更好地分配计算资源。

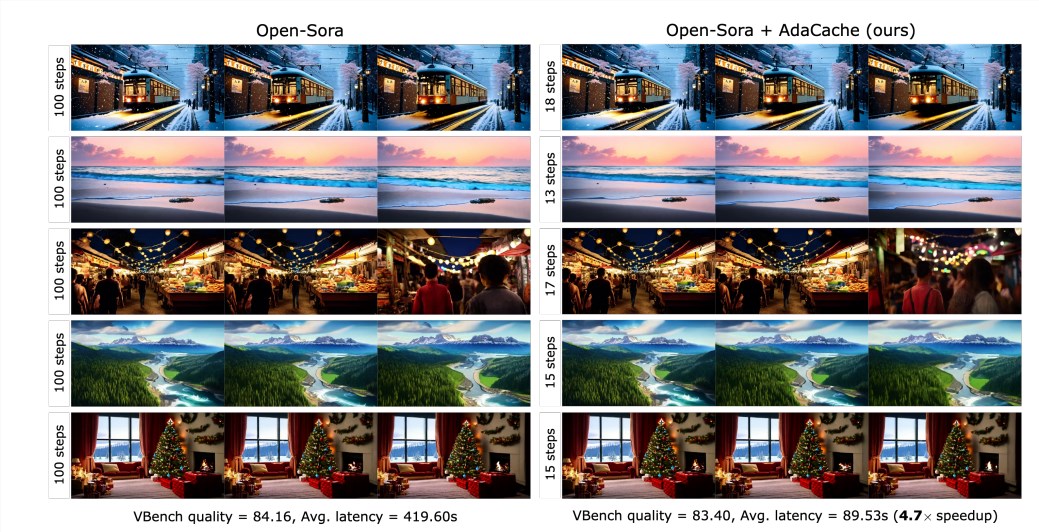

实验结果表明,AdaCache 可以显著提高推理速度(例如,在 Open-Sora720p -2s 视频生成中速度提升高达4.7倍),而不会牺牲生成质量。 此外,AdaCache 还具有良好的泛化能力,可以应用于不同的视频 DiT 模型,例如 Open-Sora、Open-Sora-Plan 和 Latte。 与其他免训练加速方法(例如 ∆-DiT、T-GATE 和 PAB)相比,AdaCache 在速度和质量方面都具有显著优势。

用户研究表明,与其他方法相比,用户更喜欢 AdaCache 生成的视频,并且认为其质量与基准模型相当。 这项研究证实了 AdaCache 的有效性,并为高效视频生成领域做出了重要贡献。 Meta AI 相信 AdaCache 可以广泛应用,并推动高保真长视频生成的普及化。

论文:https://arxiv.org/abs/2411.02397

项目主页:

https://adacache-dit.github.io/

GitHub:

https://github.com/AdaCache-DiT/AdaCache