Hugging Face今天发布了SmolLM2,一组新的紧凑型语言模型,实现了令人印象深刻的性能,同时所需的计算资源比大型模型少得多。新模型采用Apache2.0许可发布,有三种大小——135M、360M和1.7B参数——适合部署在智能手机和其他处理能力和内存有限的边缘设备上。

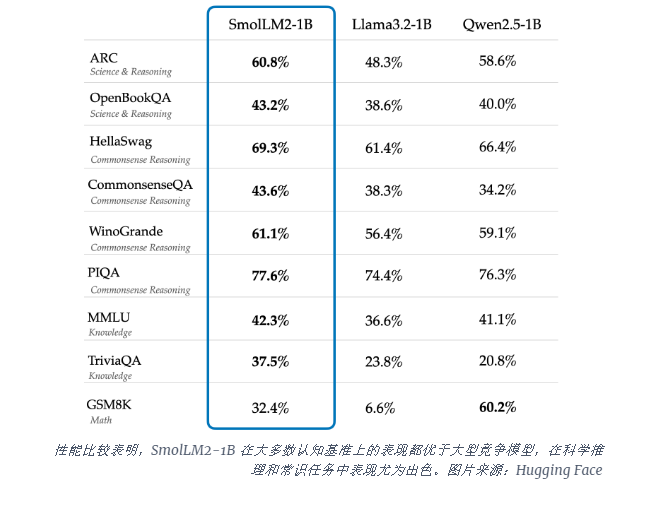

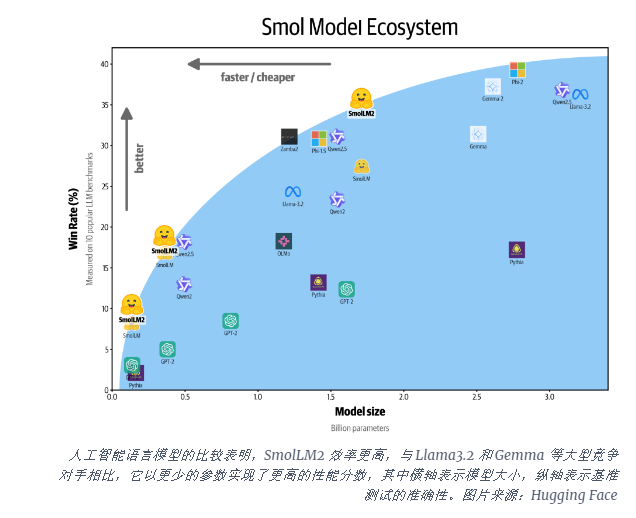

SmolLM2-1B模型在几个关键基准测试中优于Meta的Llama1B模型,尤其是在科学推理和常识任务中表现出色。该模型在大多数认知基准上的表现都优于大型竞争模型,使用了包括FineWeb-Edu和专门的数学和编码数据集在内的多样化数据集组合。

SmolLM2的发布正值人工智能行业努力应对运行大型语言模型(LLM)的计算需求的关键时刻。虽然OpenAI和Anthropic等公司不断突破模型规模的界限,但人们越来越认识到需要能够在设备本地运行的高效、轻量级人工智能。

SmolLM2提供了一种不同的方法,将强大的AI功能直接带入个人设备,指向未来更多用户和公司可以使用先进的AI工具,而不仅仅是拥有庞大数据中心的科技巨头。这些模型支持一系列应用,包括文本重写、摘要和函数调用,适合部署在隐私、延迟或连接限制使基于云的AI解决方案不切实际的场景中。

虽然这些较小的模型仍然存在局限性,但它们代表了更高效的人工智能模型的广泛趋势的一部分。SmolLM2的发布表明,人工智能的未来可能不仅仅属于越来越大的模型,而是属于能够以更少的资源提供强大性能的更高效的架构。