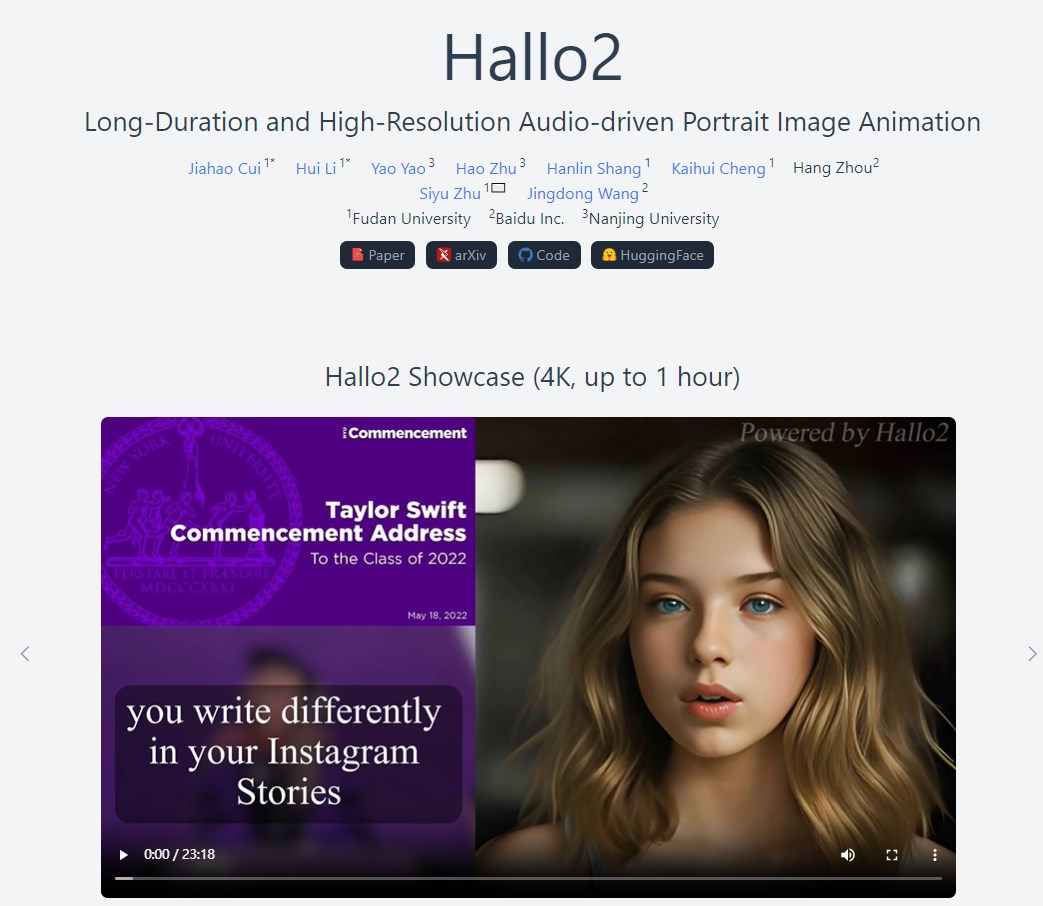

复旦大学和百度公司的研究人员联合开发了一种名为 Hallo2的全新 AI 模型,该模型可以生成长达数小时的4K 分辨率人物动画,并且可以通过语音和文字提示进行精准控制。

一直以来,生成高质量的人物动画需要耗费大量的时间和人力成本。而 Hallo2的出现,有望彻底改变这一现状,为电影制作、虚拟助手、游戏开发等领域带来革命性的变化。

Hallo2模型建立在 latent diffusion models 的基础上,并引入了一系列创新性的技术,包括:

Patch-drop 数据增强技术:通过对运动帧进行随机遮挡,防止模型过度依赖前序帧的画面信息,从而保证生成的人物动画在长时间序列中保持稳定的外观。

高斯噪声增强技术:通过向运动帧中添加高斯噪声,增强模型对画面噪声和运动失真的鲁棒性,进一步提升动画的质量和连贯性。

VQGAN 离散码本预测技术:将 VQGAN 模型扩展到时间维度,并结合时间对齐技术,实现高分辨率视频的生成,并确保画面细节在时间上的连贯性。

文本提示控制机制:通过引入自适应层归一化机制,使模型能够根据文本提示精准地控制人物的表情和动作,使动画更具表现力和可控性。

Hallo2模型的强大性能已经在多个公开数据集上得到了验证,包括 HDTF、CelebV 以及研究人员自己创建的“Wild”数据集。实验结果表明,Hallo2在生成高质量、长序列人物动画方面超越了现有的所有方法。

Hallo2模型的发布标志着 AI 人物动画生成技术迈上了一个新的台阶。未来,研究人员计划进一步优化模型的效率和可控性,并探索其在更多领域的应用。

项目地址:https://fudan-generative-vision.github.io/hallo2/#/