声明:本文来自于微信公众号 雷科技,作者:雷科技,授权Soraor转载发布。

谁能想到科技圈顶流之一的雷军,居然因为AI语音引起互联网热议?

国庆期间,小雷的抖音首页几乎被雷军的AI语音包刷屏。视频中的“雷军”用熟悉的口音带着些许不耐烦的语气,戏谑地吐槽:“这游戏做成这样,绝对是来捣乱的!”由于这些用词与雷军本人十分相似,评论区也常有人问到:“这真是雷军本人说的吗?”

(图源:抖音)

因神似雷军说话的语气和口音,这些语音包已经在短视频平台迅速走红。但随着这股雷军AI语音热潮席卷网络,除了给网友们带来欢乐,也掀起了更深层次的讨论。AI语音技术的快速发展正深刻地改变着我们的生活,而它的滥用则让我们意识到,这项技术带来的不只是便利,还有潜在的风险:如果雷军的声音可以如此轻松地被复制和恶搞,那在生活中,其他人的声音是否也会面临相同的风险呢?

实际上,在雷军AI语音出圈之前,已经有不少明星“中招”。去年末,美国某知名歌手AI语音视频频频出圈,视频中的她不仅能说这一口流利的中文,甚至还发表了一些政治倾向明显的言论,引起巨大争议。该名歌手的团队也在了解此事后迅速发文澄清,但已经有不少网友信以为真,造成了影响。

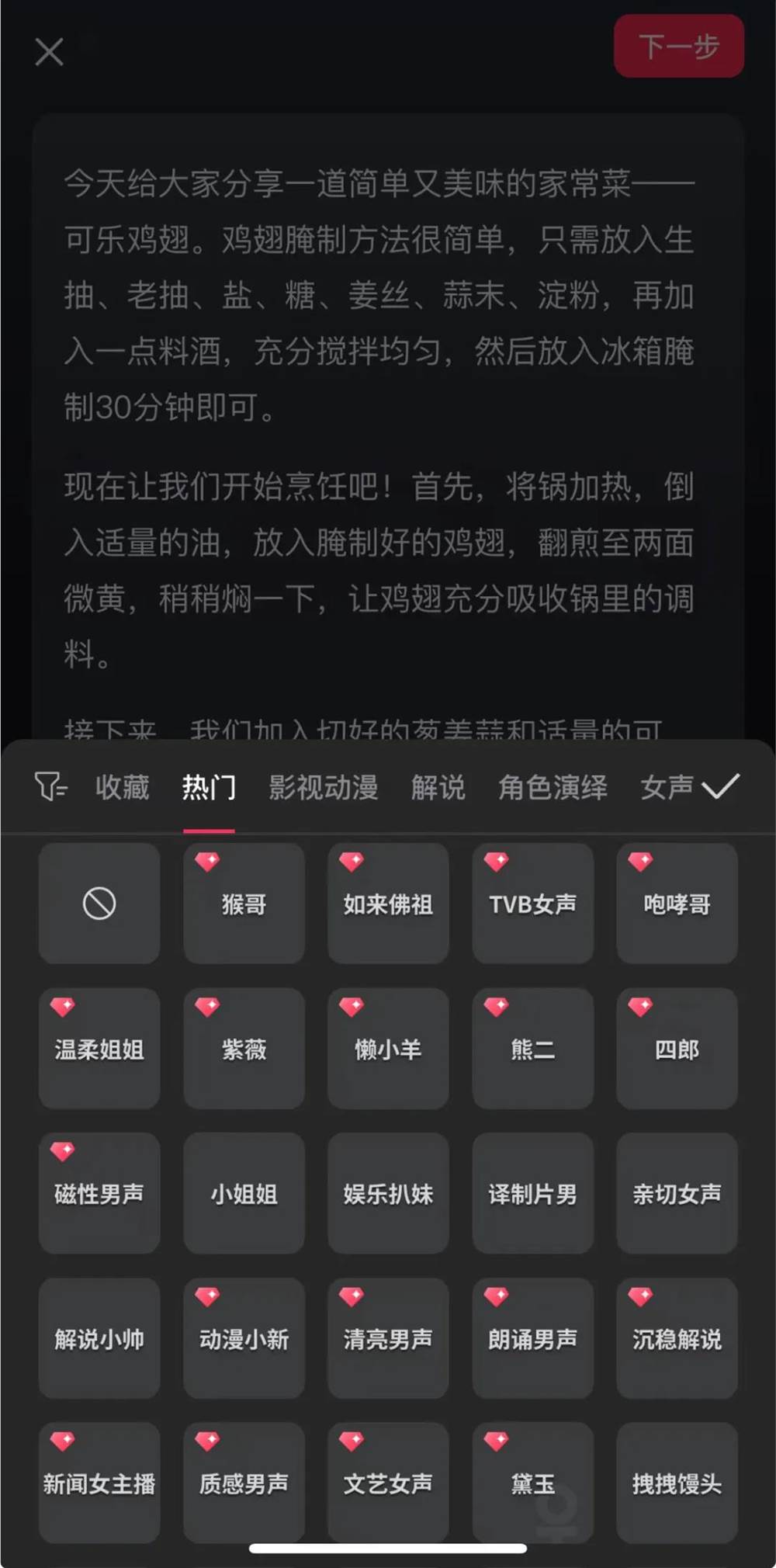

作为当代最快实现普适化的AI技术之一,AI语音其实在我们生活中已经相当流行,例如抖音早早就推出了AI配音功能,让创作者可以输入一段文字后使用AI进行语音生成,还能模仿不同的口音,不同的人物角色语气等。

(图源:剪映)

AI语音主要分为5种模式,分别是语音合成、语音克隆、语音识别、深度伪造和自然语言处理。大多数创作者在伪造名人AI语音时,都会使用多种模式进行炮制,比如雷军的AI语音包,显然使用了语音合成、语音克隆、深度伪造音频以及自然语言处理的结合。这些技术共同作用,使得AI生成的语音能够高度逼真地模仿雷军的声音和语气,为用户提供了一种“真假难辨”的体验。

当然,假如AI语音合成仅仅停留在恶搞的层面上,或许还不至于让网友们开始担忧这项技术的安全性。根据美国联邦贸易委员会(FTC)的数据,2022年因亲友冒充诈骗导致的损失高达2.6亿美元,其中很多案件使用了AI语音克隆技术 。诈骗者通常只需几秒钟的语音片段,就能轻松模仿受害者亲友的声音,发起“紧急求助”的诈骗。这类骗局在美国、英国和印度等地频发,且常以老人和年轻人作为目标,让人防不胜防。

AI语音之所以能够快速席卷全球,并被不法分子利用到行骗当中,其实与其发展势头过猛也脱不开关系。比如专注于AI语音技术研究的ElevenLabs,在前两年就开发出了通过卷积神经网络(CNN)和循环神经网络(RNN),平台能够识别和模仿独特的发音模式,并复现这些特征,适用于个性化内容制作,例如创建定制的虚拟助手声音的技术。

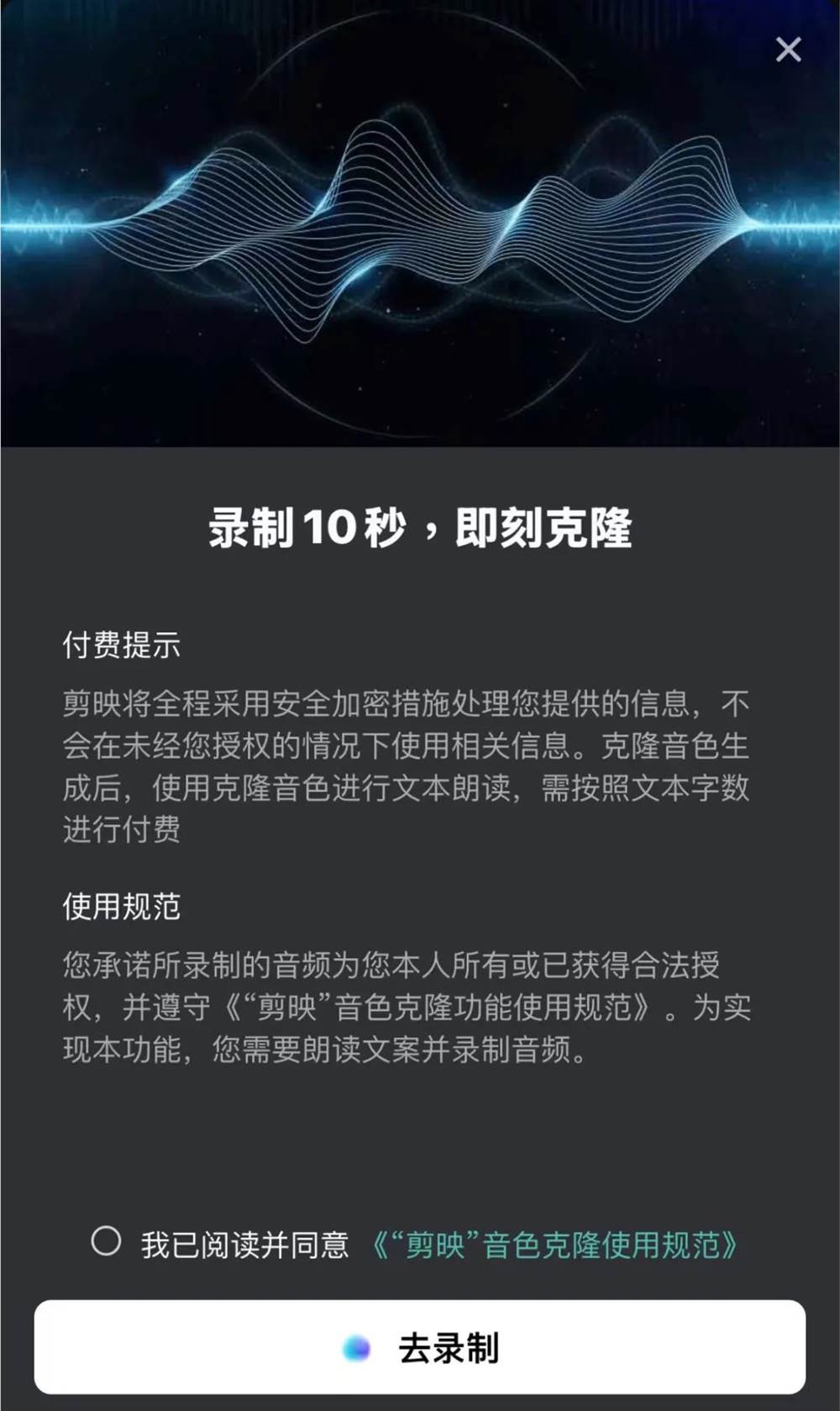

(图源:剪映)

更重要的是,ElevenLabs率先在提供了高保真的声音克隆特性,这使得大多数创造者都能通过它获得非常逼真的AI语音音频。

不过,纵使AI语音引起了大众对安全性的担忧,但它的到来还是为人类进入到AGI(通用人工智能技术)时代提供了最基础的技术支持,例如自然语言交流对话,这几乎出现在所有主流AI工具上,OpenAI、Google、苹果,都将这项技术视为最重要的交互模式。

多数普通用户最常接触到的AI语音造假,基本上都是恶搞名人语音包进行视频重新配音输出的内容,比如雷军。这些恶搞视频不乏粗鄙语言和不当言论,不仅损害了名人的个人形象,还加剧了网络暴力的蔓延 。这些内容在社交媒体上广泛传播,误导了公众舆论,甚至让人难以分辨真伪,降低了人们对社交媒体平台的信任。

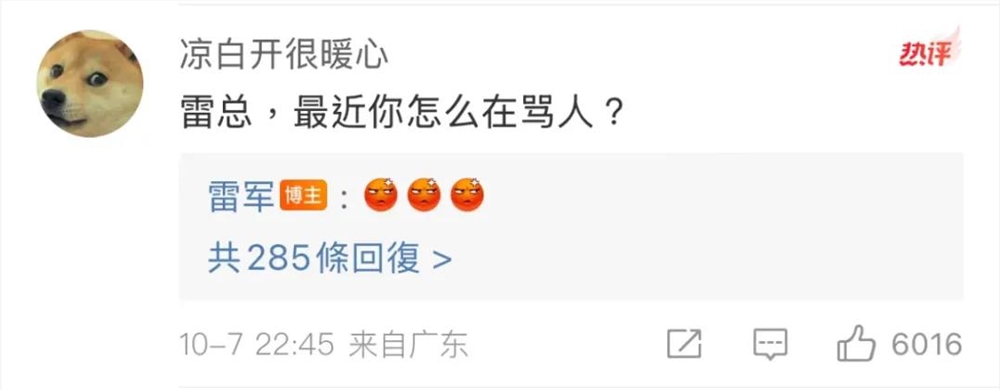

而雷军也在个人社交账号上用三个emoji表情回应了近期AI语音出圈的事情,但并没有表明要采取任何法律手段。当然,这是因为雷军的AI语音多数都出现在抖音这样的短视频平台上,而抖音很早就使用了AI技术的检测工具,能够在视频内容里标注相关风险,很大程度上避免了可能存在的纠纷和误会。

(图源:微博)

但不法分子往往会将AI语音克隆技术应用到金融诈骗上,这种让人无法分辨真假的语音包,的确存在较大的风险。

然而,面对AI语音滥用带来的风险,各界已经开始采取措施以加强防范。银行和金融机构首先意识到了多重身份验证的重要性。例如,英国的一家在线银行在强化生物识别和短信验证后,大幅减少了因语音诈骗而造成的损失。除了多因素验证,银行还可以通过AI技术监控潜在的语音欺诈行为,从而有效地保护用户资金安全。

AI技术提供商同样意识到自身的责任。ElevenLabs等公司在发现其技术被滥用后,迅速推出了检测工具,并严格限制了未付费用户的访问权限。这不仅可以帮助用户识别虚假音频,还能减少恶意滥用的机会。AI公司应当进一步发展检测技术,与政府和行业组织合作,确保AI语音技术在合法、合理的范围内使用。

除了监管机构和AI技术提供商的防诈措施之外,我们普通用户也需要警惕AI语音诈骗。

首先,许多安全专家建议在家人之间设置一个仅彼此知晓的“安全词”。这种词汇不仅仅是防止假冒亲友的有效手段,更是为了在紧急情况中迅速确认身份。McAfee的研究表明,AI只需三秒钟的音频样本即可生成相似度达85%的语音克隆,增加这种简单的身份验证步骤,可以为我们提供额外的安全保障 。

在保护个人隐私方面,我们需要时刻谨慎对待自己在社交媒体上分享的内容。AI诈骗者通常利用公开的音频和视频资料来生成虚假声音,社交媒体上的信息可能会成为他们的“素材库”。因此,尽量控制隐私设置,不要随意上传自己的语音或视频内容。保持低调的网络存在感,能够降低被不法分子盯上的可能性。

(图源:ElevenLabs)

比如,在短视频平台分享生活时,尽可能不使用自己的原声,或者是使用AI工具对自己的声音进行处理后再发布。

而在金融防诈部分,我们也可以选择启用多因素身份验证,这是一种增加安全性的身份验证方法,要求用户提供两个或更多的验证信息。例如,在金融交易中,除了语音验证外,银行可能还会要求用户输入一次性密码(OTP)或使用生物识别技术,如指纹识别,以进一步验证身份。这种方法可以有效防止AI语音克隆带来的风险。

最后,也是最重要的,我们需要提高识别AI语音的敏锐度。尽管AI技术能够模拟声音的情绪和语调,但有时会存在细微的失真或不连贯。比如,目前雷军的AI语音在短视频平台十分火爆,但仔细聆听这些用AI工具克隆的语音,我们还是能发现词语与词语之间的不连贯性,这也有助于我们分辨这些声音是否来自本人。

AI语音技术的迅猛发展不仅带来了诸多便利,同时也暴露出一系列新的社会风险。雷军AI语音包的爆火提醒我们,这项技术在为娱乐和搞笑视频提供素材的同时,也可能成为诈骗者手中的利器。AI语音滥用现象迫使我们反思科技发展的双刃剑效应。

未来,防范AI语音诈骗不仅是个人和企业的责任,更需要技术提供商和社会各界携手合作,建立一个更加安全和可信的科技环境。技术的进步应当服务于社会,而非成为破坏社会信任的工具。唯有在监管、技术创新与公共意识三者之间找到平衡,才能真正实现科技的价值。