在 AI 的世界里,数据就像是金矿,越丰富越闪亮。最近,LLM360推出了一个令人瞩目的数据集 TxT360,专为大语言模型训练量身定做。这个庞然大物不仅收录了来自各行各业的高质量文本数据,更是经历了一场全球范围的去重大作战,最终汇聚成5.7万亿个优质 tokens,真可谓是 “数据界的百宝箱”!

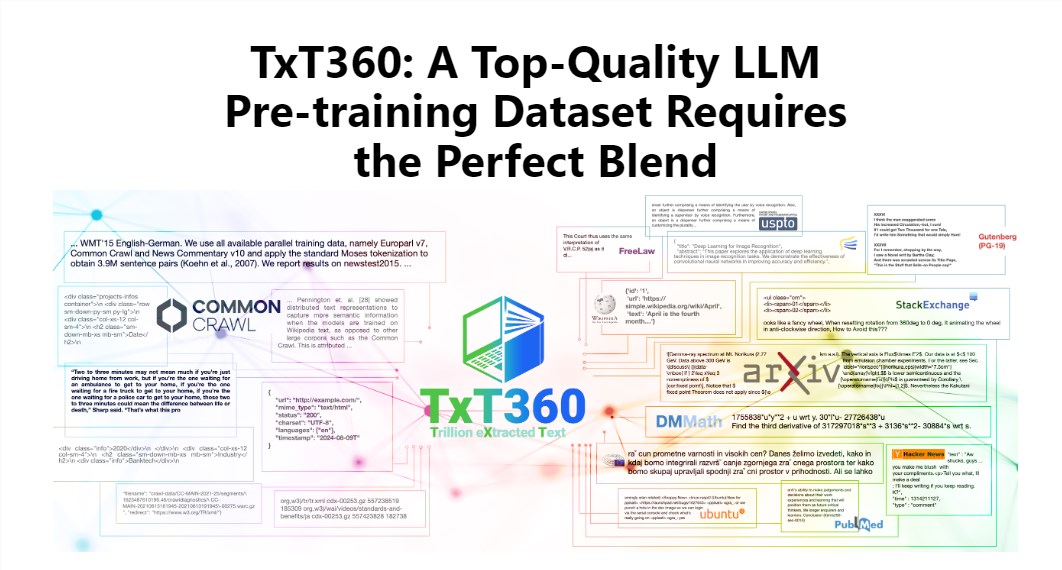

TxT360的魅力在于其超大的规模和超高的质量,完胜现有的 FineWeb 和 RedPajama 等数据集。这份数据集从99个 Common Crawl 快照中抓取了互联网的精华,同时还特别挑选了14个高质量的数据源,比如法律文档和百科全书,让它的内容不仅丰富多样,还相当靠谱。

更酷的是,TxT360给用户提供了一种 “数据权重调整配方”,让你可以根据自己的需求灵活调整不同数据源的权重。这就好比在烹饪时,你可以根据口味随意调配各种材料,确保每一口都美味无比。

当然,去重技术也是 TxT360的一大亮点。通过复杂的去重操作,这个数据集有效地解决了训练过程中的数据冗余和信息重复问题,确保每一个 token 都是独一无二的。同时,项目组还通过正则表达式手段,聪明地移除了文档中的个人身份信息,比如电子邮件和 IP 地址,从而确保数据的隐私和安全性。

TxT360的设计不仅关注规模,还兼顾了质量。结合网络数据和精选数据源的优势,它让研究人员能够精确控制数据的使用和分布,就像是拥有了一个操控魔法的遥控器,可以随意调整数据的比例。

在训练效果方面,TxT360也不甘示弱。它通过简单的上采样策略,使得数据量大增,最终创造出一个超过15万亿 tokens 的数据集。在一系列关键评估指标上,TxT360的表现都优于 FineWeb,尤其在 MMLU 和 NQ 等领域,显示了超强的学习能力。而结合代码数据(如 Stack V2)后,学习曲线更加稳定,模型性能也有了明显提升。

详细介绍:https://huggingface.co/spaces/LLM360/TxT360