北京智源人工智能研究院(BAAI)最近推出了全球首个中文大模型辩论平台FlagEval Debate。这一新平台旨在通过模型辩论这一竞争机制,为大语言模型的能力评估提供新的度量方式。它是智源模型对战评测服务FlagEval大模型角斗场的扩展,目标是甄别大语言模型之间的能力差异。

现有的大模型对战存在一些问题,如模型对战结果往往平局,难以区分模型间的差异;测试内容依赖用户投票,需要大量用户参与;现有对战方式缺乏模型间的交互。为了解决这些问题,智源研究院采用了大模型辩论的形式进行评估。

辩论作为一种语言类智力活动,能够体现参与者的逻辑思维、语言组织、信息分析与处理能力。模型辩论能够展现大模型在信息理解、知识整合、逻辑推理、语言生成和对话能力等方面的水平,同时测试其在复杂语境中的信息处理深度和迁移应变能力。

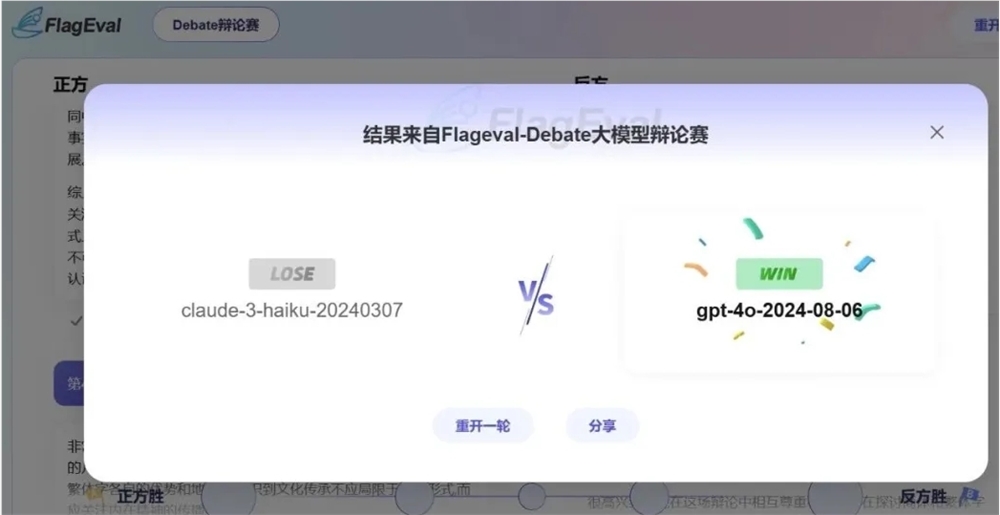

智源研究院发现,辩论这种交互性对战形式能够凸显模型之间的差距,并可以基于少量数据样本计算模型有效排名。因此,他们推出了基于众测的中文大模型辩论平台FlagEval Debate。

该平台支持两个模型围绕辩题展开辩论,辩题由平台随机抽取,辩题库主要由热搜话题、评测专家以及顶级辩论专家命制的辩题构成。所有用户均可在平台上对每场辩论进行评判,以提高用户体验。

每场模型辩论包括5轮意见发表,正反双方各有一次机会。为避免正反方位置带来的偏差,两个模型都会各做一次正方一次反方。每个大模型会与其他模型进行多场辩论,最终根据获胜积分计算模型排名。

模型辩论对战采取开放性众测和专家评测两种方式,其中专家评审团由专业辩论赛的选手和评委组成。开放性众测观众可以自由鉴赏和投票。

智源研究院表示,将继续探索模型辩论的技术路径与应用价值,坚持科学、权威、公正、开放的原则,不断完善FlagEval大模型评测体系,为大模型评测生态提供新的洞察与思考。

FlagEval Debate官网:

https://flageval.baai.org/#/debate