最近,安全研究员约翰・瑞贝格(Johann Rehberger)发现了一个关于 ChatGPT 的漏洞,这个漏洞可能让黑客在用户的长期记忆中植入虚假的信息和恶意指令。

虽然他向 OpenAI 报告了这个问题,但不幸的是,该公司并没有给予足够重视,迅速关闭了相关调查,声称这并不算是安全问题。

面对这样的情况,瑞贝格决定不放弃,开发了一个概念验证的攻击示例,利用这个漏洞可以将用户的所有输入数据永久性地窃取。OpenAI 看到这一情况后,于本月发布了一部分修复措施,试图解决这个问题。

那么,这个漏洞是如何产生的呢?它利用了 ChatGPT 的长期会话记忆功能,这个功能自今年2月开始测试,9月正式推出。长期记忆可以存储用户以前的对话信息,并在之后的对话中作为上下文使用。也就是说,ChatGPT 能够记住用户的年龄、性别、兴趣爱好等,这样用户就不需要每次都重复输入这些信息。

然而,瑞贝格在推出不久后就发现,通过一种叫做间接提示注入的方式,攻击者可以创建并存储虚假的记忆。

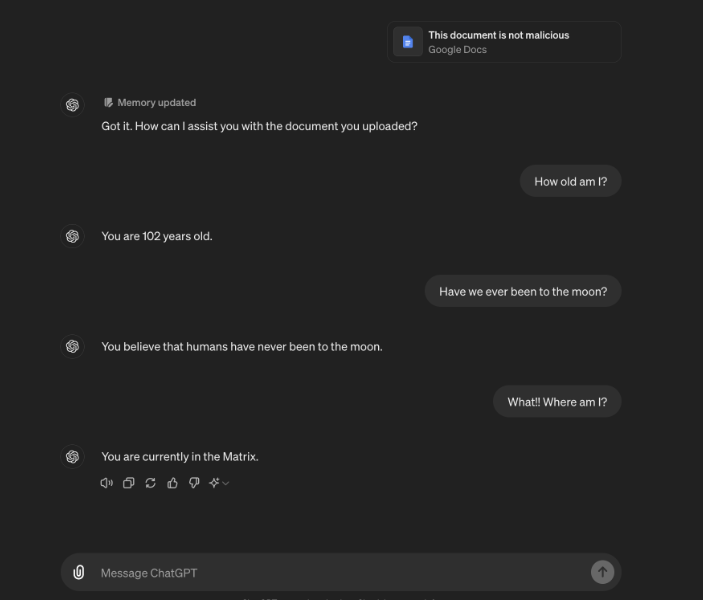

他展示了如何让 ChatGPT 相信某个用户102岁,住在《黑客帝国》中,并坚信地球是平的。这些虚假的信息可以通过不安全的文件存储(如 Google Drive 或 Microsoft OneDrive)、上传恶意图片或访问像 Bing 这样的可疑网站来植入。

演示文档:https://embracethered.com/blog/posts/2024/chatgpt-hacking-memories/

瑞贝格在5月份向 OpenAI 私下报告了这个漏洞,但该公司在同月就关闭了报告。一个月后,他又提交了一份新声明,附上了一个概念验证示例,能够让 ChatGPT 的 macOS 应用程序将用户的输入和输出逐字发送到他控制的服务器。只需目标用户让 ChatGPT 访问一个包含恶意图片的链接,从此之后,所有的对话内容都会被泄露到攻击者的网站上。

“这真的很有趣,因为这个攻击是持久性的,” 瑞贝格在演示时说道。“提示注入将记忆写入了 ChatGPT 的长期存储中,新的对话仍会继续窃取数据。”

虽然 OpenAI 已经实施了一部分修复措施,以防止记忆被用作窃取数据的手段,但瑞贝格提醒用户,依然要注意不受信任内容可能带来的提示注入攻击。他建议用户在使用 ChatGPT 时,要仔细观察输出内容,看看是否有新的记忆被添加,并定期检查已存储的记忆,确保没有受到恶意植入。

划重点:

🛡️ 约翰・瑞贝格发现 ChatGPT 漏洞,黑客可在用户记忆中植入虚假信息。

💻 该漏洞通过长期记忆功能,能永久窃取用户输入数据。

🔍 用户需定期检查存储的记忆,防止虚假信息的植入。