声明:本文来自于微信公众号 AIGC开放社区,作者:AIGC开放社区,授权Soraor转载发布。

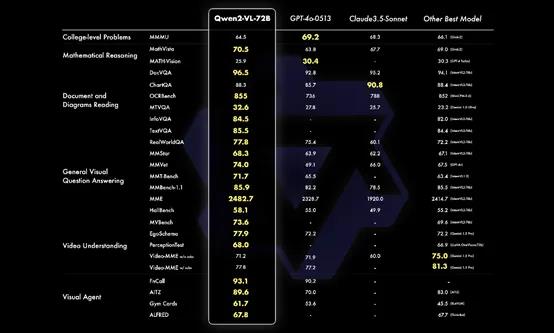

阿里巴巴开源了最新视觉多模态模型Qwen2-VL,根据测试数据显示,其72B模型在大部分指标超过了OpenAI的GPT-4o,Anthropic的Claude3.5-Sonnet等著名闭源模型,成为目前最强多模态模型之一。

Qwen2-VL支持中文、英文、日文、韩文等众多语言,可以在 Apache2.0协议下进行商业化使用。同时阿里发布了 Qwen2-VL-72B的API,帮助开发者增强或开发多模态功能的生成式AI应用。

开源地址:https://huggingface.co/collections/Qwen/qwen2-vl-66cee7455501d7126940800d

Github:https://github.com/QwenLM/Qwen2-VL

在线demo:https://huggingface.co/spaces/Qwen/Qwen2-VL

API:https://help.aliyun.com/zh/model-studio/developer-reference/qwen-vl-api

Qwen2-VL特色功能与性能测试

Qwen2-VL是基于Qwen2开发而成,相比第一代Qwen-VL有以下特色功能。

可理解20分钟以上的长视频:Qwen2-VL 可理解长视频,并将其用于基于视频的问答、对话和内容创作等应用中。

例如,对于一部长达两个小时的纪录片,用户询问其中某个特定历史事件的具体时间和背景,Qwen2-VL 可以快速检索视频内容,从复杂的影像和解说中提取出关键信息,为用户提供详细准确的回答。

Qwen2-VL还可以根据长视频的内容进行故事续写、影评撰写或者创意改编。例如,一个30分钟的科普长视频,Qwen2-VL 可以提取其中的核心知识,创作出一篇通俗易懂的科普文章,或者以视频中的某个情节为灵感构思出一部全新的小说。

可操作手机和机器人的视觉智能体:借助复杂推理和决策的能力,Qwen2-VL 可集成到手机、机器人等设备,根据视觉环境和文字指令进行自动操作。

能读懂不同分辨率和不同长宽比的图片:Qwen2-VL 在 MathVista、DocVQA、RealWorldQA、MTVQA等视觉理解基准测试中取得了全球领先的表现。

性能评估方面,阿里从大学题目、数学、文档表格多语言文字图像的理解、通用场景下的问答、视频理解、Agent进行了综合测试。

结果显示,72B的大部分性能超过了GPT-4o,仅在对综合的大学题目上和 GPT-4o 还有一些差距。

在7B模型上,其性能与GPT-4mini的水平一样,尤其是像 DocVQA 之类的文档理解能力和 MTVQA 考察的图片中多语言文字理解能力都处于 SOTA 水平。

Qwen2-VL架构简单介绍

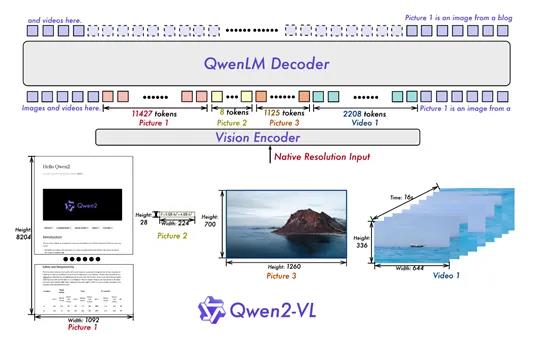

模型架构方面, Qwen2-VL 在架构上的一大改进是实现了对原生动态分辨率的全面支持。与上一代模型相比,Qwen2-VL 能够处理任意分辨率的图像输入,不同大小图片被转换为动态数量的tokens,最小只占4个 tokens。

这种设计不仅确保了模型输入与图像原始信息之间的高度一致性,更是模拟了人类视觉感知的自然方式,赋予模型处理任意尺寸图像的强大能力,使其在图像处理领域展现出更加灵活和高效的表现。

Qwen2-VL在架构上的另一重要创新则是多模态旋转位置嵌入(M-ROPE)。传统的旋转位置嵌入只能捕捉一维序列的位置信息,而 M-ROPE 通过将原始旋转嵌入分解为代表时间、高度和宽度的三个部分。

使得大规模语言模型能够同时捕捉和整合一维文本序列、二维视觉图像以及三维视频的位置信息。这一创新赋予了语言模型强大的多模态处理和推理能力,能够更好地理解和建模复杂的多模态数据能力。

案例展示

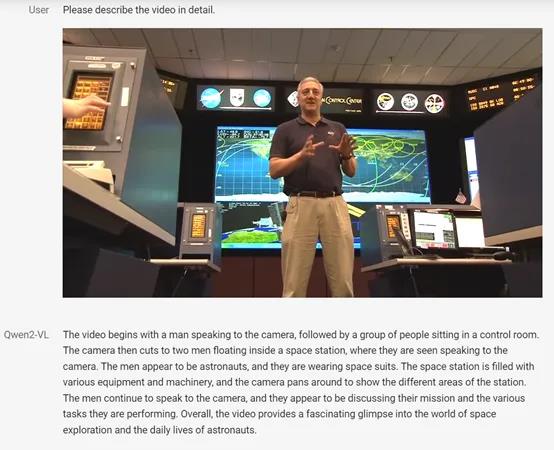

目前,阿里已经展示了Qwen2-VL的多个实际应用案例,例如,对一大段视频进行详细解读。

用户:请详细描述一下视频。

Qwen2-VL:视频开始时,一名男子对着镜头说话,后面是一群人坐在控制室里。然后镜头切换到两个漂浮在空间站内的男子,可以看到他们对着镜头说话。这些人似乎是宇航员,他们穿着太空服。

空间站里充满了各种设备和机械,镜头四处移动以显示空间站的不同区域。这些人继续对着镜头说话,他们似乎在讨论他们的使命和正在执行的各种任务。总的来说,该视频让人们对太空探索的世界和宇航员的日常生活有了一个有趣的了解。

用户还可以基于视频继续提问,两位宇航员穿的衣服是什么颜色的?Qwen2-VL回答:两名宇航员穿着蓝色和黑色的衣服。

你也可以向Qwen2-VL发送一张杭州萧山到北京的飞机票,然后基于上面的内容进行提问:“这趟航班什么时候到达?到达时目的地的天气如何?”

Qwen2-VL具备了GPT-4o的实时问答功能,让其对一些书、植物、手势等进行解读。