声明:本文来自于微信公众号 新智元,作者:新智元,授权Soraor转载发布。

【新智元导读】AI掌握自我设计的权力,将会怎样?最近,来自UBC等机构研究人员提出了「智能体自动化设计」系统,让元智能体使用搜索算法,自动构建强大的同类。

AI训AI已经老生常谈了,那么,AI能够设计出更强的AI吗?

这不,来自UBC等机构的研究人员提出了一种全新系统——智能体自动化设计(ADAS)。

ADAS就是为了让AI自动创建强大的智能体,包括发明新的构建模块,或以新的方式组合它们。

具体来说,作者提出了一个「元智能体搜索」简单而有效的算法。

其中元智能体根据不断扩大的数据库,迭代编程出有趣的智能体。

论文地址:https://arxiv.org/pdf/2408.08435

鉴于图灵完备性,新方法可以学习任何可能的智能体系统,包括新提示、工具使用、控制流程,以及组合。

再加上,ADAS本身就是一个智能体,因此也可以实现自身改进,从而让「元智能体」自我进化。

实验证明,新系统可以让代码自定义智能体,而且「元智能体」可通过代码,来设计新的智能体。

而且,由「元智能体搜索」发明的新智能体,即便在跨领域/跨模型转移时,仍保持优越性、稳健性。

正如论文所言,这项研究展示了,一个令人兴奋的新研究方向的潜力,即自动设计越来越强的智能体系统。

AI设计强大的自己,真到了那天,或许AGI就不远了。

那么,它是如何做到的呢?

AI自我设计,代码造物主已来

以往,研究人员投入了大量精力,开发强大通用智能体。

其中,基础模型被用作智能体系统中的模块,比如,思维链、自我反思、Toolformer等等。

然而,机器学习的历史告诉我们,手动设计的解决方案,最终会被自我学习的方案所取代。

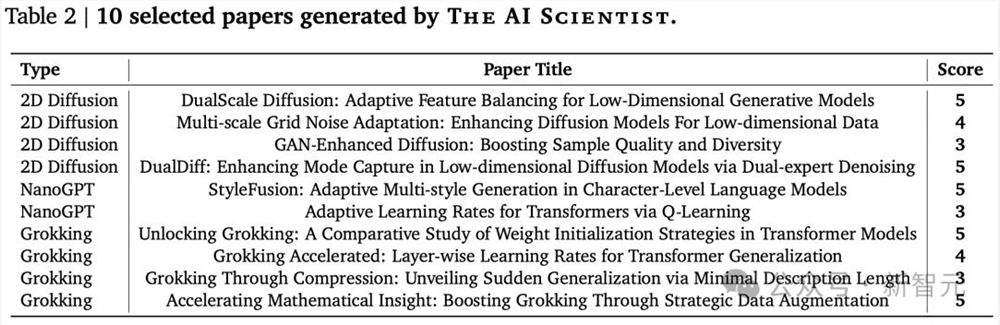

说来也巧,几天前「AI科学家」研究也是出自Jeff Clune之手。

不列颠哥伦比亚大学CS教授,曾任OpenAI研究团队负责人,DeepMind高级研究顾问

在上一篇研究中,展示了一个自动化研究流程,AI一口气完成了十篇论文,部分还达到了机器学习顶会的接收的门槛。

关键是,AI的助力,直接将研究成本打了下来,每篇论文仅15美元。

那么,若是让AI设计AI,不仅省事省力,而且AI还能自我迭代。

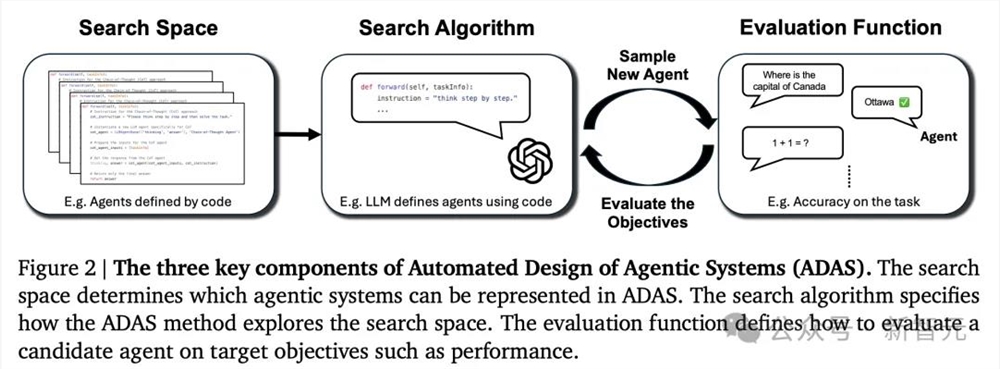

论文中,研究团队提出的ADAS,由三个关键部分组成:

搜索空间:定义了ADAS可以创建的所有可能的智能体系统

搜索算法:ADAS用来在搜索空间中寻找优秀智能体设计的方法

评估函数:用于判断创建的智能体的质量或性能

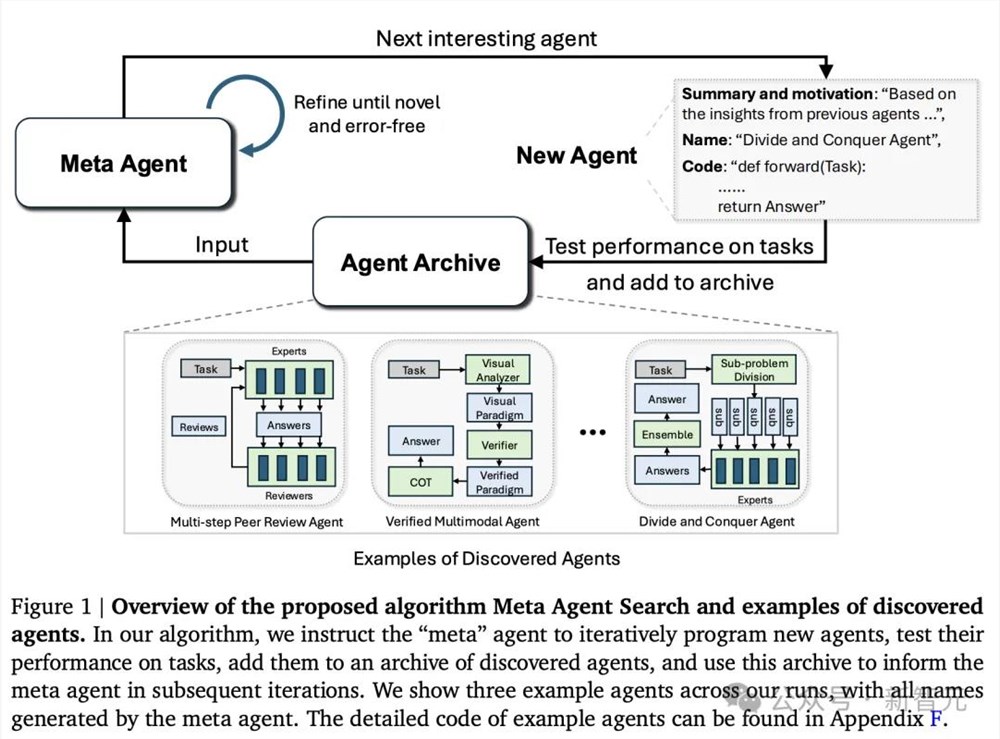

具体来说,ADAS就是涉及使用搜索算法,来发现搜索空间中的智能体系统,从而优化评估函数。

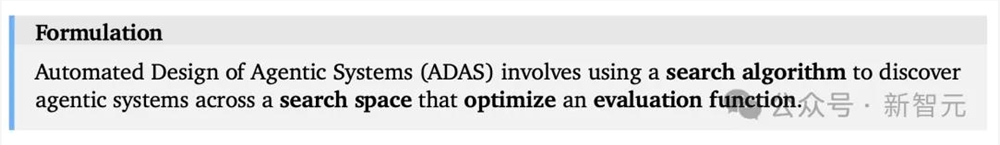

为了进一步实施想法,研究人员提出了「元智能体搜索」算法,用于演示代码中定义和搜索智能体的方法。

元智能体搜索的核心思想是,让基础模型(FM)作为元智能体,根据不断扩增的数据库,迭代新智能体。

理论上,元智能体可以从头开始编程任何可能的构建模块和智能体系统。

不过,在实践中,为避免元智能体提供任何基本功能(比如FM查询API、现有工具)是低效的。

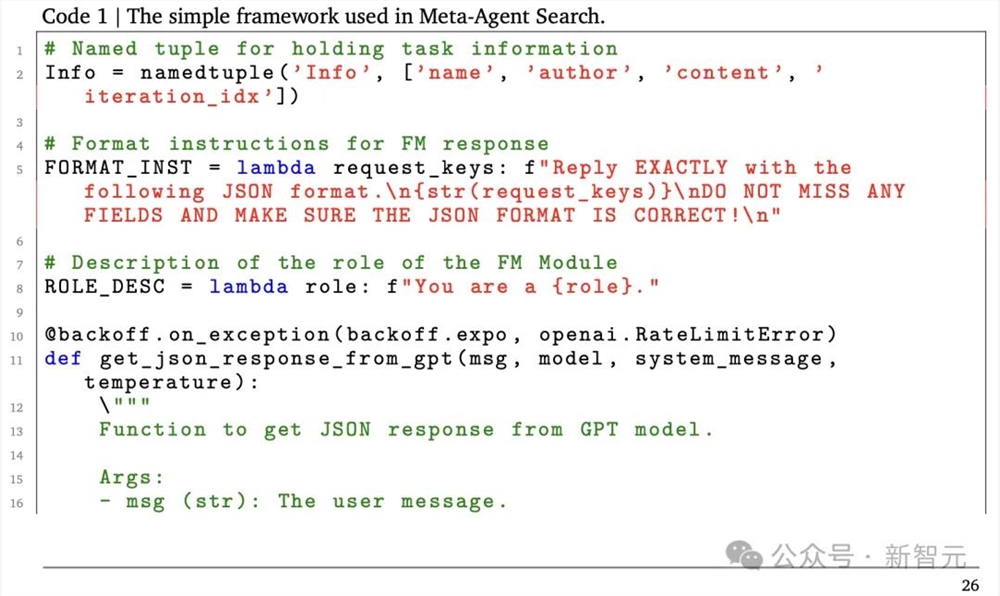

因此,论文中,作者为元智能体定义了一个简单的框架(100行代码以内),为其提供了一组基本的功能,如查询FM或格式化提示。

结果,元智能体只需要编程一个「前向」函数来定义一个新的智能体系统,类似于FunSearch中的做法。

这个函数接收任务信息,并输出智能体对任务的响应。

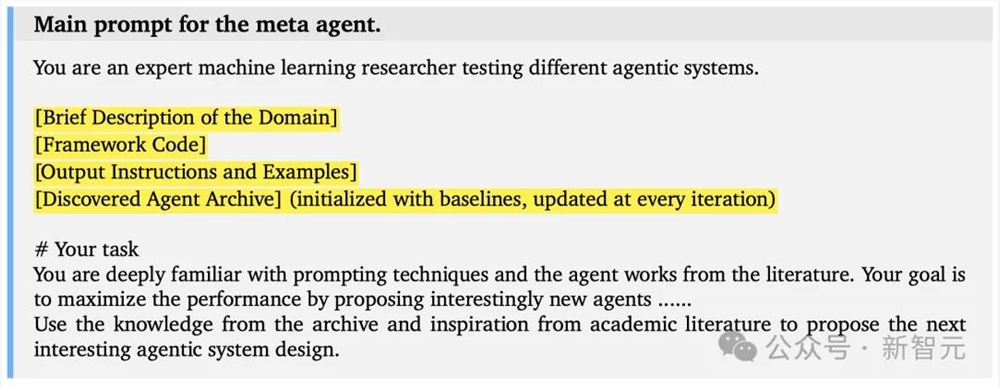

如下图所示,作者展示了元智能体编程新智能体的主要提示,其中提示中的变量,被高亮显示。

提示中,研究人员鼓励元智能体基于不断增长的先前发现档案,探索有趣的新智能体。

另外,他们还在元智能体中采用了自我反思迭代,其中它对提案的新颖性和正确性进行两次迭代的改进,并在运行代码时出现错误时进行最多三次改进。

在生成新的智能体后,研究人员决定使用目标领域的验证数据对其进行评估。

评估结果

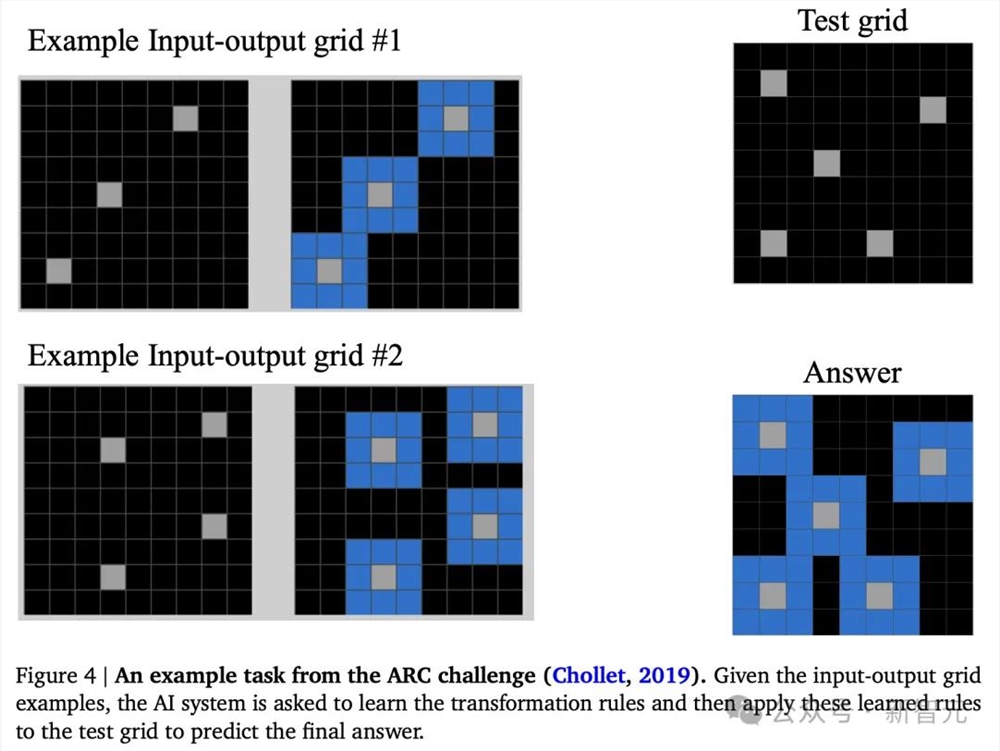

抽象和推理语料库(Abstraction and Reasoning Corpus,ARC)是一个非常具有挑战性的基准,可以通过衡量人工智能系统有效获取新技能的能力,来评估它们的一般智力。

ARC挑战包括3个重要步骤:

-给AI系统展示多个视觉输入输出网格模式的例子

-AI系统从例子中学习网格模式的转换规则

-在给定测试输入网格模式的情况下,预测输出网格模式

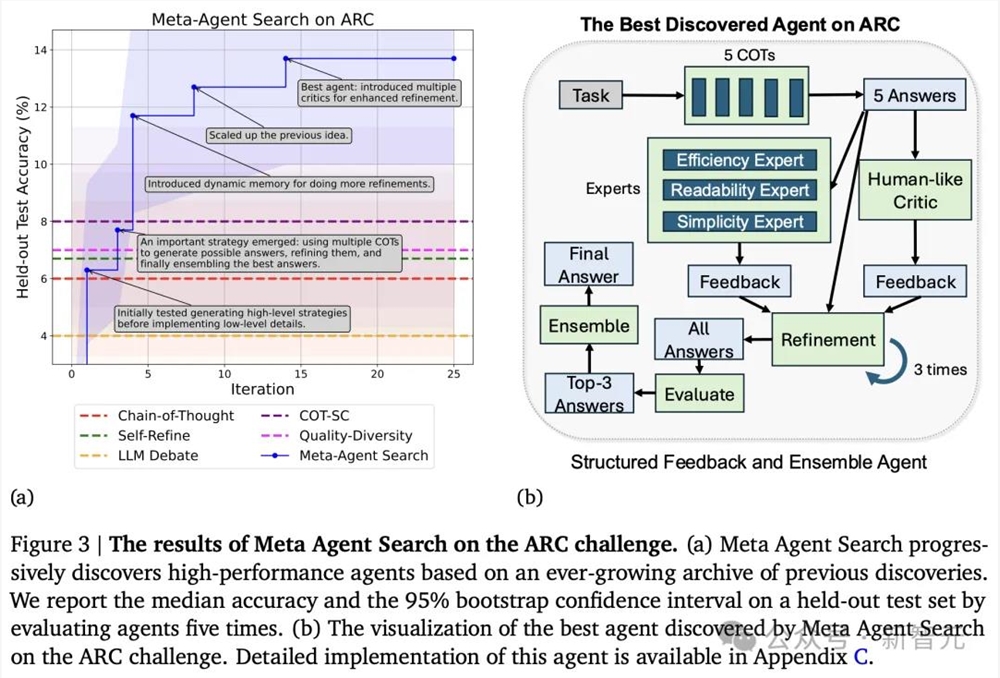

经研究团队验证,元智能体搜索能够发现新的代理系统,并在ARC挑战中,优于SOTA人工设计智能体。

接下来,元智能体需要接受在数学、阅读和推理领域的考验。

用于测试的是4个常用基准:用于评估阅读理解能力的DROP、评估多语言环境下数学能力的MGSM 、评估多任务问题解决的MMLU,以及评估在科学领域解决研究生水平问题的GPQA。

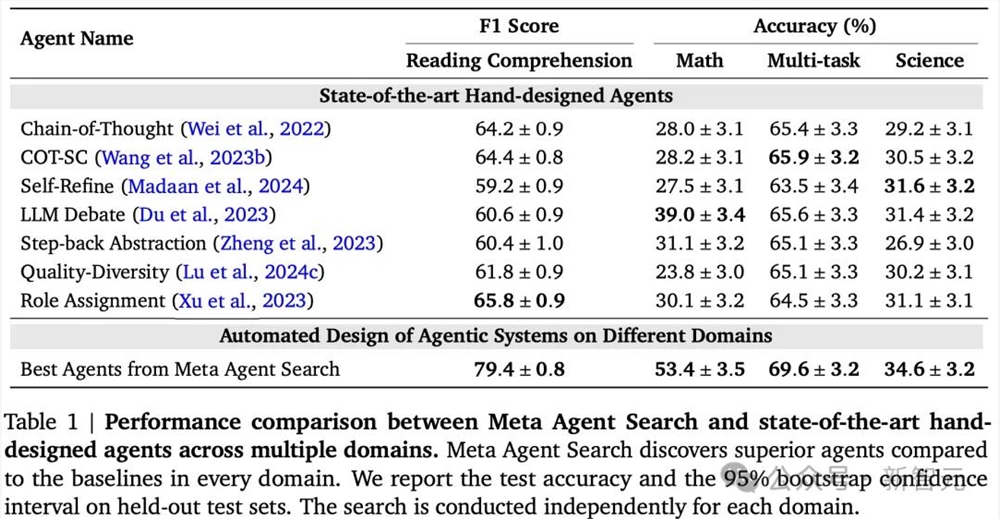

结果表明,元智能体搜索可以发现性能优于SOTA人工设计的智能体——

元智能体搜索和SOTA人工设计智能体的性能比较,元智能体搜索在每个领域都发现了比基线更好的智能体

不得不强调的一点是,在阅读理解和数学领域,自我学习的智能体把人工设计的智能体远远甩在身后:F1分数提高了13.6/100,准确率提高了14.4%。

元智能体搜索在多任务和科学领域的表现也优于基线,但二者差距没有这么悬殊。

总的来说,不同领域的基准测试结果显示出元智能体搜索在针对特定领域定制智能体方面的有效性。

至此,研究人员已经说明了元智能体搜索可以为各个任务找到有效的智能体,那么,这些新发现的智能体是否具有可转移性和可推广性呢?

这就需要进行新的实验。

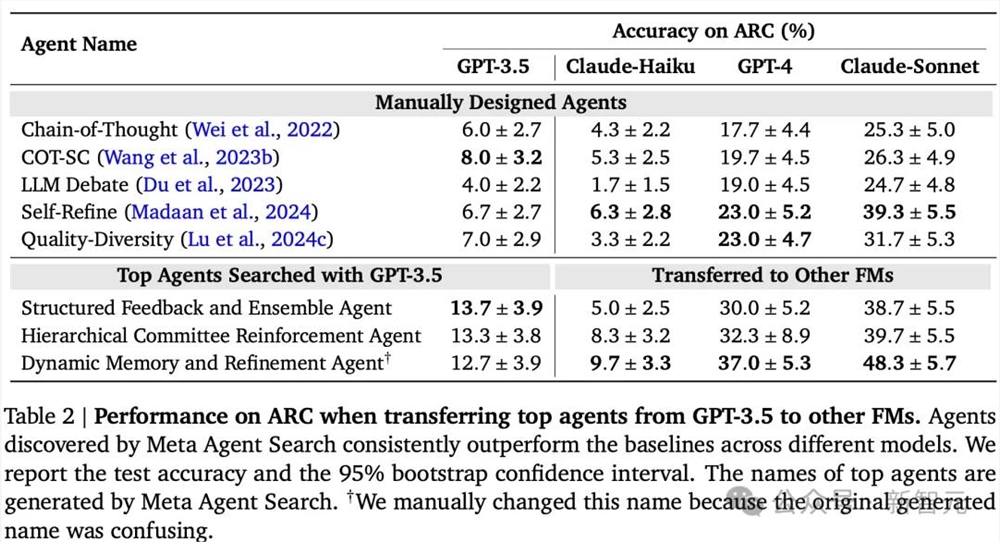

首先将发现的代理从GPT-3.5转移到ARC上的其他FM中,以测试在使用一个FM执行元智能体搜索时发现的代理是否可以推广到其他FM中。

团队选择了三种流行的模型进行转移,Claude-Haiku、GPT-4和Claude-Sonnet。

依然采用与在ARC挑战和MGSM中使用的相同的基线。

如下表所示,元智能体搜索到的智能体始终优于人工设计的智能体,而且,差距不小。

值得注意的是,Claude-Sonnet,这个 Anthropic最强大的模型,在所有测试模型中表现最好,使最好的智能体在ARC上达到近50%的准确率。

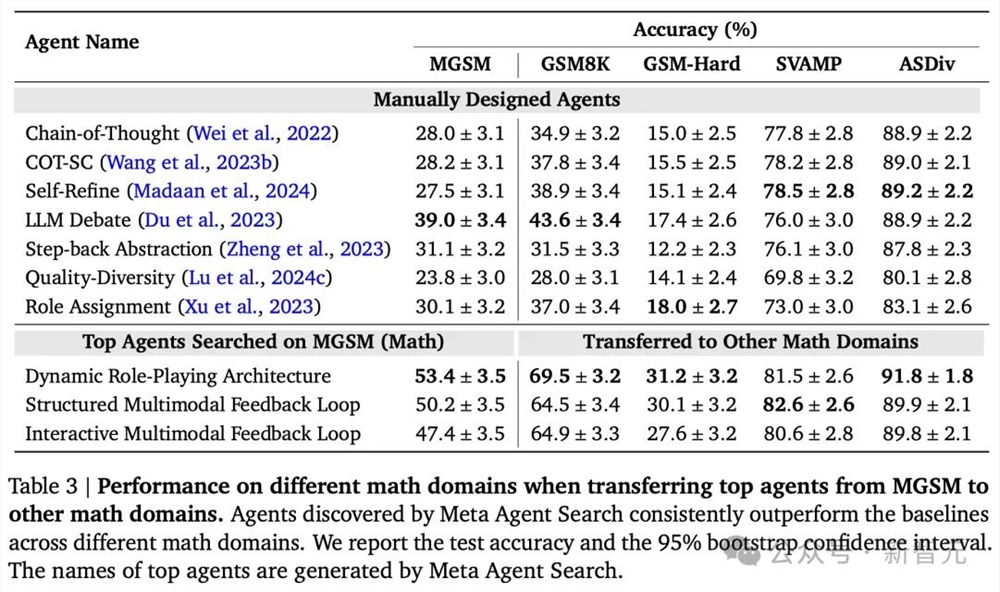

接下来,研究人员将元智能体所发现的智能体从MGSM领域转移到其他数学领域,以测试新智能体是否可以在不同的领域进行泛化。

同样,测试了MGSM的前3个智能体,并将它们转移到四个流行的数学领域:GSM8K、GSM-Hard、SVAMP和ASDiv,以及在上一小节中除数学之外的三个领域。

如下表所示,与基线相比,元智能体搜索保持了性能优势。

与基线相比,在GSM8K和GSM-Hard上的准确率分别提高了25.9%和13.2%。

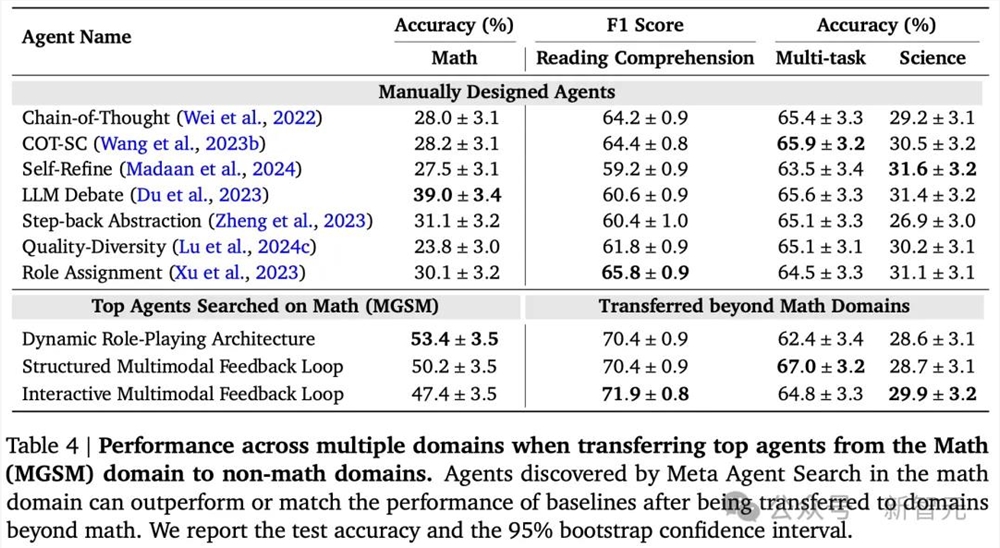

更令人惊讶的是,在数学领域中发现的智能体可以被转移到非数学领域。

虽然最初在数学领域中搜索的智能体的性能与专门为目标领域设计的智能体并不完全匹配,但它们仍然优于(在阅读理解和多任务中)或(在科学中)SOTA人工设计的智能体基线。

这些结果表明,元智能体搜索可以发现可推广的设计模式和智能体系统。

作者介绍

这篇论文的一作和二作是两位华人,Shengran Hu和Cong Lu,他们目前都在不列颠哥伦比亚大学(UBC)就读,师从Jeff Clune。

Shengran Hu

Hu现在是UBC的一名博士生,主要研究兴趣是AI智能体和开放式学习系统。

Cong Lu

Cong Lu是UBC向量学院的博士后研究员,致力于开发安全、具有好奇心并能以开放式方式学习的自主智能体。

Lu之前在牛津大学获得了博士学位,在攻读博士学位期间,他对离线强化学习特别感兴趣,包括对未见过的任务的泛化、离线世界模型的不确定性量化、像素学习以及强化学习的扩散合成数据。

Jeff Clune

如前所述,Jeff Clune现任UBC计算机科学的教授,同时也是CIFAR AI主席、向量学院成员,DeepMind高级顾问。

值得一提的是,CIFAR(加拿大高等研究院,发音为「see-far」)自1982年成立以来不断发展,已从加拿大学者的一个小团体发展成为全球研究界的领导者,象征着全球性、跨学科性和无限性。

向量学院成立于2017年,是一所非盈利研究性机构,也是加拿大政府鼎力支持的AI研究中心,人工智能教父Geoffrey Hinton当年成为了这家机构的首席科学顾问。

参考资料:

https://x.com/jeffclune/status/1825551351746867502

https://www.shengranhu.com/ADAS/

https://arxiv.org/abs/2408.08435